4월 11일 메타가 텍스트 기반 질문에 대해 AI 에이전트의 물리적 공간 이해 능력을 측정할 수 있는 OpenEQA 벤치마크를 공개했다.

OpenEQA는 AI 에이전트가 오픈 어휘 질문을 통해 환경을 조사해 이해도를 측정하는 새로운 벤치마크. OpenEQA에는 180개 이상 가정과 사무실 등 환경 데이터세트와 1,600종 이상 관련 질문이 포함되어 있어 AI가 이런 환경에서 물체를 얼마나 정확하게 인식하고 있는지 공간적‧기능적 추론 능력은 어느 정도인지 상식 등 지식을 어느 정도 보유하고 있는지 등을 철저히 검증할 수 있다.

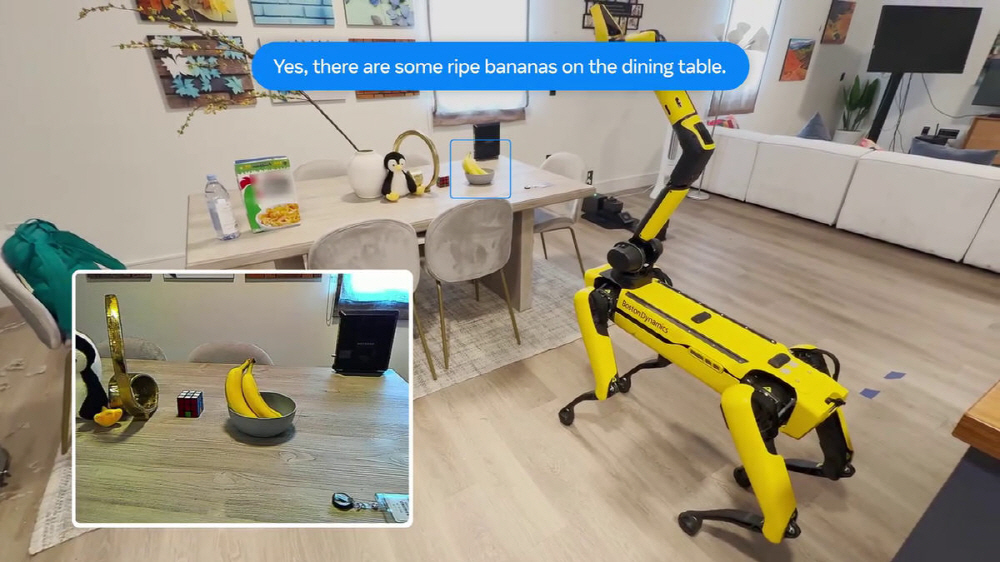

OpenEQA에는 에피소드 기억 EQA와 액티브 EQA 2가지 과제가 포함되어 있다. 에피소드 기억 EQA는 과거 경험을 기반으로 질문에 답변하는 것이며 액티브 EQA는 필요한 정보를 수집하기 위해 환경에서 행동을 취해 질문에 답변하는 것.

메타는 첨단 이미지와 텍스트를 복합적으로 다룰 수 있는 AI 모델(VLM)에 대한 OpenEQA 벤치마크 테스트 결과 가장 뛰어난 모델은 GPT-4V로 정확도가 55.35%였다고 보고했다. 반면 인간의 경우 정확도가 86.89%로 상당히 높아 AI와 인간 성능 사이에 여전히 큰 격차가 있다는 걸 보여주고 있다.

그 중에서도 공간 이해가 필요한 질문에선 최고 수준 VLM 모델도 사실상 가려진 상태라는 점이 흥미롭다. 메타는 이를 통해 시각 정보를 활용하는 모델이 실질적인 이점을 얻지 못하고 있음을 지적했다. 메타는 OpenEQA가 AI가 보는 세계를 이해하고 소통할 수 있도록 하는 추가 연구 동기가 되길 바란다고 밝혔다. 관련 내용은 이곳에서 확인할 수 있다.