유튜브 오리지널로 공개된 AI의 시대(THE AGE OF AI)에선 ALS 환자의 발음을 알아듣고 작동하는 음성 AI 도우미를 개발하는 프로젝트 유포리아(Project Euphoria)가 나온다. 근력이 쇠약해지는 ALS 환자에게도 이 같은 기술은 유용한 기술이지만 다른 한편으론 병이 진행되어 말을 할 수 없게 된 환자에게는 무용지물이다.

롤스로이스 연구기관인 알투데이터랩스(R²Data Labs)는 ALS 환자가 말을 잃어도 자신의 목소리로 주윙와 소통할 수 있게 해주는 AI를 연구하고 있다. 운동신경질환협회 MND와 인텔, 마이크로소프트의 지원을 받아 개발한 큅스(Quips)라는 AI 도구가 그것.

이 도구는 보이스뱅킹(voice-banking)이라고 명명한 기술에 AI를 결합해 ALS와 기타 MND 환자가 말하는 능력을 잃지 않은 상태에서 음성 샘플을 대량 취득하고 이를 기초로 억양이나 말버릇까지 본인과 흡사한 합성 음성을 만든다.

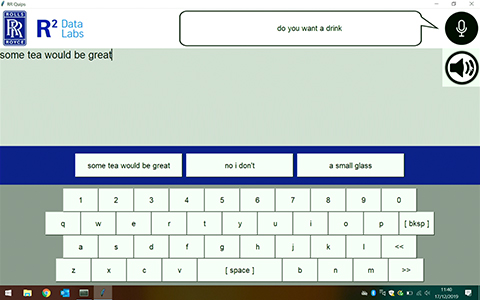

아직 초기 단계지만 이미 기존 방식 대화 시스템보다 실시간에 가까운 커뮤니케이션을 가능하게 해준다고 한다. 큅스는 환자의 대화 상대방 얘기를 듣고 화제를 해석하고 자동으로 회신 대안을 제시, 환자가 이를 고르면 자신의 목소리로 대답할 수 있게 해준다.

롤스로이스 측은 큅스가 예를 들어 직장이나 가정, 바 등 주위 환경에 따라 대화 패턴을 바꿀 수 있으며 속어까지 사용할 수 있다고 설명한다. 큅스가 앞으로 환자가 의사소통에 이용하는 도구로 임베디드 형태로 제공하고 싶다는 생각이지만 언제가 될지는 아직 알 수 없다. 관련 내용은 이곳에서 확인할 수 있다.