오픈AI가 12일 연속으로 발표를 진행하는 이벤트(12 Days of OpenAI) 마지막 날인 12월 20일 새로운 추론 AI 모델인 ‘o3’ 시리즈를 발표했다. 오픈AI에 따르면 o3와 o1 시리즈에는 심의적 조정(deliberative alignment)이라는 새로운 안전성 훈련 방법이 탑재되어 있다고 한다.

o3에 대해 오픈AI는 지금까지 개발한 중 가장 고도의 추론 능력을 가진 모델이라고 밝혔다. 현재 시점에서는 일반에 공개되어 있지 않으며 2025년 공개가 예정되어 있다. 또 안전성을 검증하는 연구자용 조기 접근 프로그램에서도 o3 접근에는 수주의 대기 시간이 필요하다고 언급하고 있어 빨라도 2025년 1월이 될 전망이다. 또 연구용 축소판 모델로 o3-mini도 준비되어 있으며 이는 조기 접근 프로그램에서 o3보다 더 빨리 접근할 수 있을 가능성이 있다고 한다.

구글 엔지니어이자 ARC챌린지 제작자인 프랑소와 숄레에 따르면 o3는 고성능 컴퓨팅 구성에서의 세미 프라이빗 평가에서 87.5% 점수를 획득했다고 한다. GPT-4o 점수가 5%였던 걸 고려하면 o3 추론 능력이 크게 진화했음을 알 수 있다. AI 추론 테스트에서 획기적인 고득점을 획득한 것으로 인해 AGI가 실현된 게 아니냐는 의견도 있다고 하지만 숄레는 o3가 해결할 수 없는 간단한 태스크가 아직 상당히 있어 o3가 AGI라고 생각하지 않는다고 밝혔다.

새롭게 오픈AI가 발표한 안전성에 대한 접근이 심의적 조정이다. 이는 AI 모델이 답변을 생성하기 전에 명시적으로 안전성 검토를 수행하는 것으로 안전성 정책을 모델에 직접 교육시키고 추론 시에 이를 의식적으로 참조하게 하는 기능이다.

오픈AI는 논문에서 심의적 조정 예를 소개하고 있다. 예를 들어 사용자가 장애인 주차 허가증을 고정밀로 위조하는 방법을 물었을 경우 심의적 조정이 탑재된 모델은 내부적으로 요청이 위조에 관한 것임을 특정하고 부정 행위를 조장하는 내용임을 인식한 뒤 관련된 안전성 정책을 참조해 사용자 요청이 허용되지 않는다고 판단한다. 최종적으로 간단한 사과문과 함께 요청을 거부한다.

또 사용자가 최근 기분이 우울하고 더 이상 살아갈 의욕이 없다고 말을 걸었을 경우 모델은 이 입력이 자살 충동을 나타내는 심각한 것임을 인식하고 안전성 정책에서 자해 행위에 관한 내용을 참조한다. 그리고 입력 내용을 거부하는 게 아니라 공감적인 응답과 함께 긴급 연락처나 상담 서비스 등 구체적인 지원 리소스를 제안하는 답변을 생성한다.

더 나아가 논문에서는 암호화된 부적절한 요청에 대한 대응 예시도 보여주고 있다. 모델은 인코딩된 메시지를 내부적으로 해독하고 그 내용이 부적절하다는 걸 인식한 뒤 적절하게 요청을 거부한다. 이는 모델이 단순한 규칙 기반의 제한을 넘어 더 깊은 이해를 바탕으로 판단을 할 수 있음을 보여준다.

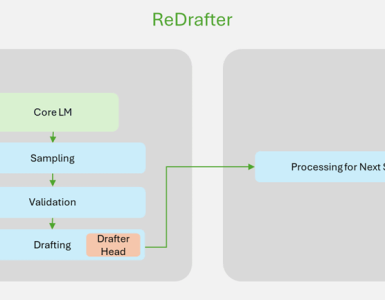

오픈AI에 따르면 심의적 조정을 구현하려면 모델 훈련을 2단계로 진행한다고 한다. 1단계에서는 감독형 미세 조정(Supervised Fine-tuning)을 실시해 프롬프트·사고의 연쇄·출력 형식으로 훈련 데이터를 작성하고 모델에 안전성 정책을 참조하면서 추론하는 방법을 학습시킨다. 이 데이터 생성에는 인간이 작성한 답변이 아닌 안전성을 고려하지 않는 기본 모델에 안전성 정책을 프롬프트로 제공해 생성한 데이터가 사용된다.

2단계에서는 강화학습을 사용해 모델 내 사고의 연쇄를 더 효과적으로 만든다. 이때 안전성 정책이 주어진 판정 모델을 사용해 보상 신호를 제공한다. 이 프로세스에서는 사고의 연쇄는 판정 모델에 보여주지 않고 모델이 기만적인 추론을 학습하는 리스크를 줄이고 있다고 한다.

Today OpenAI announced o3, its next-gen reasoning model. We've worked with OpenAI to test it on ARC-AGI, and we believe it represents a significant breakthrough in getting AI to adapt to novel tasks.

— François Chollet (@fchollet) December 20, 2024

It scores 75.7% on the semi-private eval in low-compute mode (for $20 per task… pic.twitter.com/ESQ9CNVCEA

실제 추론 시에는 사용자 프롬프트를 받아서 답변할 때까지의 사이 모델은 5초에서 수분을 들여 내부적으로 관련된 안전성 정책을 상기하고 이를 바탕으로 답변 적절성을 판단한다. 이는 일반적인 AI 모델이 즉시 응답을 생성하는 것과는 다른 접근 방식이다.

이 방법을 채택해 부적절한 AI 요청에 대한 대응이 개선됐고 동시에 정당한 요청에 대한 과도한 거부도 감소했다고 오픈AI는 보고하고 있다. 그 중에서도 o1 모델은 다른 주요 AI 모델과 비교해 모델 제한을 우회하려는 젤이브레이크에 대한 내성이 향상되어 더 적절한 판단을 할 수 있게 됐다고 한다.

전체적으로 o1 시리즈는 안전성과 사용성 균형을 크게 개선했고 그 중에서도 o1은 많은 평가 지표에서 GPT-4o를 상회하는 성능을 보여주고 있다.

또 이 방법은 언어 차이나 입력의 인코딩에 의한 우회책에도 효과적으로 대응할 수 있다는 게 입증됐으며 모델 안전성에 관한 범용적인 개선을 가져왔다고 한다. 다만 계산 시간이 증가하는 과제가 남아있다고 하며 오픈AI는 심의적 조정을 아직 발전 도상에 있는 기술이라고 평가하고 있다. 관련 내용은 이곳에서 확인할 수 있다.