딥페이크라고 하면 바로 떠올리는 건 AI가 사람 사진이나 동영상을 다른 사람 얼굴과 몸으로 바꾼 합성 이미지를 떠올릴 것이다. 예를 들어 인기 영화배우 얼굴을 다른 배우로 바꾼 장난을 하기도 한다. 그런데 이런 풍경 이미지를 그야말로 존재하지 않는 이미지로 만들어 버리는 딥페이크 이미지가 문제가 될 수 있다고 한다.

예를 들어 지리학자는 인공위성에서 지상을 촬영한 사진을 딥페이크로 위조되는 걸 우려하고 있다. 해외 어느 곳을 어떻게 홍수나 산불로 막대한 피해가 발생한 것처럼 보이게 하고 어쩐지 대규모 집회나 시위를 하고 있는 것처럼 가공하거나 확산되면 위성 이미지 전체 신뢰도가 손상되어 버릴 가능성이 있다. 과거에는 위성사진을 분석한 결과 위구르 수용소에 관한 보도가 이뤄지거나 한 적이 있지만 이것도 당사자가 정부에 가짜라고 말해 버리면 증거로 취급하는 게 어려워질 수 있다.

2019년 미군은 바로 이런 일이 일어날 가능성을 지적하고 있다. 예를 들어 진군 계획을 세우기 위한 지리적 계획 소프트웨어가 가짜 이미지 데이터로 교체되고 나면 작전의 중요한 포인트로 나타낸 다리를 향해 막상 출격했지만 다리가 아니라 함정이 되는 등 큰 문제가 발생할 수 있다.

이런 문제를 해결하기 위해 워싱턴대학 지리학 교수(Bo Zhao) 연구팀이 최근 딥페이크 지오그래피(Deep fake geography)라는 주제로 논문을 발표했다. 이 연구는 지리적 위성 영상 가짜 버전을 생성하거나 검색하기 위해 실시한 실험에 대해 기록하고 있다.

예를 들어 지도 제작자가 어렵게 만들어낸 지도를 타인이 복사해 이익을 차단해버리지 않게 워터마크 대신 몰래 없던 도롱놔 마을을 지도에 넣는 것 같은 일은 실제로 이뤄지고 있다. 또 새로운 기술은 새로운 과제도 만들어낸다. 딥페이크로 생성한 위성 영상은 정교하고 아마추어 눈에는 진짜로밖에 보이지 않는다고 설명한다. 위성 영상은 보통 정부기관이나 전문가 등 안정적 부서에 의해 만들어지는 것도 신빙성 높은 것으로 인식되는 요인이다.

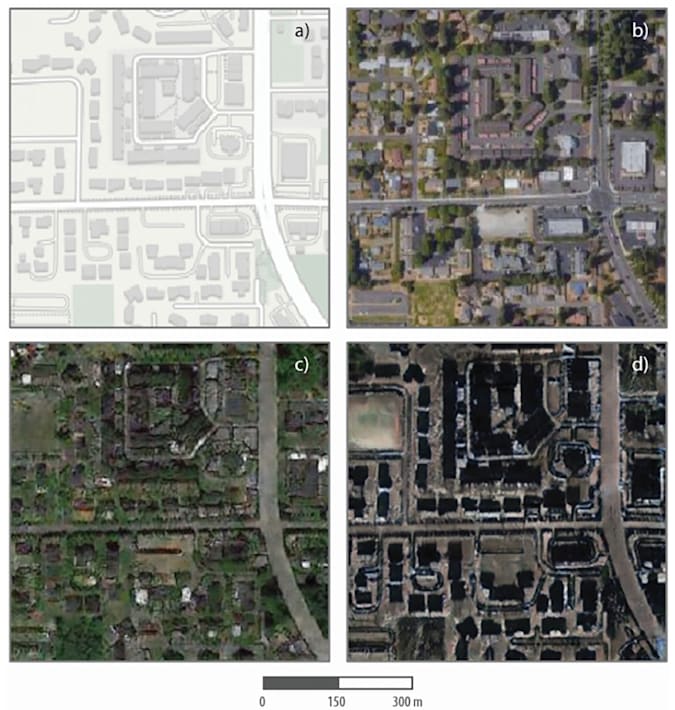

연구팀은 연구에서 적대적 생성 네트워크라는 AI 기법을 이용해 가짜 위성 이미지를 생성하는 소프트웨어를 개발했다. 또 학습한 영상 특성을 다양한 기반 맵에 주입해 지리적 딥페이크를 생성했다. 실험에선 워싱턴주 타코마 도로와 건물을 이용해 이를 베이징 고층빌딩군이나 시애틀 거리에 겹쳐 색조도 함께 만들었다. 생성 결과는 완벽할 정도는 아니지만 아무런 설명 없이 본다면 많은 이들이 실제로 이런 장소가 있다고 생각해버릴 수 있다.

사람의 얼굴을 바꾸는 딥페이크 기술이 실험실에서 밖으로 유출되어 악용되는 데에는 그리 오랜 시간이 걸리지 않았다. 이번 위성 딥페이크 이미지도 어딘가에서 장난으로 사용하기 시작하는 것도 시간문제일 수 있다. 관련 내용은 이곳에서 확인할 수 있다.