러시아 모스크바에 위치한 삼성전자 인공지능센터와 러시아 스콜코보과학기술연구소가 기존 3D 모델링 같은 기법을 이용하지 않고 이미지에서 곧바로 사람이 말하는 애니메이션을 생성할 수 있는 모델을 개발했다. 이 기술은 앞으로 게임이나 화상회의 등에 이용할 디지털 아바타 응용을 기대할 수 있다.

이 모델은 이미지 여러 장을 바탕으로 훈련을 실시해 새롭게 인간이 대화하는 것 같은 영상을 생성해준다. 예를 들어 사진 8장을 모델로 연구해 대화 영상 바탕이 되는 걸 입력하면 원래 영상에서 눈썹이나 눈, 코, 입, 턱 라인만으로 이뤄진 프레임을 추출해 학습한 이미지에 프레임 움직임을 더해 새로운 대화 신호를 생성하는 것이다.

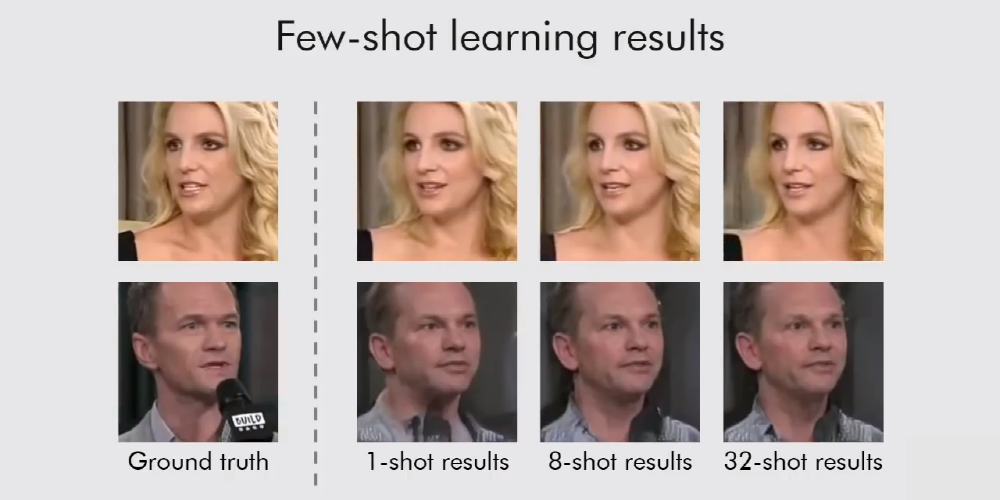

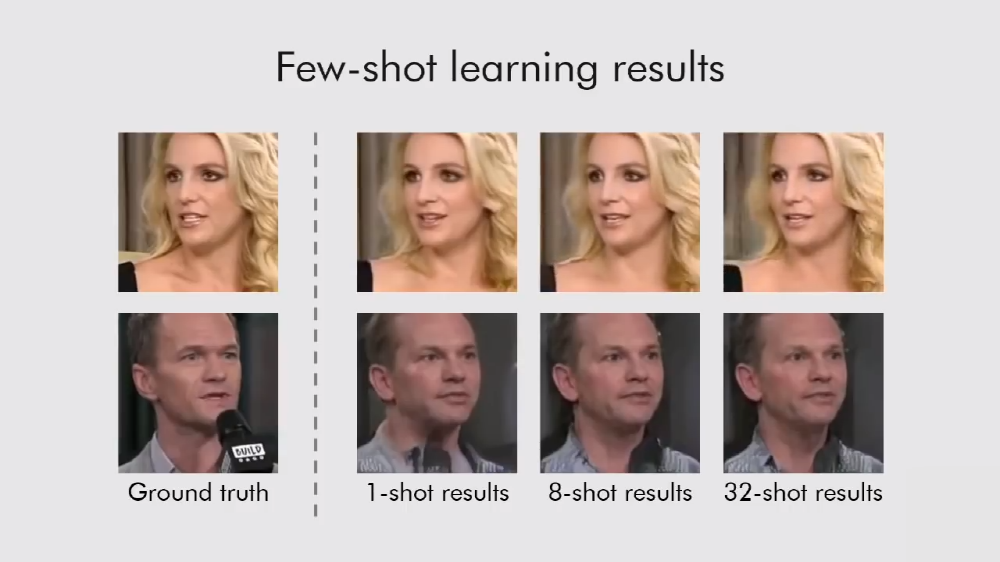

기존 모델은 방대한 이미지 데이터를 통한 훈련이 필요했지만 이번에 개발한 모델은 사진 단 1장만으로도 애니메이션을 생성할 수 있다. 물론 8장이나 32장 등 훈련 데이터를 늘릴수록 애니메이션 움직임은 더 자연스러워진다. 하지만 움직임 자체에는 큰 차이가 없고 1장으로도 꽤 자연스러운 회화 애니메이션을 생성할 수 있다고 한다.

학습 단계에선 임베디드 네트워크와 생성 네트워크, 변별 네트워크 3가지 신경망을 대규모 영상 데이터셋을 통해 훈련한다. 이은 이미지샷 학습에선 생성 네트워크와 변별 네트워크 매개변수를 고유 방법으로 초기화해 몇 장이나 1장 이미지 등에 따라 수천만 개 파라미터를 조정하고 빠르게 훈련을 하게 된다.

사진 몇 장만 있으면 얼굴 부분 프레임에 맞춘 부드러운 대화 애니메이션을 만들 수 있고 셀카로 찍은 프레임을 바탕으로 새로운 회화 애니메이션을 만드는 것도 가능하다. 이미지 데이터 1장에서도 애니메이션 생성을 할 수 있다. 예를 들어 마릴린 먼로와 달리, 아인슈타인 등 위인 인물 사진끼리 자유롭게 대화하는 애니메이션을 만들 수도 있다는 얘기다. 관련 내용은 이곳에서 확인할 수 있다.