메타가 차세대 AI 모델 Llama 4 시리즈를 정식으로 발표했다. Llama 4 시리즈는 성능, 규모, 응용 범위가 다른 여러 모델로 구성되어 있으며 이전 세대보다 대폭 성능이 향상되어 경쟁사 AI 모델에 견줄 만한 성능을 갖추고 있다. 가장 큰 특징은 MoE(Mixture of Experts)라고 불리는 효율적인 모델 아키텍처와 새롭게 개발된 사전 학습 방법에 있다.

Llama 4 시리즈는 네이티브 멀티모달 모델로 텍스트 뿐 아니라 이미지나 동영상과 같은 여러 정보 형식을 처음부터 통합적으로 다룰 수 있도록 설계됐다. 또 MoE 아키텍처를 통해 전문가라고 불리는 각 작업에 최적화된 전문 모델만을 선택적으로 작동시켜 자원 낭비를 줄이면서도 고성능을 유지하는 설계가 됐다.

더불어 Llama 4 기반 기술에는 iRoPE(Improved Rotary Position Embeddings)라는 새로운 위치 임베딩 방법과 MetaP(Meta’s Progressive Pretraining)라는 새로운 사전 학습 전략 등 많은 혁신이 더해졌다. 메타는 이런 새로운 기술이 모델 확장성과 정확도, 안정성을 높이기 위해 설계됐으며 Llama 4 성능 향상에서 핵심이 되고 있다고 강조했다.

먼저 iRoPE는 기존 RoPE(Rotary Position Embedding) 개선 버전으로 긴 문맥 처리에서의 정확도 저하를 완화하기 위한 것이다. RoPE는 토큰 순서 정보를 트랜스포머에 통합하기 위해 사용되지만 긴 입력에서는 성능이 저하되는 것으로 알려져 있다. iRoPE는 이 문제에 대응하기 위해 스케일링과 토큰 간 상관관계 안정화가 이뤄져 있어 긴 코드나 문서, 대화 기록을 대상으로 하는 상황에서도 정확도 높은 출력을 얻을 수 있게 됐다.

MetaP는 Llama 4 사전 학습을 더 안정적이고 효율적으로 수행하기 위해 모델 스케일업 과정에서의 학습 어려움에 대처하는 학습 방법이다. MetaP는 학습 초기에 더 작은 규모 모델이나 간단한 데이터세트를 사용하고 단계적으로 모델 크기나 데이터 복잡성을 확장해 나가 안정적인 수렴과 고성능 최종 모델을 실현한다. 메타는 MetaP를 통해 통합적인 이해와 추론이 가능한 멀티모달 모델 실현에 성공했다고 밝혔다.

또 일반적인 MoE에서는 전문 모델 선택에 편향이 생기기 쉽다는 과제가 있었지만 Llama 4에서는 토큰별 전문가 선택에서의 다양성과 균형을 제어하는 새로운 라우팅 기구가 도입됐으며 이게 높은 정확도와 효율을 양립하는 요인이 되고 있다.

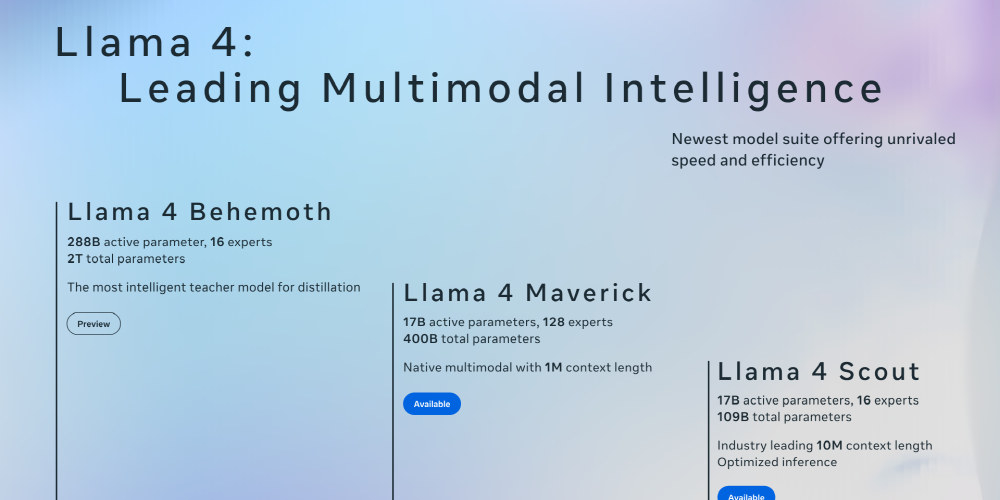

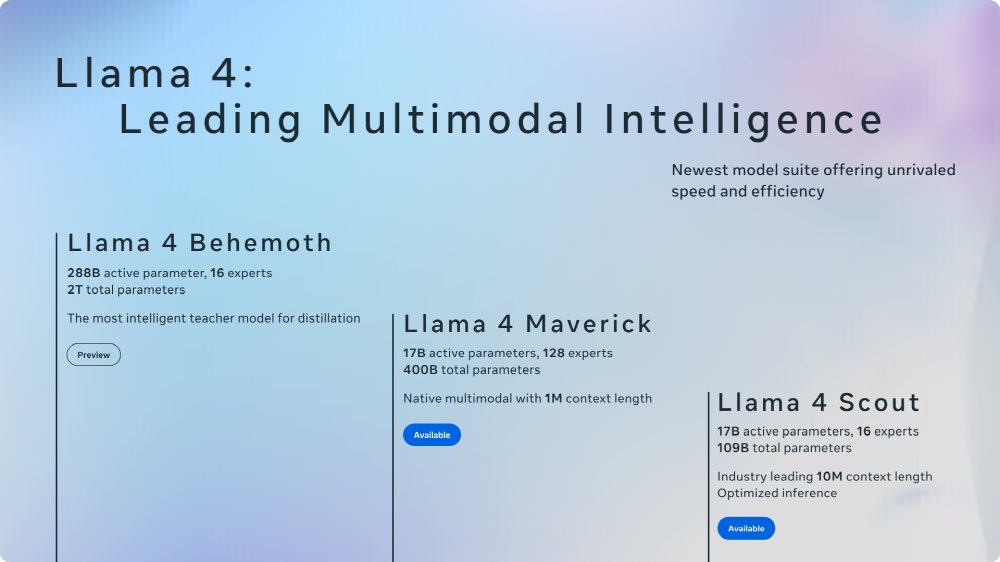

현재 Llama 4 시리즈에는 3가지 모델(Llama 4 Scout, Llama 4 Maverick, Llama 4 Behemoth)이 존재한다. 3개 모델 중 최소 구성인 Llama 4 스카우트는 170억 개 활성 파라미터를 가지며 16개 전문가를 탑재했다. 총 파라미터 수는 1,090억 개로 단일 엔비디아 H100 GPU에서도 작동 가능한 경량 모델이면서도 1,000만 토큰이라는 긴 컨텍스트 윈도를 지원한다. 더불어 젬마3, 제미나이 2.0 Flash-Lite, 미스트랄 3.1 같은 경쟁 모델을 능가하는 성능을 갖고 있다고 메타는 주장했다. Llama 4 스카우트는 그 중에서도 이미지 인식과 문장 연결 기능이 뛰어나다고 한다.

Llama 4 매버릭은 170억 개 활성 파라미터를 가지며 128개 전문가를 탑재했다. 총 파라미터 수는 4,000억 개로 단일 엔비디아 DGX H100에서 실행 가능하다. 더 고급 추론과 코딩 작업에 특화되어 있으며 오픈AI GPT-4o나 DeepSeek-V3와 동등 이상 정확도를 더 적은 계산 자원으로 달성하도록 설계됐다.

다만 보도에선 벤치마크에 사용된 Llama 4 매버릭이 일반에 공개된 것과는 다른 대화용으로 조정된 실험용 버전이었다는 점에서 LM Arena 등 평가 플랫폼에서 보여준 성능이 실제로 개발자나 일반 사용자가 이용할 수 있는 모델과 일치하지 않을 가능성이 있다고 지적했다. 실제제로 LM Arena 버전 매버릭은 과도한 이모티콘 사용이나 중복된 응답 경향이 관찰됐으며 일반 버전과는 명백히 다른 행동을 보인다고 연구자가 보고했다.

최상위 모델인 Llama 4 비히머스는 2,880억 개 활성 파라미터와 16개 전문가를 탑재했으며 총 파라미터 수가 2조에 달하는 거대 모델이다. 메타에 따르면 이 모델은 STEM 분야 벤치마크에서 GPT-4.5나 클로드3 소넷을 상회하는 성적을 기록했으며 그 중에서도 수학, 프로그래밍, 과학계 문제에서 높은 정확도를 발휘한다고 한다. 하지만 현재 시점에서는 아직 훈련 중이며 출시되지 않았다.

Llama 4 시리즈는 200개 이상 언어를 지원하며 이전 세대 Llama 3와 비교해 다국어 토큰이 10배 증가했다. 또 정치적, 사회적 논의가 많은 주제에 대한 거부율이 크게 감소했으며 편향 완화를 위한 노력도 진행 중이라고 메타는 밝혔다.

이들 새 모델은 메타 AI 어시스턴트에 순차 통합될 예정이며 현재 왓츠앱, 메신저, 인스타그램, 웹브라우저 버전 메타AI에서 이용 가능하다. 또 Llama 4 스카우트와 Llama 4 매버릭은 llama.com 또는 허깅페이스에서 공개되어 있으며 향후 연구 커뮤니티를 위한 연구용 모델 접근도 제공할 예정이다. 관련 내용은 이곳에서 확인할 수 있다.