애플 연구팀이 오픈소스 언어 모델인 오픈ELM(Open-source Efficient Language Models)을 공개했다. 공개된 모델에는 애플 기기에서 작동할 수 있도록 변환하는 코드도 준비되어 있어 언어 모델을 애플 기기 상에서 로컬에서 실행시킬 수 있게 됐다.

공개된 오픈ELM에는 파라미터 수 2억 7,000만인 270M, 4억 5,000만인 450M, 11억인 1_1B, 30억인 3B 4가지 모델이 준비되어 있다. 오픈AI GPT-4, 앤트로픽 클로드 3, 메타 LLaMA 3과 비교하면 오픈ELM은 비교적 소규모 모델이지만 소규모이기 때문에 실행 비용이 낮고 스마트폰이나 노트북에서도 작동하도록 최적화되어 있다.

오픈ELM 특징 중 하나는 트랜스포머(Transformer) 각 레이어에서 파라미터 수를 변화시켜 모델 전체 파라미터를 효율적으로 배분하는 기법(layer-wise scaling)을 채택했다는 점이다. 구체적으론 입력에 가까운 레이어에선 어텐션과 피드포워드를 위한 잠재 파라미터 차원을 작게 하고 출력에 가까워질수록 점점 레이어를 넓혀가게 된다. 이렇게 하면 제한된 파라미터 수 안에서 각 레이어에 적절한 수 파라미터를 할당할 수 있다. 기존 언어 모델에선 모든 레이어에서 동일한 설정을 갖는 게 보통이었지만 이 기법을 통해 레이어마다 다른 설정을 하고 파라미터를 보다 효과적으로 활용할 수 있게 됐다.

연구팀에 따르면 공개 데이터세트로만 학습한 결과 오픈ELM은 비슷한 파라미터 수 오픈 모델과 비교해 높은 정확도를 달성했다고 보고했다. 예를 들어 11억 개 파라미터를 가진 오픈ELM은 12억 개 파라미터를 가진 OLMo라는 모델에 비해 필요했던 학습 데이터량이 OLMo 절반이었음에도 불구하고 정확도는 2.36% 높았다고 한다.

또 언어 모델에 특정 태스크를 수행하라는 지시를 내리고 해당 태스크에 특화된 학습을 하는 지시 미세조정(Instruction Tuning)을 적용하면 오픈ELM 정확도가 1~2% 향상된다고 한다. 연구팀은 지시 미세조정을 적용하면 오픈ELM이 일반적인 언어 이해 능력 뿐 아니라 특정 태스크에서의 성능도 향상된다고 보고했다. 더불어 오픈ELM은 LoRA(Low-Rank Adaptation)나 DoRA(Decomposed Low-Rank Adaptation) 등 파라미터 효율이 좋은 파인튜닝 방법도 적용할 수 있게 되어있다고 한다.

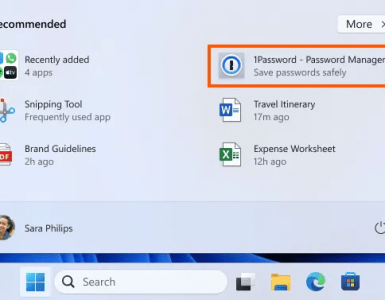

더불어 학습한 모델을 애플 MLX(Machine Learning Accelerator) 라이브러리로 변환하는 코드도 제공되고 있다. 다시 말해 학습된 오픈ELM 모델을 아이폰이나 아이패드 같은 애플 기기에서 효율적으로 동작시킬 수 있게 된 것이다.

오픈ELM은 오픈소스로 개발됐으며 온라인 AI 플랫폼인 허깅페이스에 리포지토리가 호스팅되어 있다. 연구팀은 오픈ELM 재현성과 투명성을 확보하기 위해 오픈ELM 모델 가중치뿐 아니라 학습 코드와 학습 로그, 다수 체크포인트, 모델 학습에 사용된 공개 데이터세트, 학습에 대한 상세한 하이퍼파라미터, MLX 라이브러리로 변환하는 코드 등도 제공하고 있다.

애플이 오픈ELM을 앞으로 어떻게 전개해 나갈지는 밝히지 않았지만 보도에선 이메일 문안 작성 등 텍스트 관련 태스크를 애플 기기 상에서 효율적으로 수행할 수 있을 것으로 기대하고 있다. 관련 내용은 이곳에서 확인할 수 있다.