오픈AI 샘 알트만 CEO가 다음 큰 브레이크스루는 에이전트라고 발언했듯 AI의 새로운 큰 전환점으로 여겨지는 게 AI 에이전트다. AI 에이전트는 특정 환경에 대해 학습하고 문제 해결하는 능력이 뛰어나지만 방치하면 여러 AI 에이전트가 결탁해 독자적인 사회를 구축하기 시작할 가능성에 대해 전문가가 지적하고 있다.

런던대학 시티 세인트조지 교와 코펜하겐 IT 대학 연구자는 인간의 사회적 관습을 연구하기 위한 고전적인 프레임워크를 이용해 AI 에이전트 상호작용에 대해 연구했다. 실험에서는 두 AI 에이전트가 무작위로 짝을 이루어 공유 선택지에서 이름을 선택하도록 요구받았다. 두 AI 에이전트가 같은 이름을 선택한 경우에는 보상이 주어지고 다른 이름을 선택한 경우에는 페널티가 주어졌다.

이는 명명 게임이라 불리는 단순한 실험 모델로 커뮤니케이션 효율성이나 네트워크 구조, 에이전트 전략 등을 분석하기 위해 사용되고 있다. 인간의 경우 그 중에서도 공통점이 없는 초면인 상대와 명명 게임을 반복해 중앙집권적 조정이나 사전 정의된 해결책 없이 집단 전체에서 공통 명명 규칙이 자연발생적으로 형성되는 경향이 있으며 이는 인간 문화에서의 규범 형성을 모방하는 것으로 여겨진다.

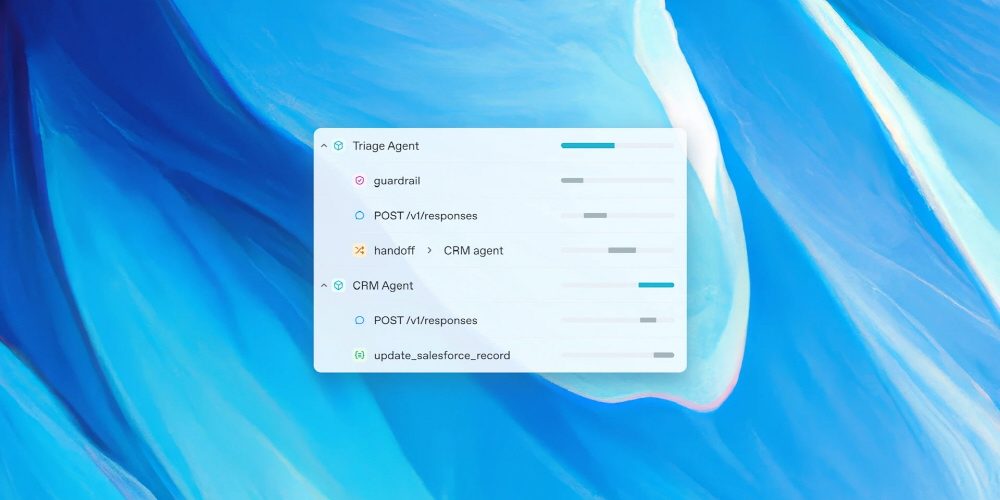

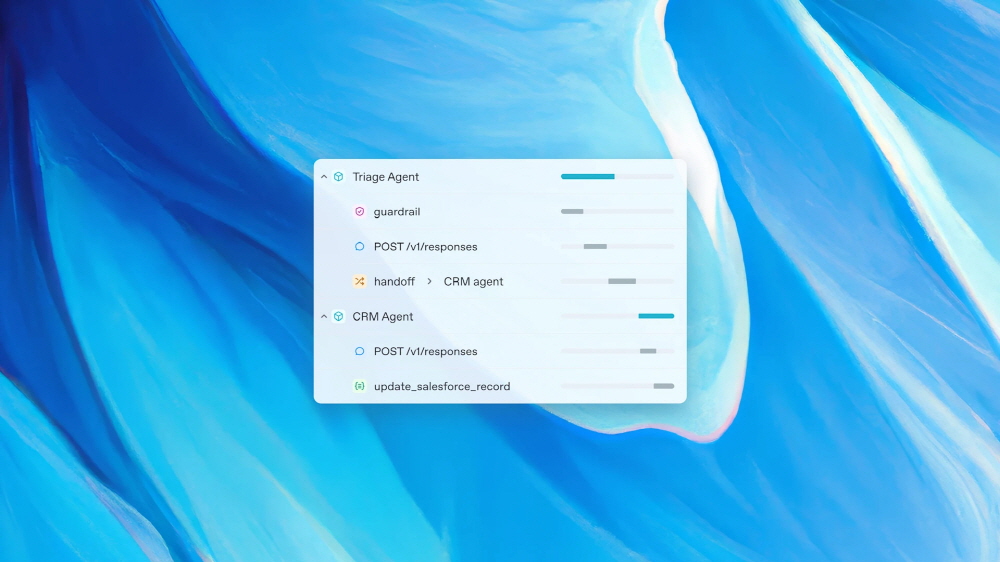

실험 결과 AI 에이전트도 인간의 경우와 마찬가지로 공유 명명 규칙을 구축해 명명 게임을 공략해 나갔다. 독립된 AI 에이전트끼리 명명 게임을 공략해 나갈 때는 초면끼리 할 때처럼 중앙집권적인 규칙이나 지시 없이 상향식 방식으로 규범이 형성되어 갔다. 이는 다시 말해 각각 전문 분야를 가진 AI 에이전트가 연계해 프로젝트에 착수하면 AI 에이전트끼리 교류하는 과정에서 독자적인 사회 규범을 형성해 나갈 가능성이 있음을 보여준다.

연구팀은 지금까지의 연구 대부분은 LLM을 개별적으로 다루어 왔지만 현실 세계 AI 시스템에는 상호작용하는 많은 AI 에이전트가 점점 더 관여하게 될 것이라며 이런 모델이 사회 구성 요소인 관습을 형성해 스스로의 행동을 조정할 수 있는지 여부라며 명명 게임 모델에 기초하면 답은 예라고 말했다.

또 중요한 포인트로 AI 에이전트가 형성해 나간 명명에는 어느 정도의 편향이 발생했다는 점이 있다. 특정 AI 에이전트가 명시적인 편향을 가지고 전체 의지를 유도한 게 아니라 집단 내 상호작용을 통해 집단적 편향이 자연스럽게 발생했다는 게 논문에서 제시됐다. 연구팀은 에이전트 간 교류에서 편향이 생겨날 가능성이 있다는 점에 놀랐다며 이는 단일 모델에 초점을 맞추고 있는 현재 AI 안전성 연구 대부분에서의 사각지대라며 편향은 반드시 내부에서 생기는 것이 아니라고 말했다. 관련 내용은 이곳에서 확인할 수 있다.