미국 경찰이 AI로 생성한 소녀 이미지를 사용해 성범죄자를 체포하는 함정 수사를 하고 있다고 보도됐다. 수사 과정에서 온라인 커뮤니케이션 서비스 스냅챗에서 부적절한 모더레이션이 있었을 가능성이 제기되고 있다.

지난 9월 5일, 뉴멕시코 주 법무장관이 스냅챗을 상대로 소송을 제기했다. 뉴멕시코 주에 따르면 스냅챗 알고리즘은 아동 성적 학대 콘텐츠(CSAM)를 유통시키려는 이들에게 편리하게 설계되어 있어 CSAM을 다루는 계정이 알고리즘을 통해 만나고 연결될 수 있다고 한다.

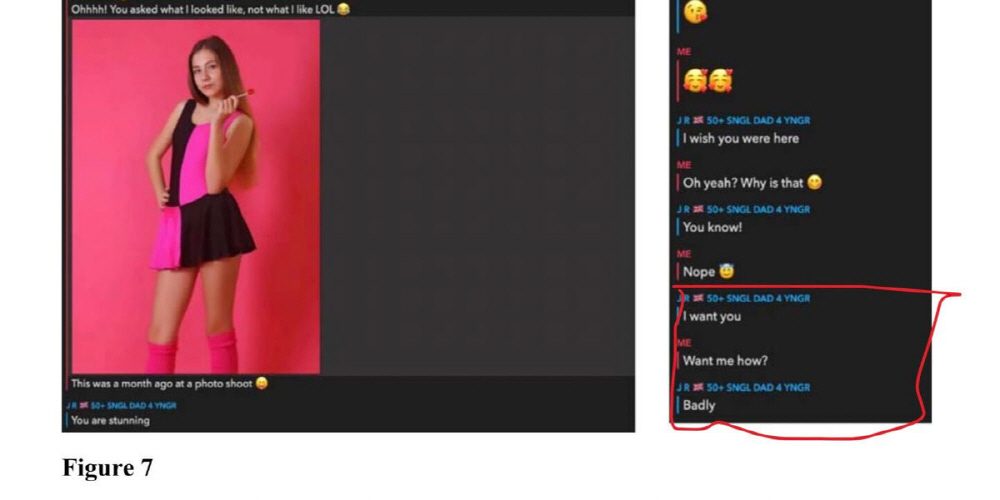

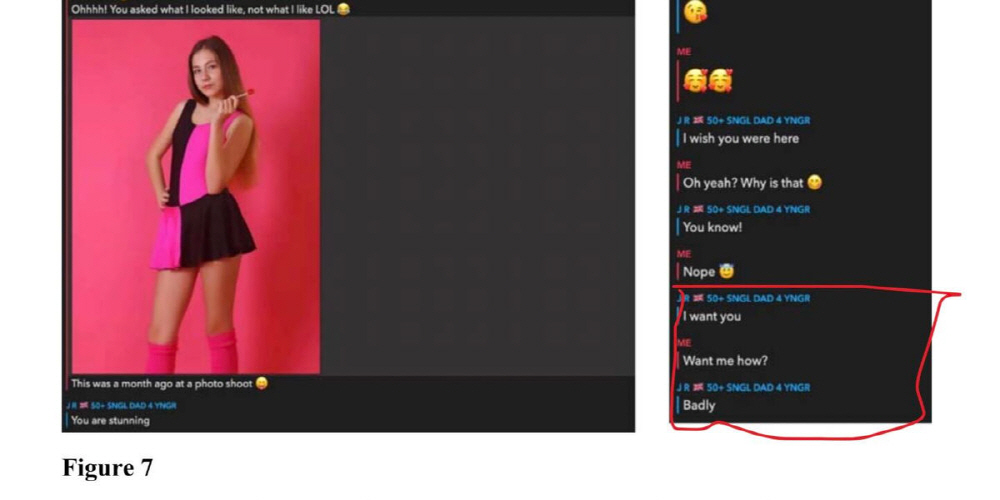

뉴멕시코 주 사법 당국이 14세 소녀로 가장한 계정을 만들어 함정 수사를 실시한 결과 해당 계정은 팔로워를 적극적으로 늘리지 않았음에도 불구하고 곧 child.rape나 pedo_lover10 같은 계정이 추천되기 시작했다고 한다.

그리고 함정 계정이 단 하나 계정으로부터의 팔로 요청을 수락한 결과 추천은 더 악화되어 CSAM을 포함하거나 CSAM을 교환하려는 다수 성인 사용자와도 연결되기 시작했다고 한다. 사법 당국은 계정 생성을 위해 AI를 사용했다고 한다.

또 함정 계정이 성적으로 노골적인 언어를 사용하지 않았음에도 CSAM이 표시된 것에 대해 다른 10대 사용자를 검색하는 행위를 CSAM을 찾는 행위로 스냅챗이 간주하고 있음이 틀림없다고 사법 당국은 지적했다.

뉴멕시코 주 법무장관은 이런 알고리즘이 CSAM 공유를 촉진하고 아동 성적 착취를 진행시키고 있다며 스냅챗에 시정을 요구했다.

조사에 따르면 실제로 스냅챗에서 대화를 나눈 결과 피해를 입은 아동이 많이 있으며 2023년에만 1만 건 이상 CSAM 관련 기록이 발견됐다고 한다. 그 중에는 13세 미만 미성년자가 성적 폭행을 당했다는 정보도 포함되어 있었다. 과거에는 스냅챗 기능을 통해 알게 된 11세 소녀를 강간해 18년 징역형을 선고받은 사람도 있었다고 한다.

이번 사법 당국 발표에 대해서는 수사가 진전되고 플랫폼이 건전해지는 걸 환영하는 목소리도 있지만 AI로 아동 이미지를 생성했다는 점을 우려하는 목소리도 있다. 성범죄를 전문으로 하는 변호사는 AI가 생성한 이미지가 실제 아동 학대를 묘사하는 것 같다면 유해하다고 할 수 있다며 AI로 함정 수사를 하는 건 실제 아동 이미지를 사용하는 것보다 문제가 적기 때문에 더 윤리적이라고 생각할 수 있지만 용의자가 함정 수사에 의해 범죄를 저지르도록 유도됐다고 말하면 자신을 방어할 수 있다는 또 다른 문제도 발생한다고 말했다. 관련 내용은 이곳에서 확인할 수 있다.