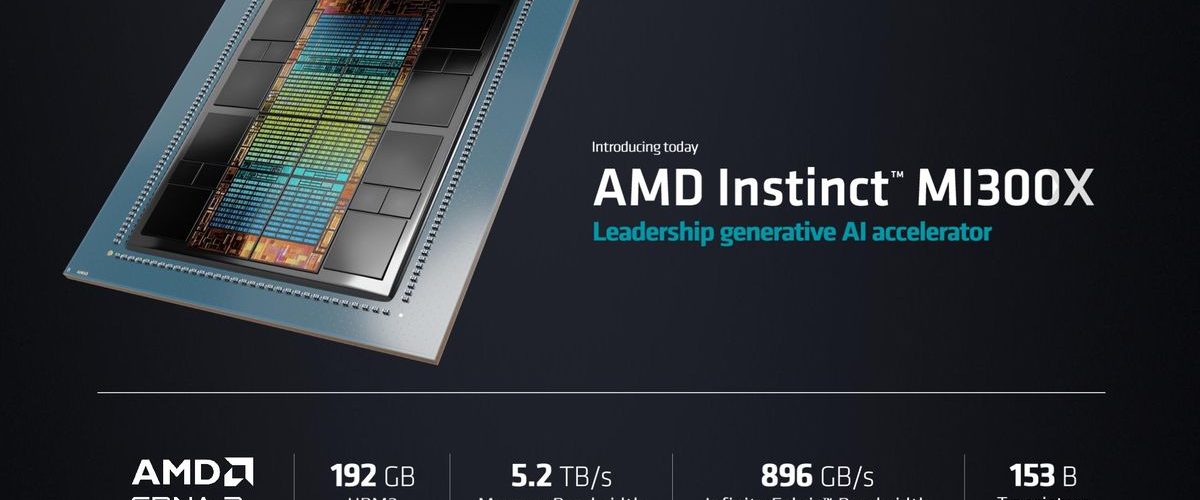

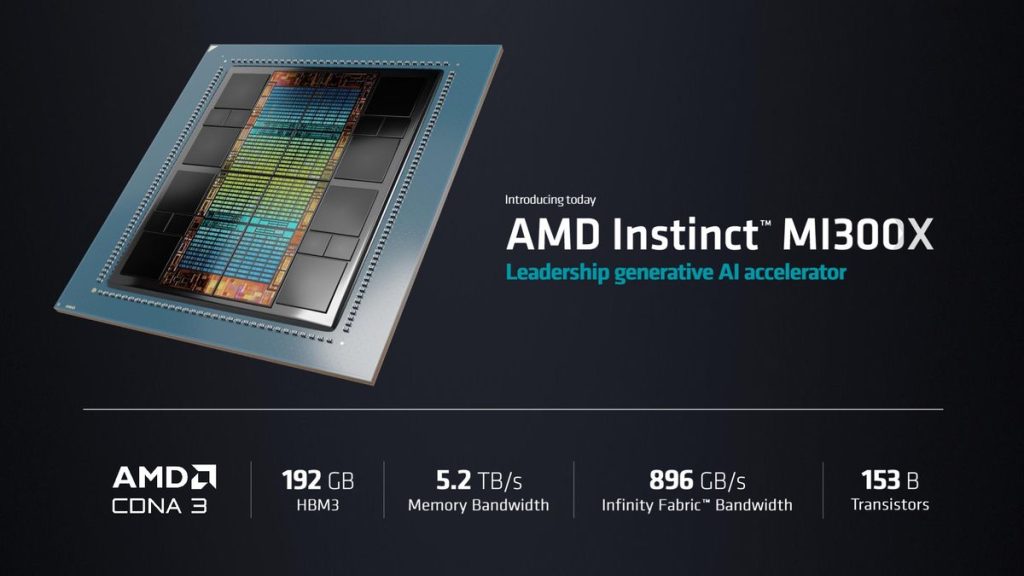

AMD는 6월 13일 AI에 사용되는 대규모 언어 모델 학습용으로 설계된 가속기인 AMD 인스팅트 MI300X(AMD Instinct MI300X)를 발표했다. MI300X는 CPU 타일과 GPU 조합이 아니라 GPU 타일만 이용해 최대 192GB HBM3 메모리를 지원한다.

AMD는 6월 13일 개최한 이벤트(Data Center and AI Technology Premiere) 중 차세대 고성능 CPU나 AI 가속기 솔루션을 시장에 투입하기 위해 AWS나 허깅페이스, 메타, 마이크로소프트 애저 등과 기술적 파트너십을 맺은 걸 발표한 것.

또 리사 수 AMD CEO는 AI는 차세대 컴퓨팅을 형성하는 결정적 기술이며 솔직히 말해 AMD의 가장 크고 가장 전략적인 장기 성장 기회라고 밝혔다. 또 데이터센터용 신제품에 대한 정보도 밝혔다.

AMD가 새로 발표한 AI 가속기인 MI300X는 챗GPT 등 AI에 사용되는 대규모 언어 모델 학습을 위해 설계됐다. 차세대 AMD CDNA3 가속기 아키텍처를 기반으로 하며 최대 192GB HBM3 메모리를 지원하며 제너레이티브 AI에 중요한 대규모 언어 모델을 학습하고 추론하는데 필요한 컴퓨팅과 메모리 효율성을 제공한다.

리사 수 CEO는 MI300X는 MI300A와 유사하다며 기본적으로 MI300A에서 칩 3개를 제거하고 GPU 칩 2개를 탑재해 HMB3 메모리를 더 쌓았다며 정확하게 제너레이티브 AI를 위해 설계했다고 밝혔다. 또 최대 규모 언어 모델에 필요한 GPU 수를 줄일 수 있으며 그 중에서도 추론 성능을 대폭 향상시키고 총 소유 비용을 절감할 수 있다고 덧붙였다.

MI300X 대용량 메모리에 의해 400억 파라미터를 갖는 오픈소스 대규모 언어 모델 Falcon-40b 등 대규모 언어 모델을 단일 MI300X에 적합하게 하는 것 외에 8개 MI300X 가속기를 업계 표준 설계에 통합된 AMD 인스팅트 플랫폼도 제공된다.

이벤트에선 팔콘-40b를 단일 MI300X에서 실행하고 샌프란시스코에 대한 시를 쓰도록 지시해 몇 초 안에 텍스트를 작성하는 데모도 진행했다. AMD는 2023년 3분기부터 주요 고객에게 MI300X 제공을 시작할 예정이라고 한다.

AMD는 2023년 시점 300억 달러인 제너레이티브 AI용 데이터센터 칩 시장이 2027년에는 1,500억 달러까지 확대될 것으로 전망하고 있다. 보도에선 새로운 엔터프라이즈 가속기 발표로 AMD가 엔비디아가 차지하고 있는 시장 점유율을 빼앗으려 한다고 지적하고 있다. AMD는 또 최신 데이터센터에 최적화된 컴퓨팅 인프라인 4세대 AMD 에픽 업데이트, 데스크톱 PC용 APU인 라이젠 프로 7000, 노트북용인 라이젠 프로 7040 시리즈도 발표했다. 관련 내용은 이곳에서 확인할 수 있다.