문장만 입력하면 고정밀도 이미지를 생성할 수 있는 스테이블 디퓨전(Stable Diffusion)이나 대화 형식으로 고정밀도 문장을 작성하는 챗GPT(ChatGPT) 등 제너레이티브 AI(generative AI)가 화제가 되고 있다. 최근 급속도로 발전한 것으로 보이는 제너레이티브 AI는 어떤 구조이며 왜 급속도로 확산되고 있을까.

AI를 움직이는 컴퓨터는 집적회로상 트랜지스터 수가 1.5년마다 2배가 된다는 무어의 법칙에 따라 진보하는 한편 엔비디아 엔지니어는 실제로 무어의 법칙 5배에서 10배 추세로 AI가 진보하고 있다는 말로 놀라운 추세로 발전하고 있다.

이런 AI 발전 중에서도 최근에는 이미지 생성 AI나 문장 생성 AI 등 제너레이티브 AI가 화제다. 연구 분야에 그치지 않고 실용적 툴로 제너레이티브 AI가 급속도로 퍼진 요인으로는 대규모 언어 모델 LLM(large language models) 중요성을 지적한다. LLM은 기초 모델이라고 불릴 만큼 유연하고 적응성이 뛰어나 AI 시스템 상용화를 위한 획기적인 역할을 했다.

이 기초 모델이 어디에서 태어났는지를 더 거슬러 올라가면 딥러닝 발전에 의한 폭발적인 AI 확산과 RNN이나 LSTM 등 모델로 데이터 처리나 분석을 하던 걸 들 수 있다. 프로그래밍 언어로 학습부터 자연어 처리 NLP를 통한 코드가 아닌 언어를 이해하는 학습법에 추이해가는 단계에서 RNN이나 LSTM이 이용되고 있었지만 최근까지 언어 처리에선 단어 순서가 중요한 차이를 낳는다는 점과 적절한 학습 데이터를 얻는 게 어렵다는 점에서 긴 문장을 처리할 수 없었다.

여기에서 돌파구가 된 게 구글의 트랜스포머(Transformer)로 RNN보다 언어 이해 태스크가 뛰어난 신경 네트워크 아키텍처로 질 높은 번역에 성공했다. 번역에는 언어마다 어순이 중요하고 이게 트랜스포머에는 당연히 넣어져 있었기 때문에 트랜스포머가 이용한 위치 인코딩, 멀티헤드 어텐션이라는 처리법이 언어 처리 브레이크스루로 기능했다고 한다.

트랜스포머가 일으킨 브레이크스루에 대해 언어 모델에서 큰 전환점은 번역을 위해 만들어진 놀라운 모델을 이용하는 것으로 언어 처리 태스크가 안고 있던 문제를 번역 문제로 변환하는 방법을 찾아낸 것이라고 할 수 있다.

오픈AI는 번역 모델을 축으로 한 접근법을 추진해 2019년 고도의 문장을 작성할 수 있기 때문에 위험하다는 평가를 받은 문장 생성 툴 GPT-2를 공개했다. GPT-2는 놀랍도록 현실적인 인간 같은 텍스트를 생성할 수 있었지만 텍스트가 길어질수록 시스템이 빨리 망가지거나 프롬프트가 그다지 유연하지 않은 몇 가지 문제가 있었다.

2020년에는 GPT-2 후속인 GPT-3이 등장했다. GPT-2에서 GPT-3로 혁신이 최대 브레이크스루라고 할 수 있다. GPT-2에는 15억 매개변수가 있다고 여겨졌지만 GPT-3은 100배 이상인 1,750억 매개변수를 갖고 있으며 인간 문장과 거의 구별이 없는 블로그나 뉴스를 일관성 있는 문장으로 쓸 수 있어 화제를 모았다.

GPT-3이 뛰어난 점은 방대한 모델을 이용해 평이한 문장에서 다음 단락을 요약해달라, 이 단락을 헤밍웨이 문체로 재작성해달라 같은 명령만으로 별도 교육 없이 새로운 동작을 학습하는 것에 있다. 그리고 이 모델은 곧 언어 처리 분야를 넘어 다른 분야로 퍼져 나갈 것이다.

원래 컴퓨터비전 연구에선 예를 들어 사람 얼굴을 인식하기 위해 실제로 우리가 하는 것 같은 눈이나 입, 코를 보고 그 형태나 배치 패턴을 인식하는 프로세스를 재현하려고 시도해 사람 얼굴을 인식했다. 딥러닝은 이를 크게 바꾸고 수동으로 이미지 특징을 파라미터로 조작하는 대신 AI 모델이 특징을 학습해 사람 얼굴, 차, 동물 등 개체에 해당하는지 판단할 수 있도록 했다. 딥러닝은 대규모 데이터를 처리할 수 있는 강력한 모델이었지만 고양이 특징과 일치하고 있기 때문에 고양이 이미지라는 단순한 정형구로 판다날 수 있는 것에 그치며 이미지 특징과 언어 사이 번역 방법을 제대로 이해하지는 못했다.

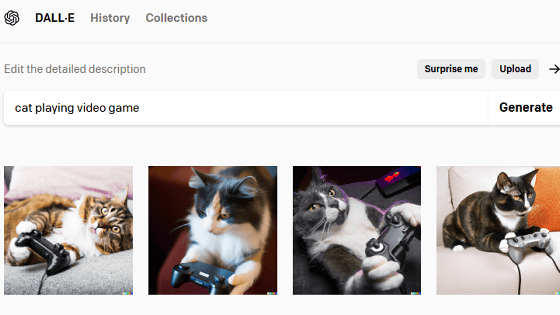

트랜스포머는 한 언어에서 다른 언어로 변환하는 번역 모델로 발명됐지만 이미지 같은 다른 매개변수를 언어와 유사한 방식으로 표현하는 방법을 이해하면 여기에 있는 규칙을 찾아 다른 언어로 맵핑할 트랜스포머 능력을 교육하고 번역할 수 있다. 이렇게 해서 이미지에서 특징을 추출해 잠재 표현이라고 하는 저차원 표현으로 압축해 세세한 점을 축으로 좌표에 표현하는 접근법이 가능해졌다. 오픈AI는 이미지 언어와 이를 번역하는 도구 외에도 이미지와 텍스트를 변환하기 위한 방대한 데이터세트를 구축해 GPT-3 매개변수를 이용해 자연어 처리와 이미지 생성을 조합한 AI인 달리(DALL・E)를 만들었다.

정리하면 이미지 생성 AI는 이미지를 표현하기 위한 언어를 학습하는 딥러닝과 텍스트 세계와 이미지 세계를 전환하는 번역 기능이라는 2가지 AI 진보가 조합으로 발전했다. 이런 AI 모델은 데이터 의존성, 예측 불가능성, 확률적이라는 특징도 있지만 상당히 강력하고 유연성이 있어 거의 보편적이고 다양한 경우에 적용할 수 있어 일상 사용에 퍼졌다고 할 수 있다.

이제 AI 도구는 더 강력해지고 사용하기 쉽고 저렴해질 것이다. 무어의 법칙만큼 중요한 혁신 초기 단계로 앞으로 무슨 일이 일어날지에 대해 흥분하는 동시에 두려워하게 될 수 있다. 관련 내용은 이곳에서 확인할 수 있다.