모든 인류에 큰 영향을 미친다는 AI지만 오픈AI의 챗GPT나 구글 바드 등 대규모 언어 모델 에너지 소비량은 막대하다.

강력한 프로그램 학습을 위해선 충분한 데이터를 제공하는 대규모 서버군이 필요하다. 또 이를 수행하는 데이터센터에는 강력한 냉각 장치가 필요하다. GPT-3 버전을 학습하는 데 필요한 냉각수 양은 70만 리터에 달한다는 조사 결과도 있다. 미국 캘리포니아대학 리버사이드와 텍사스대학 알링턴 연구팀이 AI에 의한 수자원 소비에 대해 조사한 보고서(Making AI Less ‘Thirsty)에서 이 같은 밝히고 있다.

이 보고서에선 GPT-3 학습에 필요한 수량은 원자로 냉각수 탱크를 채우는 양과 거의 같다는 게 밝혀졌다. 오픈AI와 제휴해 거액을 투자한 마이크로소프트는 AI 학습용 슈퍼컴퓨터 구축을 끝냈고 최신 머신은 그래픽카드 1만장, 프로세서 코어 28만 5,000개를 탑재하고 있어 방대한 냉각수를 필요로 하는 건 틀림없다. 알기 쉽게 말하자면 챗GPT, GPT-3을 사용자 1명이 사용할 때 25∼30개 기본 질문 교환에 500밀리리터 물이 필요하게 된다고 한다.

이제 AI 모델 학습은 오픈AI를 위핸 구축된 마이크로소프트 최상급 데이터센터에서 진행되고 있다. 만일 에너지 효율이 그다지 좋지 않은 아시아 데이터센터에서 실시한다면 물 소비량은 3배나 높아질 가능성이 있다고 한다. 필요한 수량은 새로운 모델이 나올 때마다 늘어날 전망이다. 오픈AI는 이미 GPT-4를 출시했고 다루는 데이터세트는 이전보다 더 커졌다.

연구팀은 AI 모델의 물 사용량은 이미 간과할 수 없는 영역에 이르고 있다며 세계적인 물 문제에 대한 종합 대처 중 하나로 AI 모델의 워터 풋프린트를 우선 대응할 필요가 있다고 지적한다.

연구팀에 의한 AI 물 소비량 추산은 취수와 소비를 나눠 고려하고 있다. 취수는 강이나 호수 등으로부터 물리적으로 물을 도입하는 것. 소비는 데이터센터에서 사용되어 증발되어 잃는 물이다. 보고서에서 주력하는 건 후자 재활용이 불가능한 소비다.

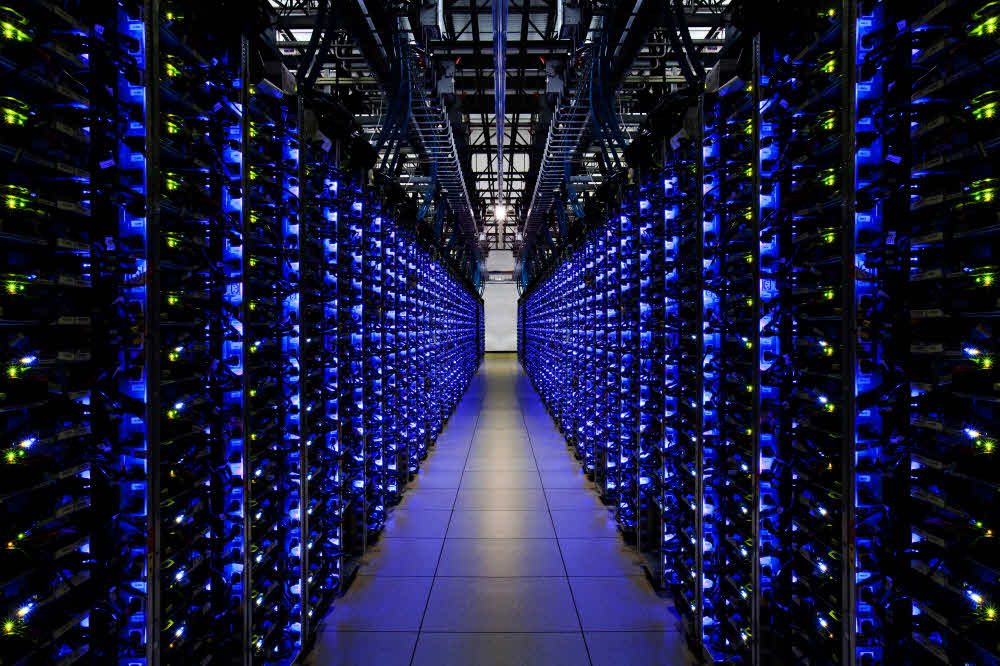

서버룸에 들어가 본 적이 있다면 알겠지만 서버룸은 조금 춥다. 서버룸 온도는 10도에서 27도 폭으로 에어컨이 설정되어 있다. 서버룸의 가장 큰 과제는 적절한 온도를 유지하는 것이지만 이는 쉽지 않다. 외기온 영향은 물론 서버 자체도 열을 내기 때문. 데이터센터에선 효율적인 냉각 방법으로 대부분이 기화 냉각 시스템을 도입하고 있다.

서버 냉각을 효율적으로 하는 게 기화 시스템이지만 여기에는 물이 필요하다. 연구팀 예측으로는 평균적인 데이터센터에서 1킬로와트시마다 4.5리터 물이 필요하다고 한다. 또 데이터센터에서 사용되는 건 깨끗한 민물이어야 한다. 설비 부식이나 박테리아를 막기 위해 해수나 사용 후 물은 안 된다. 또 담수는 데이터센터 내 습도 관리에도 필요하다.

연구팀은 데이터센터가 소비하는 대량 전력을 발전하는데 필요한 물을 간접 물 소비라고 부르며 데이터센터 전체 물 소비량 문제 일부로 파악해야 한다고 지적한다.

물 소비 문제는 오픈AI 나아가 AI에만 국한되지 않는다. 예를 들어 구글은 2019년 미국 내 3개주 데이터센터에 87억 리터 물을 사용했다. 구글은 현재 북미에 14개 데이터센터를 보유하고 있으며 이는 구글 검색, 구글 워크스페이스, 최근에는 LaMDA와 바드 같은 언어 모델을 지원한다. 참고로 LaMDA 학습은 GPT-3보다 더 많은 수백만 톤에 달하는 물이 필요하다고 한다. 이는 구글 데이터센터가 텍사스주 등 더운 지역에 있다는 게 영향을 미치고 있다.

다른 문제도 있다. 대규모 언어 모델은 원래 전력 대식가이기도 하다. 스탠포드 연구소가 낸 보고서에 따르면 GPT-3 학습 기간에 배출된 탄소량은 502톤이다. GPT-3 학습 전체에 걸린 전력은 평균적인 미국 일반 가정 수백년 분이다.

세계경제포럼에 따르면 이미 미국 내 220만 가구는 물 부족이나 화장실 등 기본적인 실내 배관 설비 문제에 직면하고 있으며 4,400만 가구는 불안정한 급수 시스템 하에 있다. 연구팀은 기후 변화와 인구 증가로 금세기 말에는 물 문제는 더 심각해질 전망이다. 스탠포드대학 예측에 따르면 2071년까지 미국 내 204개 담수 유역 중 절반이 매달 물 수요량을 충족할 수 없게 될 것이라고 한다. 앞으로 50년이면 많은 지역에서 물 공급량이 3분의 1 정도까지 감소할 가능성도 있다고 한다.

미국 내에선 기온 상승에 따라 1,000년에 한 번 수준인 가뭄이 발생하고 있다. AI 수요가 급속도고 확대되고 기술 기업이 모든 서비스 분야에 AI를 도입해 나가면 AI 수요는 점차 확대되어 물 부족을 악화시킬 것이다. 연구팀이 밝혔듯 글로벌 규모로 AI를 위한 워터 풋프린트에 임할 필요가 있다.

AI 물 사용량을 비교적 용이하게 줄이는 방법은 몇 가지 있다. 연구팀은 간단하게 AI 모델 학습을 더 적절한 장소, 적절한 시간에 하면 된다고 말한다. 다시 말해 비교적 시원한 지역, 시원한 시간에 실시하면 된다는 얘기다. 서비스에도 에너지 효율 시간이라는 기능을 마련하는 게 좋을지도 모른다. 동시에 기업 에너지 효율화와 투명화도 진행할 필요가 있다.

연구팀은 조사를 바탕으로 AI 모델 개발자와 데이터센터 운영자는 더 투명성을 유지해야 한다며 언제 어디에서 AI 모델 학습이 이뤄졌는지, 타사 데이터센터와 퍼블릭 클라우드에서 AI 모델 학습과 배치는 어떤지 등 이런 정보는 연구자 뿐 아니라 일반인에게도 가치가 있을 수 있다는 것이다. 관련 내용은 이곳에서 확인할 수 있다.