마이크로소프트가 6월 23일 소규모 언어 모델(SLM) Mu에 대한 세부사항을 발표했다. Mu는 PC 같은 디바이스 상에서 직접 효율적으로 동작하도록 설계됐으며 복잡한 추론을 필요로 하는 상황에 대응한 모델로 그 중에서도 윈도 설정 화면에서 자연스러운 언어를 통한 조작을 가능하게 하는 AI 에이전트 두뇌로 활용되고 있다.

Mu는 코파일럿+ PC에 탑재된 NPU 성능을 최대한 끌어내도록 설계된 3억 3,000만 파라미터 SLM. 이를 통해 인터넷에 연결하지 않고도 디바이스 상에서 고속으로 응답한다. 실제로 설정 에이전트 시나리오에서는 초당 100토큰 이상, 특정 작업에서는 초당 200토큰을 초과하는 처리 속도를 실현하고 있다.

Mu는 인코더-디코더 아키텍처를 채택하고 있으며 입력된 문장(인풋)을 고정된 잠재 표현으로 한 번 변환하고 이를 바탕으로 출력(아웃풋)을 생성한다. 이를 통해 인풋과 아웃풋을 매번 함께 처리하는 디코더 온리 모델에 비해 계산량이 대폭 삭감되어 고속 응답과 메모리 소비 감소를 실현한다.

마이크로소프트에 따르면 퀄컴 헥사곤(Qualcomm Hexagon) NPU 상에서 첫 번째 응답에 걸리는 시간은 47% 단축됐으며 디코드 속도는 4.7배 향상됐다고 한다.

Mu는 또 모델 내 각 계산 레이어에서 정규화를 수행하는 듀얼 레이어놈(Dual LayerNorm), 문장 중 단어에 대한 상대적 위치 관계를 모델에 학습시키는 RoPE(Rotary Positional Embeddings), AI가 문장 어디에 주목해야 할지를 계산하는 어텐션(Attention)을 효율화하는 GQA(Grouped-Query Attention) 등 최신 기술을 도입함으로써 적은 파라미터로 더 높은 성능을 끌어내고 있다.

Mu 훈련은 복수 단계를 거쳐 진행됐다. 마이크로소프트는 먼저 고품질 교육용 텍스트 데이터를 대량으로 학습시켜 언어 구문과 기본 지식을 습득시켰다. 다음으로 마이크로소프트 고성능 모델인 파이(Phi)가 가진 지식을 증류라는 기법으로 계승시킴으로써 파라미터 효율을 향상시켰다.

최종적으로 특정 작업에 특화된 데이터로 파인튜닝을 수행해 해당 작업에서의 정확도를 극적으로 높였다. 그 결과 Mu는 더 큰 모델인 Phi-3.5-mini보다 10분의 1 크기임에도 많은 작업에서 동등한 성능을 달성했으며 마이크로소프트는 설정 앱 내에 마치 사람과 대화하듯 자연스러운 언어로 조작할 수 있는 Mu 기반 AI 에이전트를 구현할 수 있었다고 밝혔다.

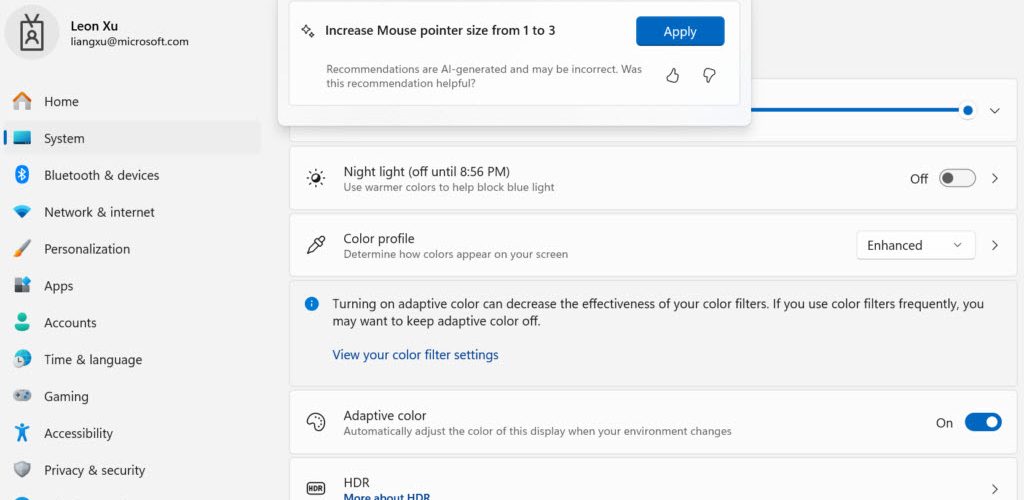

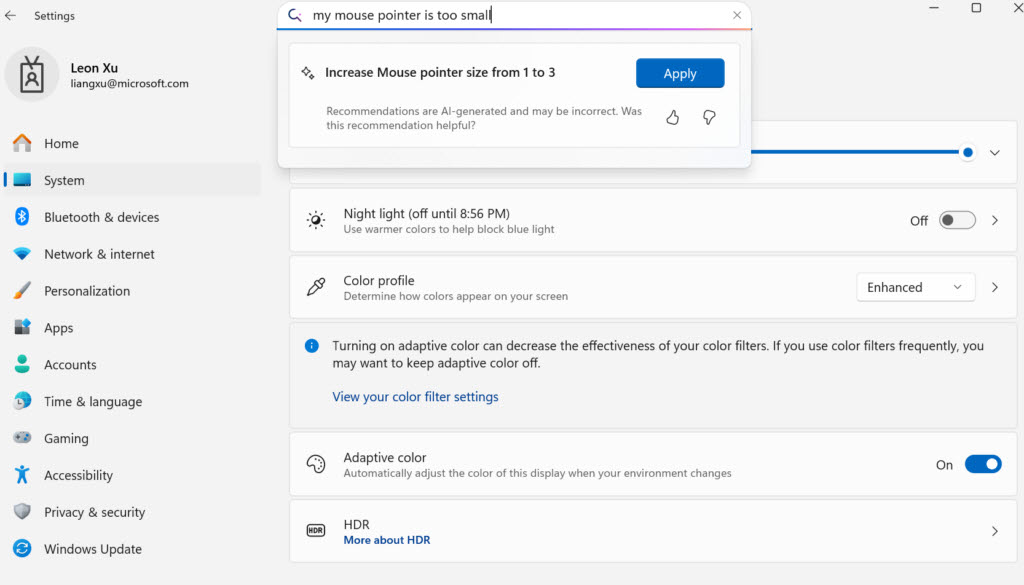

예를 들어 사용자가 마우스 포인터가 너무 작다 같은 일상적인 언어로 입력하면 AI 에이전트는 의도를 이해하고 마우스 포인터 크기를 1에서 3으로 변경하겠다 같은 구체적인 설정 변경을 제안한다.

이런 에이전트는 이전에도 개발되어 왔으며 현재 코파일럿+ PC에는 Phi-Silica가 온디바이스 SLM으로 탑재되어 있지만 정확도는 충분하나 응답 속도가 과제였다고 한다. 고속성과 효율성에 뛰어난 Mu를 기반으로 하고 360만 건에 이르는 샘플 데이터를 사용해 집중적인 파인튜닝을 실시해 500밀리초 미만이라는 고속 응답 시간을 실현하면서 수백 개 설정 항목에 대응 가능한 신뢰성 높은 에이전트를 실현할 수 있었다고 한다.

마이크로소프트는 향후 전망으로 설정에서의 에이전트 경험을 지속적으로 개선해 나가기 위해 윈도 인사이더 프로그램 사용자 피드백을 기다리고 있다고 말했다. 한편 Mu 기반 AI 에이전트를 체험하려면 버전 24H2 빌드 26120.3964(KB5058496) 이상을 코파일럿+ PC에 설치해야 한다. 관련 내용은 이곳에서 확인할 수 있다.