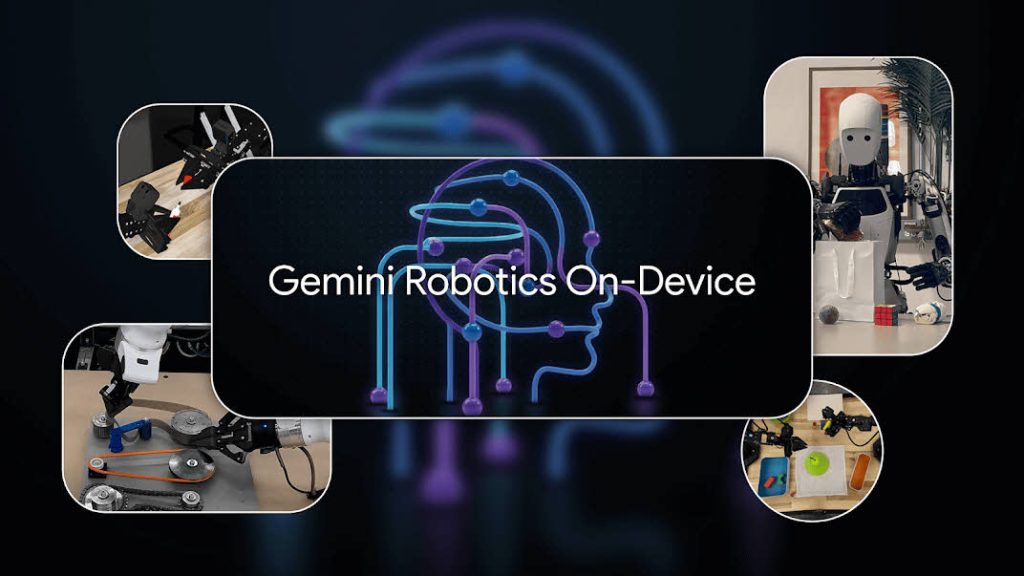

구글이 6월 24일 로봇용 VLA 모델인 제미나이 로보틱스 온디바이스(Gemini Robotics On-Device)를 발표했다. 이 모델은 로컬 GPU를 사용해 실행할 수 있을 만큼 경량화되어 있으면서도 기존 로컬 VLA 모델과 비교해 더 뛰어난 성능을 지니는 게 특징이다.

구글은 지난 3월 제미나이 2.0을 기반으로 행동 출력 기능을 추가한 로봇용 VLA 모델인 제미나이 로보틱스(Gemini Robotics)를 선보인 바 있다. 이번에 발표된 제미나이 로보틱스 온디바이스는 이 모델을 로컬 환경에서 동작하도록 최적화한 버전으로, 최소한의 계산 자원만으로 양팔 로봇을 제어할 수 있도록 설계됐다.

Excited to release Gemini Robotics On-Device and bunch of goodies today

— Dhruv Shah @ RSS (@shahdhruv_) June 24, 2025on-device VLA that you can run on a GPU

open-source MuJoCo sim (& benchmark) for bimanual dexterity

broadening access to these models to academics and developershttps://t.co/mSjXTLuOeu

제미나이 로보틱스 온디바이스는 인터넷 연결 없이도 실행할 수 있어 낮은 지연시간이 중요한 작업에서 강점을 발휘한다. 로컬에서 작동할 수 있을 정도로 소형화된 모델이지만 자연어 명령을 이해해 가방 지퍼를 여는 등 정밀한 동작도 수행할 수 있다.

제미나이 로보틱스 온디바이스는 모델 미세 조정(fine-tuning)도 지원해 50~100회 시연만으로 새로운 상황에 적응할 수 있다.

We're also launching the Gemini Robotics software development kit (SDK) to help developers fine-tune the model for their own applications, including by testing it in the MuJoCo physics simulator.

— Google DeepMind (@GoogleDeepMind) June 24, 2025pic.twitter.com/w8uOFSnCXK

당초 이 모델은 구글 로봇 팔 알로하(ALOHA)를 위해 설계됐지만 이후 프랭카리서치3(Franka Research 3)나 아폴로(Apollo) 등 타사 로봇 모델에서도 높은 성능을 발휘할 수 있도록 개선됐다. 아폴로에 탑재된 제미나이 로보틱스 온디바이스는 테이블에 놓인 여러 물체 중 지시에 맞는 물체를 골라 봉투에 담는 작업도 로컬 처리만으로 수행한다.

구글은 모델 개발 키트를 일부 개발자에게 공개하고 있으며 관심 있는 개발자에게는 대기자 명단에 등록할 걸 권하고 있다. 관련 내용은 이곳에서 확인할 수 있다.