IBM 리서치가 카네기멜론대학, 프린스턴대학, 일리노이대학과 공동으로 오픈소스 대규모 언어 모델 밤바(Bamba)를 구축하고 버전 2를 오픈소스로 출시했다.

밤바는 97.8억 파라미터를 가진 대규모 언어 모델로 기반 아키텍처가 일반 대규모 언어 모델과 조금 다른 점이 특징이다. IBM 리서치에 따르면 일반 대규모 언어 모델은 트랜스포머(Transformer)라는 아키텍처를 활용하지만 응답할 때 실행 중인 시퀀스를 메모리에 유지하는 관계상 프롬프트가 길어질수록 생성 비용이 지수함수적으로 증가한다고 한다. 예를 들어 컨텍스트 윈도 크기가 2배가 되면 이를 처리해 응답을 생성하는 비용은 2배가 아닌 4배가 된다고 한다.

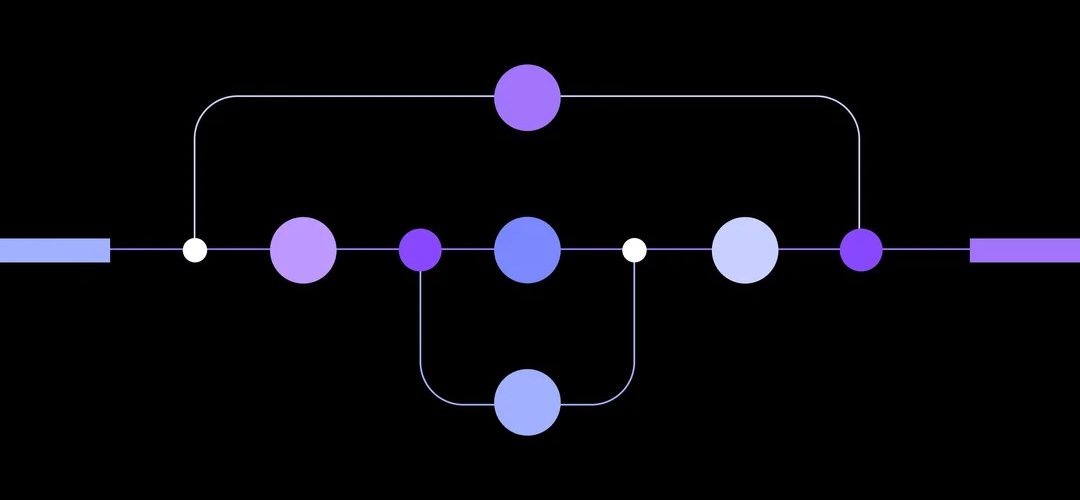

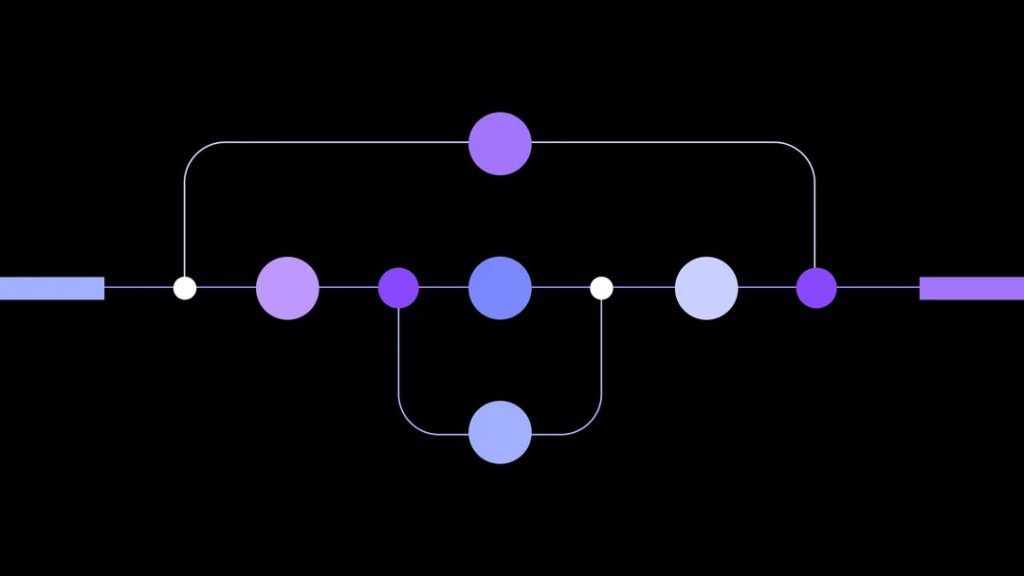

이 문제는 2차 병목현상이라고 불리며 사용자가 AI에 질문하고 답을 얻기까지의 시간 지연 원인 중 하나가 되고 있다고 한다. 새롭게 등장한 Bamba-9B는 트랜스포머 아키텍처와 상태 공간 모델(SSM. State-space models)이라는 아키텍처를 결합하면서 메모리 역할을 하는 KV 캐시 관리를 트랜스포머 아키텍처에서 근본적으로 변경한 모델이다.

보통 트랜스포머가 응답을 출력할 때 컨텍스트 윈도 내 모든 단어에 주의를 기울이는 반면 SSM은 과거 정보를 요약한 숨겨진 상태를 유지한다고 한다. 정보를 선택적으로 보존하는 이 방식을 사용해 메모리 오버헤드가 줄어들고 추론 속도가 빨라진다고 한다.

IBM 리서치에 따르면 Bamba-9B는 KV 캐시의 메모리 요구사항을 대폭 줄여 동일 크기 트랜스포머 기반 모델과 비교해 동등한 정확도를 유지하면서 최소 2배 속도로 작동할 수 있다고 한다. 트랜스포머 능력과 SSM 실행 속도를 결합해 병목현상을 해소하면서 응답 정확도를 유지한 모델이 됐다. 밤바는 아파치 2.0 라이선스 하에 오픈소스로 공개됐다. 관련 내용은 이곳에서 확인할 수 있다.