오픈AI가 지난 5월 출시한 AI 모델 GPT-4o에 10월 1일부터 이미지로 파인튜닝하는 기능이 추가됐다. 이미 텍스트로 GPT-4o를 파인튜닝하는 기능은 제공되고 있었지만 이미지로 파인튜닝이 가능해면서 시각적 검색이나 객체 탐지 등 기능을 향상시킬 수 있게 됐다.

오픈AI는 10월 1일 GPT-4o를 이미지로 파인튜닝하는 기능을 출시했다. 오픈AI는 GPT-4o에 처음으로 파인튜닝을 도입한 이후 개발자 수십만 명이 텍스트만으로 구성된 데이터셋으로 모델을 커스터마이즈해 특정 작업 성능을 향상시켜 왔다며 하지만 많은 경우 텍스트로만 모델을 미세 조정하는 것으로는 기대되는 성능 향상을 얻을 수 없다고 밝혔다.

GPT-4o의 파인튜닝을 수행하려면 먼저 파인튜닝 대시보드에 접속하여 화면상 버튼(+Create)을 클릭한다. 기본 모델 목록에서 gpt-4o-2024-08-06을 선택한다. 그리고 이미지 데이터셋 파일을 선택해 업로드 양식에 드래그 앤 드롭하면 된다. 이미지 데이터셋은 미리 적절한 형식으로 준비해야 한다. 오픈AI는 이미지 단 100장으로 GPT-4o 이미지 인식 작업 성능을 향상시킬 수 있다고 한다.

이미 오픈AI는 몇몇 파트너와 협력해 실제로 GPT-4o 이미지 파인튜닝 기능을 사용해 보도록 했다. 동남아시아에 본사를 둔 차량 호출 앱 그랩(Grab)은 운전자로부터 수집한 도로 이미지를 사용해 맵핑 데이터를 작성하고 있다. 이번에 그랩은 이미지 단 100장으로 GPT-4o를 파인튜닝해 교통 표지판 위치와 차선 구분을 정확하게 식별할 수 있도록 했다. 파인튜닝 결과 GPT-4o 기본 모델과 비교해 차선을 세는 정확도가 20%, 속도 제한 표지판 위치 추정 정확도가 13% 향상됐다고 한다. 이전에는 수동으로 진행했던 맵핑 작업을 더 적절하게 자동화할 수 있게 됐다.

— OpenAI Developers (@OpenAIDevs) October 1, 2024

We’re adding support for vision fine-tuning. You can now fine-tune GPT-4o with images, in addition to text. Free training till October 31, up to 1M tokens a day. https://t.co/Nqi7DYYiNC pic.twitter.com/g8N68EIOTi

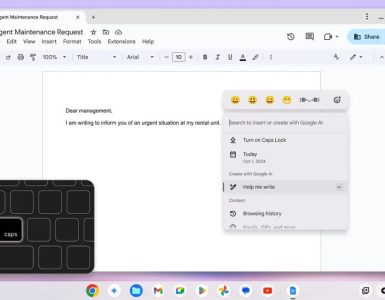

문서 처리와 UI 기반 비즈니스 프로세스를 자동화하는 기업인 오토맷(Automat)은 스크린샷 데이터셋을 사용해 GPT-4o 파인튜닝을 수행했다. 그 결과 자연어 설명이 주어진 화면상 UI 요소를 식별하는 성능이 향상되어 자동화 에이전트 성공률이 16.6%에서 61.67%로 향상됐다고 한다. 또 구조화되지 않은 보험 관련 문서 200장으로 GPT-4o를 파인튜닝한 결과 정보 추출 작업 점수가 7% 향상됐다고 보고됐다.

웹사이트와 UI 생성 및 테스트를 최적화하는 AI 엔지니어링 어시스턴트를 개발하는 코프레임(Coframe)은 이미 존재하는 웹사이트 요소를 기반으로 새로운 브랜드 섹션을 자율적으로 생성하는 서비스를 제공하고 있다. 코프레임이 이미지와 코드를 사용해 GPT-4o를 파인튜닝해 일관된 시각적 스타일과 올바른 레이아웃으로 웹사이트를 생성하는 모델 능력을 기본 GPT-4o와 비교해 26% 향상시킬 수 있었다고 한다.

이미지를 사용한 GPT-4o 파인튜닝 기능은 최신 모델인 gpt-4o-2024-08-06에서 지원되며 유료 계정 모든 개발자가 이용할 수 있다. 10월 31일까지는 하루에 100만 트레이닝 토큰이 무료로 제공되며 11월 1일 이후 파인튜닝에는 100만 토큰당 25달러, 입력에 100만 토큰당 3.75달러, 출력에 100만 토큰당 15달러 비용이 발생한다고 한다. 관련 내용은 이곳에서 확인할 수 있다.

한편 오픈AI는 10월 1일 모든 개발자가 앱 내에서 저지연 멀티모달 경험을 구축할 수 있게 하는 리얼타임 API(Realtime API) 공개 베타 버전 제공을 시작했다. 이를 통해 다양한 앱에서 AI와의 실시간 대화가 가능해진다.

지금까지 음성 어시스턴트를 구현하려면 음성 인식 모델이 사용자 입력 음성을 텍스트로 변환하고 그 텍스트를 텍스트 모델에 전달해 추론한 뒤 그 출력을 텍스트 음성 변환 API를 사용해 재생해야 했다. 이로 인해 이 접근 방식에서는 감정이나 강조, 억양이 손실되며 지연이 두드러지는 문제가 발생했다. 하지만 리얼타임 API에서는 오디오 입출력을 직접 스트리밍해 이 문제를 개선, 보다 자연스러운 대화 경험을 실현했다고 한다. 또 유료 사용자를 위한 기능인 어드밴스드 보이스 모드(Advanced Voice Mode)와 마찬가지로 중단을 자동으로 처리하는 것도 가능하다.

내부적으로 리얼타임 API와 GPT-4o 사이에 메시지를 교환하기 위한 영구적인 웹소켓(WebSocket) 연결을 생성한다. 또 리얼타임 API는 펑션 콜링(Function calling)을 지원하기 때문에 생성된 음성 어시스턴트는 액션을 트리거하거나 새로운 컨텍스트를 가져와 사용자 요청에 응답할 수 있다고 한다. 실제로 영양 균형과 피트니스 코칭 앱인 헬시파이(Healthify)에서는 리얼타임 API를 활용해 AI 코치 리아(Ria)와 자연스러운 대화를 할 수 있을 뿐 아니라 필요에 따라 개인화된 인간 영양사 지원을 받을 수 있다. 또 언어 학습 앱인 스피크(Speak)에서는 리얼타임 API를 사용해 롤플레이 기능을 강화하고 사용자 언어 학습을 지원하고 있다고 한다.

리얼타임 API는 gpt-4o-realtime-preview로 10월 1일부터 이용 가능해졌다. 리얼타임 API 이용 요금은 오디오 입력 가격은 1분당 0.06달러, 출력은 1분당 0.24달러에 해당한다고 한다.

— OpenAI Developers (@OpenAIDevs) October 1, 2024

Introducing the Realtime API—build speech-to-speech experiences into your applications. Like ChatGPT’s Advanced Voice, but for your own app. Rolling out in beta for developers on paid tiers. https://t.co/LQBC33Y22U pic.twitter.com/udDhTodwKl

리얼타임 API 안전성에 대해 오픈AI는 자동 모니터링과 모델 입출력에 대한 인간 검토 등 여러 안전 보호 계층을 사용해 API 오용 위험을 완화하고 있다고 말했다. 또 사용자에게 오픈AI 서비스에서 나온 출력을 스팸이나 오해 소지가 있는 목적, 타인에게 해를 끼치는 목적으로 재사용하거나 배포하는 건 이용 정책을 위반한다며 잠재적인 오용을 적극적으로 모니터링하고 있으며 맥락상 명백한 경우를 제외하고 개발자가 AI와 상호작용하고 있다는 걸 사용자에게 명확히 전달하는 것도 의무화하고 있다고 주의를 주고 있다.

더불어 오픈AI는 명시적인 고객 허가 없이 이 서비스에서 사용되는 입출력으로 모델을 학습시키지 않을 것이라고 선언했다. 향후 도입 예정인 기능에 대해 오픈AI는 이미지나 비디오 등 모달리티 추가, 비율 제한 상향, 공식 SDK 지원, 프롬프트 캐싱 도입, 지원하는 모델 확장을 언급하고 있다. 관련 내용은 이곳에서 확인할 수 있다.