미스트랄AI(Mistral AI)가 새로운 대규모 언어 모델인 8x22B MOE를 발표했다. 이 모델은 컨텍스트 길이 65k에 최대 1,760억 개 매개변수를 가질 수 있다.

8x22B MOE에 대한 자세한 정보는 알려지지 않았지만 많은 벤치마크에서 GPT-3.5와 LLaMA 2 70B를 능가하는 성능을 가질 것으로 보인다. 이 모델은 2023년에 공개된 믹스트랄 8x7B 모델보다 3배 이상 많은 매개변수를 갖고 있다.

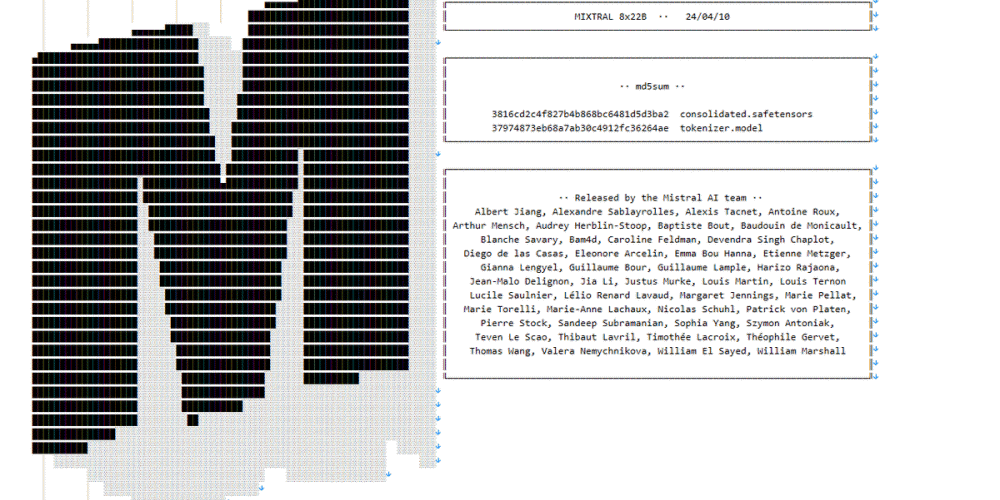

미스트랄 8x22B MOE는 믹스트랄 8x7B 대형 버전 격으로 볼 수 있다. 미스트랄AI는 토렌트 링크를 사용해 8x22B MOE를 공유했다. 비트토렌트 클라이언트를 사용하면 모델 데이터를 내려받을 수 있다.

큐비트토렌트(qBittorrent)를 사용하면 파일→토렌트 링크 추가를 클릭하고 미스트랄AI가 공유한 링크를 복사해 다운로드를 누르면 된다. 파일 크기는 261GB다.

8x22B MOE에 대한 자세한 사항은 알려지지 않았지만 매개변수 총수가 최대 1,760억 개에 달할 수 있다. 또 컨텍스트 길이는 65k로 알려져 있다. 미스트랄AI 모델은 종종 유출 형태로 공개되지만 이번에는 공식 계정을 통한 정식 출시다.

미스트랄AI는 프랑스에 설립된 스타트업으로 오픈소스 모델인 믹스트랄 8x7B와 상용 모델인 미스트랄 스몰(Mistral Small), 미스트랄 임베디드(Mistral Embed), 미스트랄 라지(Mistral Large) 등을 공개하고 있다. 이곳은 이미 벤처캐피털로부터 3억 8,500만 유로 이상을 조달했으며 기업가치는 18억 유로에 달하는 것으로 알려져 있다. 또 2024년 2월에는 마이크로소프트와 수년간 파트너십 계약을 체결하고 1,500만 유로 투자를 받았지만 EU 규제 당국 조사를 받고 있다.