중국 기술 기업인 알리바바 인텔리전트컴퓨팅연구소가 사진과 이미지를 애니메이션화해 현실적으로 말하거나 노래를 부르는 것처럼 움직이는 영상을 생성할 수 있는 AI 시스템인 EMO(Emote Portrait Alive)를 발표했다.

EMO는 입력한 오디오 트랙에 일치하도록 부드럽고 표현력이 풍부한 표정과 머리 움직임을 생성할 수 있다. 인터뷰 영상처럼 말하는 것도 가능하다. EMO에는 확산 모델이라고 불리는 AI 기술이 사용된다. 또 연구팀은 모델을 훈련할 때 250시간 이상 연설과 영화, TV 프로그램, 노래 영상을 사용했다.

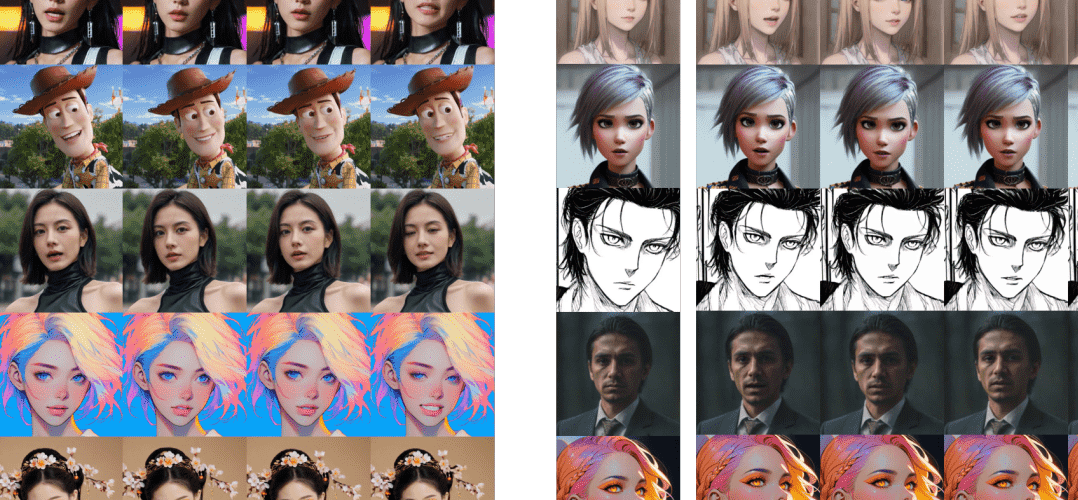

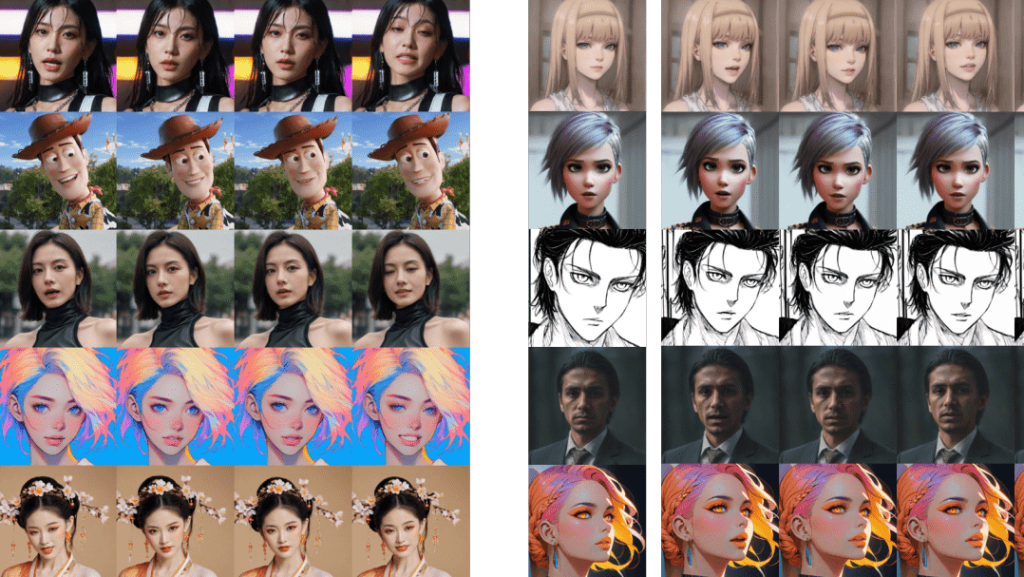

이렇게 개발된 EMO는 3D 얼굴 모델이나 윤곽 합성에 의존해 얼굴 움직임을 모방한 기존 방법과 달리 입력된 음성으로부터 직접 영상을 생성한다. 이를 통해 가창과 발화에 따른 미묘한 움직임과 고유한 버릇을 포착해 자연스러운 영상을 출력할 수 있게 됐다.

노래하는 영상 출력에 필요한 건 이미지 1장과 음성 뿐이다. 랩처럼 입이 격렬하게 움직이는 노래도 문제 없다. 논문에 따르면 EMO는 영상 품질, 정체성 유지, 표현력을 측정하는 지표로 지금까지의 첨단 방법을 크게 웃도는 점수를 나타냈다고 한다.

연구팀은 논문에서 기존 기술로는 인간 표정 전체 영역을 포착할 수 없는 경우가 많고 개별 얼굴 스타일 독자성을 포착할 수 없다는 한계가 있다며 문제를 해결하기 위해 중간 3D 모델과 얼굴 랜드마크 지정 필요성을 피하고 음성에서 영상으로의 직접 합성 방식을 활용하는 새로운 프레임워크인 EMO를 제안하고 있다.

이 기술을 사용하면 이미지와 오디오를 준비하는 것만으로 현실적 영상을 쉽게 만들 수 있다. 이 때문에 흑백 사진이나 일러스트를 노래하게 하는 것만이라도 실재 인물 얼굴이나 목소리 동의 없이 사용한 딥페이크 영상을 만드는 등 중대한 문제로 발전하는 게 우려된다. 이 기술이 오정보 확산이나 스푸핑에 악용되는 문제에 대응하기 위해 연구자는 합성 영상 검출 방법을 검토할 예정이라고 한다. 관련 내용은 이곳에서 확인할 수 있다.