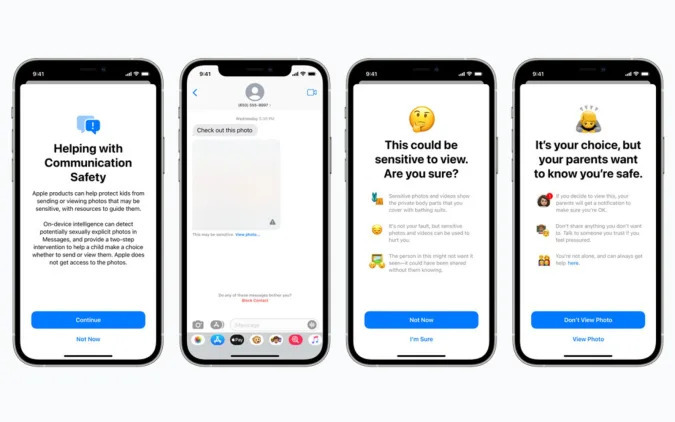

애플이 지난 8월 아이 학대 대책을 아이폰이나 맥에 도입한다고 발표했지만 대책 중 하나로 CSAM(Child Sexual Abuse Material) 그러니까 아이클라우드에 보존되는 아동 서적 학대 이미지를 자동 스캔하는 메커니즘이 포함되어 논의 대상이 됐다.

하지만 이번에 애플이 아동에 대한 보호 확대(Expanded Protections for Children) 페이지에서 모든 CSAM 관련 기술을 삭제한 게 분명해졌다. 원래 CSAM 구조는 iOS와 아이패드OS 15.2 이후에 소개됐지만 전자프런티어재단 등 많은 단체로부터 비판을 받았다. 애플은 우려를 없애기 위해 자세한 정보를 공개하고 공식 FAQ나 문서, 인터뷰를 통해 안심시키려 했다. 사내에서도 오해가 많지만 설명을 계속해야 한다는 사내 메모가 유출되기도 했다.

하지만 애플의 노력에도 불구하고 비판이 이어졌고 9월에는 도입 연기를 발표했다. 이어 16일 기준으로 CSAM에 대한 모든 언급이 지워졌다. 이 때문에 애플이 영구적으로 단념한 건 아니냐는 추측이 나오기도 한다. 하지만 애플 측은 CSAM 검출 기능은 웹사이트에서 언급하지 않지만 미래에는 구현할 예정이라는 취지로 밝혔다.

다만 정부가 애플에 CSAM이 아닌 화상으로 해시 리스트에 추가하도록 요구 그러니까 검열을 위해 악용할 우려를 완전히 부정하기는 어렵다. 앞으로 애플이 여론을 더 설득하도록 노력할지 최종적으로 포기할지 관심이 모아진다. 관련 내용은 이곳에서 확인할 수 있다.