구글 딥마인드가 시각과 언어를 행동으로 변환할 수 있는 학습 모델인 RT-2(Robotic Transformer 2)를 7월 28일 발표했다. RT-2를 탑재한 로봇은 딸기를 그릇에 제대로 넣고 데스크에서 떨어질 것 같은 물건을 들어 올리는 것 같은 지시를 실행할 수 있는 것 외에 학습 데이터에 포함되어 있지 않은 지시도 높은 정밀도로 실행할 수 있다.

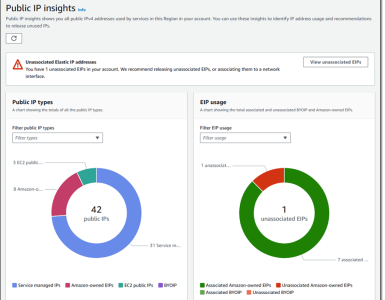

카메라 탑재 로봇에 언어로 지시를 주어진 시각 언어 모델(vision-language model)은 지금까지 존재했지만 기존 학습 모델을 사용해 로봇에게 지시를 제공하려면 이미지를 식별하는 학습 모델 언어를 해석하는 학습 모델과 같은 여러 학습 모델을 결합해야 했다. 새롭게 발표된 RT-2는 시각 언어 행동 모델(vision-language-action model)로 자리매김하고 있으며 단일 학습 모델로 카메라로 대상을 인식하고 언어에 의한 지시에 따라 행동한다는 동작을 실행시킬 수 있다.

RT-2는 2022년 12월 발표된 RT-1 데이터를 이용해 학습되고 있다. 연구팀이 6,000가지 이상 시험을 실시한 결과 학습이 끝난 태스크에서 RT-2는 RT-1과 같은 정도 성공률을 기록했다고 한다. 또 학습하지 않은 작업 성공률은 RT-1이 32%였지만 RT-2는 62%로 향상됐다.

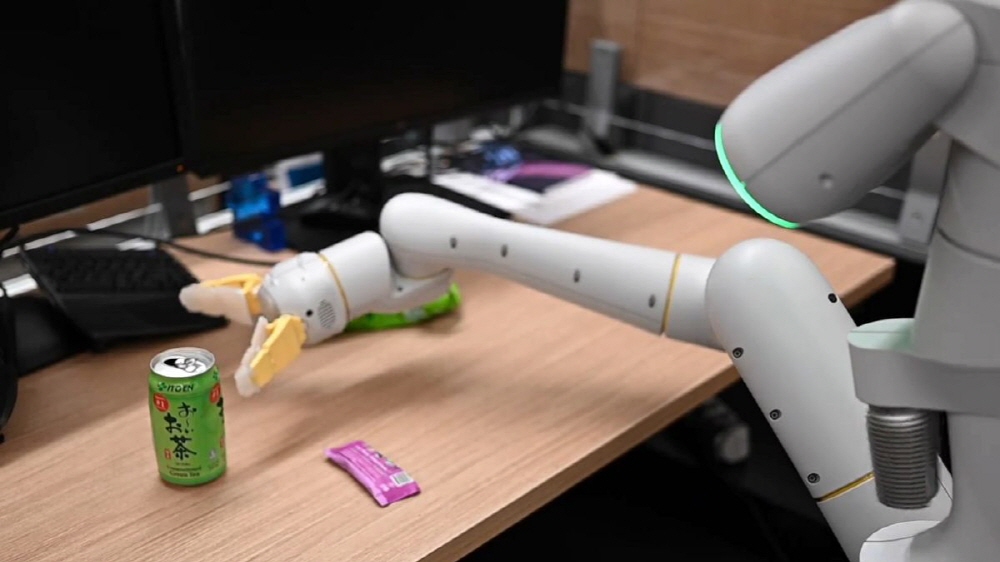

RT-2가 실행 가능한 태스크 예를 딸기를 올바른 그릇에 놓는다, 책상에서 떨어질 것 같은 옷을 들어 올린다, 레드불 캔을 이동시킨다 등 태스크를 올바르게 실행할 수 있다. 또 학습하지 않은 물체나 배경, 환경이 대상이 됐을 경우에도 지시대로 동작이 가능하다.

연구팀은 RT-2 데모 영상도 공개하고 있다. RT-2 연구 논문과 데모 영상도 여기에서 확인할 수 있다. 관련 내용은 이곳에서 볼 수 있다.