미국 캘리포니아대 샌프란시스코 연구팀이 뇌에 전극을 묻어 컴퓨터와 연결, 아바타에게 생각하는 애용을 말하는 기술을 개발했다. 아바타는 표정을 재현하는 것도 가능하며 뇌졸중 영향으로 말할 수 없게 된 여성이 목소리와 표정을 되찾는데 성공하고 있다.

캐나다에 거주하는 한 여교사는 2005년 뇌졸중으로 쓰러진 뒤 의식은 있는데 근육을 움직일 수 없는 상태가 됐다. 재활로 조금 몸을 움직이거나 간단한 소리를 낼 수 있게 됐지만 기기에 의지하지 않고 커뮤니케이션을 하는 건 곤란한 상태가 계속되고 있다. 이 때문에 그녀는 시선으로 알파벳을 선택해 문장을 기록하는 기기를 이용해 커뮤니케이션을 하고 있지만 해당 기기를 이용한 대화는 한 문장당 몇 분씩 시간이 걸린다.

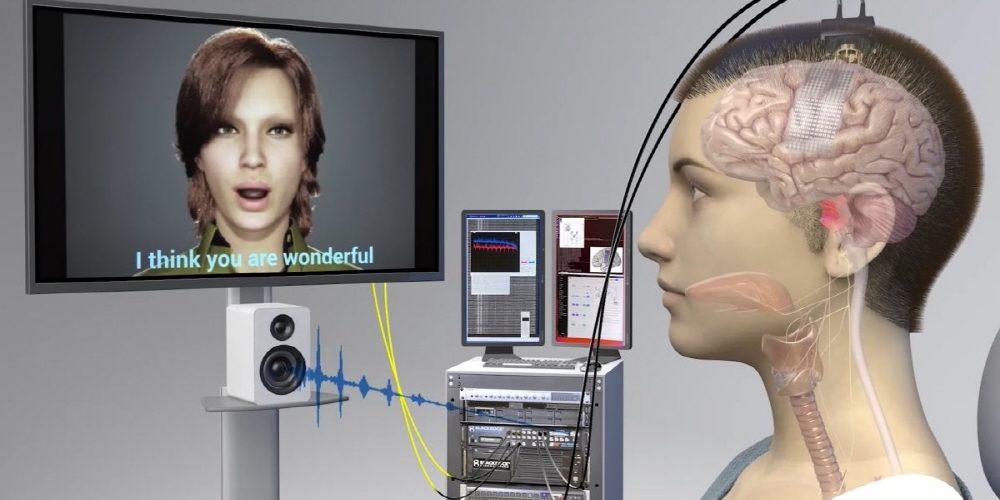

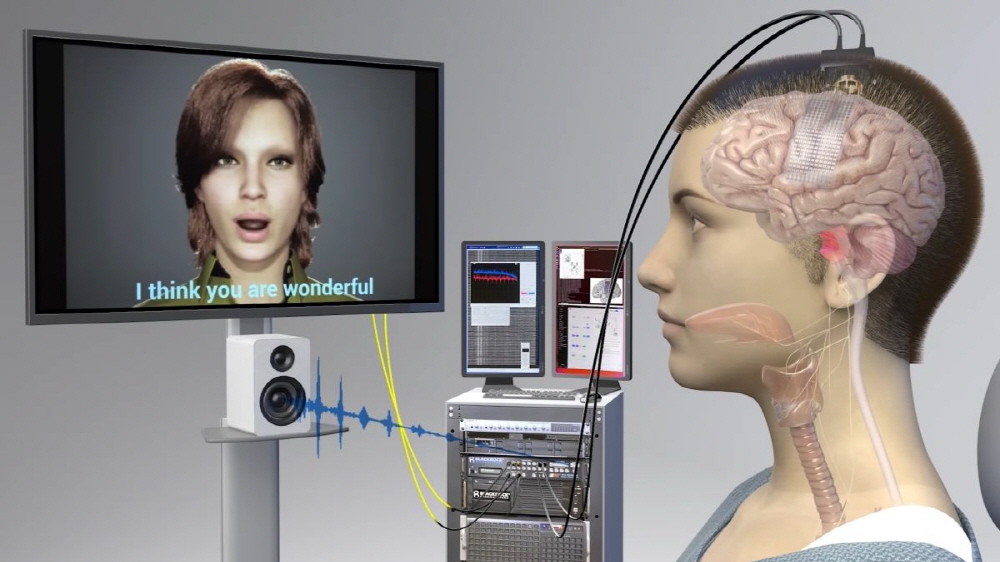

연구팀은 뇌에 전극 253개를 내장해 컴퓨터와 연결해 아바타에게 사고하는 내용을 말하는 기술을 개발했다. 전극은 뇌에서 말할 때 활발해지는 영역이나 표정을 변화시킬 때 활발해지는 영역에 내장해 대화나 표정 변화를 시도할 때 뇌 활동을 읽어 AI로 음성이나 표정으로 변환하면 아바타에 대화 내용과 표정을 적용할 수 있다.

개발한 AI는 발화하려는 단어가 아니라 발화하려는 소리 구성을 읽도록 학습되고 있다고 한다. 예를 들어 ‘Hello’라는 단어는 ‘HH’, ‘AH’, ‘L’, ‘OW’라는 4가지 음성 조합으로 인식된 다음 단어로 재구성된다. 이 소리 구성을 읽는 시스템 도입으로 단어를 직접 읽으려는 시스템보다 3배 빨리 음성화가 가능하게 됐다고 한다.

이번 연구에선 뇌와 컴퓨터가 유선 연결됐지만 연구팀은 앞으로 무선 접속으로 유사 시스템 구축을 목표로 하고 있다. 관련 내용은 이곳에서 확인할 수 있다.