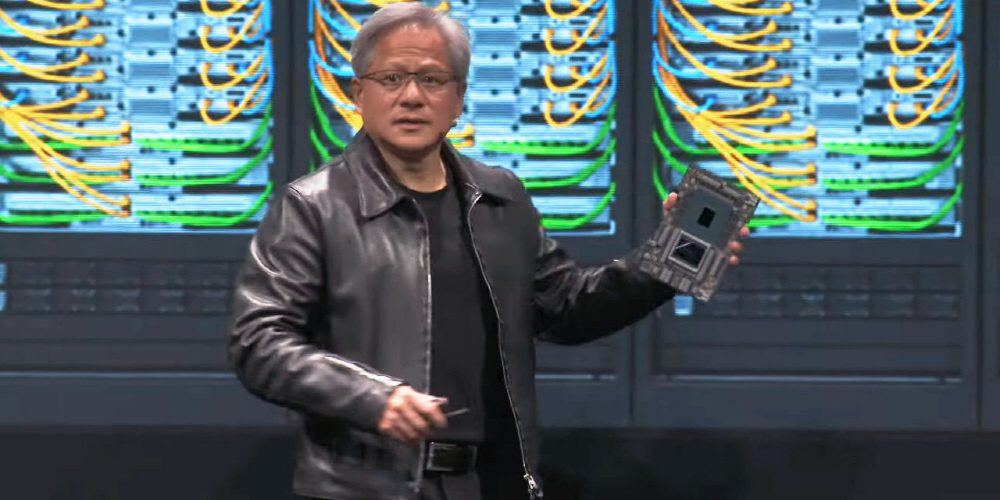

젠슨황 엔비디아 CEO가 5월 30일부터 대만 타이베이에서 개최된 컴퓨텍스 타이베이 2023 기간 중 제너레이티브 AI 학습이나 대규모 언어 모델 워크로드 등 대규모 AI 워크로드를 위한 슈퍼컴퓨터인 DGX GH200을 발표했다. DGX GH200 처리 성능은 1EFLOPS에 달하며 구글이나 마이크로소프트 등 클라우드 컴퓨팅으로 시험 운용될 예정이다.

젠슨황 CEO는 엔비디아 자체 ARM CPU인 그레이스(Grace), AI를 위한 GPU인 호퍼(Hopper)를 결합한 AI와 HPC 앱용 칩셋인 엔비디아 GH200 그레이스호퍼 슈퍼칩(NVIDIA GH200 Grace Hopper Superchip)이 생산 체제에 들어갔다고 밝혔다. 이 제품은 그레이스와 호퍼가 엔비디아 NV링크-C2C라는 기술로 연결되어 있으며 PCI 익스프레스 5.0 7배에 달하는 900GB/sec라는 대역폭을 실현하고 있다. 연산 성능은 4PFLOPS로 메모리로 96GB HBM3과 512GB LPDDR5X를 탑재하고 있다.

GH200 그레이스호퍼 슈퍼칩과 멀티 GPU 통신용 NV링크/NV스위치를 조합해 호퍼 GPU 최대 256개를 통합해 단일 GPU로 실행할 수 있도록 하는 플랫폼이 DGX GH200이다. 엔비디아 GH200 그레이스호퍼 슈퍼칩 256개를 통합해 이전 세대 DGX A100 500배에 이르는 합계 144TB 공유 메모리를 GPU 메모리로 이용할 수 있게 되며 연산 능력은 11EFLOPS에 이른다.

엔비디아 측은 제너레이티브 AI나 대규모 언어 모델 같은 거대 모델을 이용해 연산 처리를 하면 이미 메모리 용량이 한계에 도달하는 상황이라며 AI 연구자는 테라바이트 크기 이상 거대 메모리 용량을 필요로 하며 DGX GH200은 최대 256개 호퍼 GPU를 통합해 단일 GPU로 실행할 수 있도록 해 이런 요구에 부응할 수 있다. DGX GH200이 제너레이티브 AI와 대규모 언어 모델 병목 현상을 해소하는 큰 존재가 된다고 어필하고 있다.

이미 구글 클라우드, 메타, 마이크로소프트가 제너레이티브 AI 워크로드에서의 기능을 파악하기 위해 DGX GH200에 조기 액세스할 수 있게 된다고 한다. 구글 클라우드 마크 로메이어 부사장은 고급 생성 모델을 구축하려면 AI 인프라에 혁신적 접근이 필요하다며 대용량 공유 메모리는 대규모 AI 워크로드에서 발생할 수 있는 주요 병목 현상을 없애고 구글 클라우드가 해당 기능을 조사할 수 있기를 기대한다고 밝혔다.

엔비디아는 DGX GH200을 4개 조합한 슈퍼컴퓨터인 엔비이아 헬리오스(NVIDIA Helios)를 제안하고 있다. 엔비디아 헬리오스에선 DGX GH200이 각각 엔비디아 퀀텀-2 인피니밴드(NVIDIA Quantum-2 InfiniBand) 플랫폼에서 상호 연결되어 있다. 다시 말해 1,024개에 이르는 엔비디아 GH200 그레이스호퍼 슈퍼칩을 한 유닛으로 사용할 수 있게 된다. 엔비디아 헬리오스는 2023년 말까지 선보인다.

엔비디아는 또 컴퓨텍스 타이베이 2023 기간 중 제너레이티브 AI를 활용해 게임 캐릭터와 대화할 수 있는 기술인 엔비디아 ACE(Avatar Cloud Engine)를 발표했다. 공개된 데모에서 NPC와의 대화에 사용된 엔비디아 ACE는 NPC 배경 등을 학습시킬 수 있는 대규모 언어 모델을 탑재한 엔비디아 네모(NVIDIA NeMo), 자동 음성 인식과 텍스트 읽기로 음성 대화를 하는 엔비디아 리바(NVIDIA Riva), 발성에 맞춰 자연스럽게 캐릭터 표정을 변화시킬 수 있는 엔비디아 옴니버스 오디오2페이스(NVIDIA Omniverse Audio2Face)로 이뤄진 미들웨어 스위트다.

엔비디아 측 발표에 따르면 엔비디아 ACE는 한 번에 복수 캐릭터에 적용할 수 있어 NPC끼리 대화시키는 것도 가능하다고 한다. 존 스피처 엔비디아 부사장은 제너레이티브 AI는 플레이어가 게임 캐릭터와 인터랙티브성을 혁신해 게임에서의 몰입감을 극적으로 높일 가능성을 갖고 있다고 밝히고 있다. 관련 내용은 이곳에서 확인할 수 있다.