말하는 사람의 목소리에는 성별이나 나이, 인종 등 화자의 정체성이 나타난다. 인공지능 기술이 발전하면서 사람의 목소리에서 말하는 사람의 얼굴을 예상해 이미지를 생성해주는 AI 같은 게 등장하기도 했다. 하지만 마이크로소프트는 음성을 더 세밀하게 분석해 화자의 감정 뿐 아니라 얼굴 표정까지 애니메이션 영상으로 재현할 수 있는 AI를 개발했다.

지금까지 대화 음성을 AI로 분석하는 연구에서 사용하는 데이터세트는 알아듣기 쉽게 시원시원하게 말하는 대화 음성이 많이 쓰였다. 하지만 인간이 실제로 대화를 하는 상황은 주위에 잡음이 많고 소리도 화자의 감정과 다양한 버릇까지 더해진다.

마이크로소프트 연구팀은 대화 음성은 다양성으로 가득 차 있다면서 다른 사람이 다른 맥락에서 같은 단어를 발성하면 속도와 음정, 음색은 달라진다고 말한다. 또 화자의 감정 상태와 성별, 나이, 민족, 개성을 나타내는 정보가 대화 음성에 포함되어 있다고 설명한다. 이를 위해 VAE(variational autoencoder)를 이용해 대화 음성 분석을 실시했다.

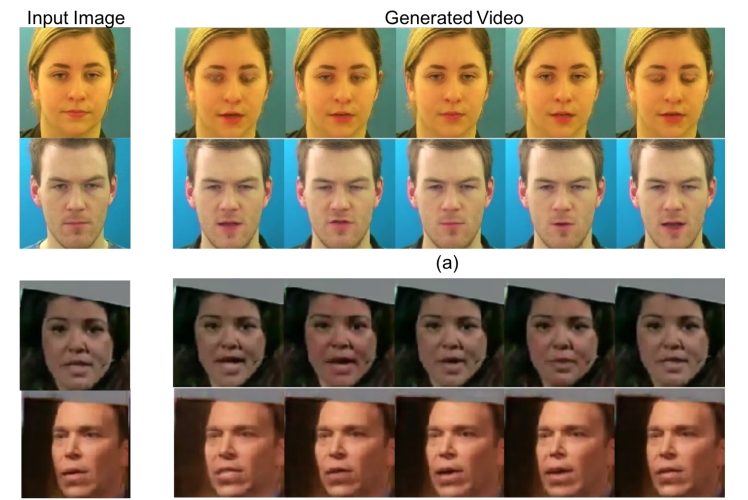

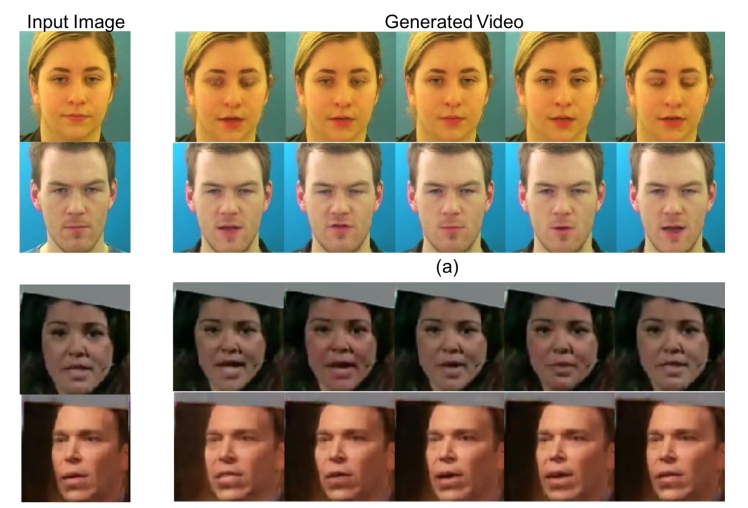

연구팀은 연사 34명을 통한 1,000개 이상 녹음이나 민족적으로 다양한 91명이 대화하는 영상 7,442개, 연설 동영상에서 가져온 10만 건 이상 음성을 데이터세트로 이용해 VAE에 학습시켰다. VAE는 입력된 대화 음성 파형을 음성 내용과 화자 감정, 기타 다양한 변동 요인을 분석했다. 그리고 입력된 얼굴 이미지와 분석 결과를 영상 생성기에 보내 애니메이션을 만들었다.

연구팀은 이번 연구는 음성 표현 학습 관점에서 AI 성능을 개선하는 첫 번째 방법이라면서 잡음이 많은 감정적인 대화 음성으로 테스트를 하고 이 모델을 검증해 이 같은 접근이 첨단 기술을 크게 능가하는 정밀도가 나온다는 걸 보여줬다고 주장했다. 관련 내용은 이곳에서 확인할 수 있다.