엔비디아가 책상 위에 둘 수 있는 AI PC인 DGX 스파크(DGX Spark)와 DGX 스테이션(DGX Station)을 발표했다. 기존에는 데이터센터에서만 활용할 수 있었던 엔비디아 그레이스 블랙웰(NVIDIA Grace Blackwell) 아키텍처 성능을 개인 개발자에게 제공하는 것으로 AI 연구자와 데이터 과학자가 대규모 AI 모델을 조정하는 데 도움을 줄 것으로 기대된다.

DGX 스파크와 DGX 스테이션은 모두 그레이스 블랙웰 아키텍처를 탑재했다. 이 아키텍처는 파라미터 수조 개를 처리할 수 있는 GPU인 블랙웰과 GPU와 긴밀히 결합해 대량 데이터를 효율적으로 처리할 수 있는 Arm 기반 CPU인 그레이스를 결합한 구조다.

DGX 스파크는 지난 1월 발표된 프로젝트 디짓(Project DIGITS) 후속 모델로 명칭을 변경해 새롭게 등장했다. 엔비디아는 이 제품을 데이터센터에서만 이용할 수 있던 그레이스 블랙웰 아키텍처 성능을 데스크톱 환경으로 가져온 것이라고 소개했다.

세계에서 가장 작은 AI 슈퍼컴퓨터로 불리는 DGX 스파크는 엔비디아 GB10 그레이스 블랙웰 슈퍼칩을 탑재했다. 엔비디아 물리 AI 모델인 코스모스 리즌(Cosmos Reason)과 휴머노이드 로봇용 모델 GR00T N1 등을 실행하며 초당 최대 1,000조 회 AI 연산을 수행할 수 있다. 이를 통해 코드 변경 없이 데스크톱에서 DGX 클라우드 같은 AI 플랫폼으로 쉽게 모델을 이동할 수 있으며 프로토타입 제작, 모델 조정 및 반복 작업이 용이해진다.

DGX 스테이션은 데스크톱에서 데이터센터 수준 성능을 제공하는 기기로 소개됐다. 엔비디아 GB300 그레이스 블랙웰 울트라 데스크톱 슈퍼칩을 탑재했으며 784GB 대용량 일관된 메모리 공간을 제공한다. 또 단일 포트로 800Gbps 속도를 구현하는 엔비디아 ConnectX-8 SuperNIC이 장착되어 있어 고속 네트워크 연결을 지원하고 DGX 스테이션 여러 대를 연결해 대규모 AI 작업을 수행할 수 있도록 설계됐다.

젠슨 황(Jensen Huang) 엔비디아 CEO는 AI는 기존 컴퓨팅 모든 측면을 혁신했다며 이제 AI 개발자를 위해 설계되고 AI 애플리케이션을 실행할 수 있는 컴퓨터가 등장하는 건 당연한 일이라며 이게 AI 시대 컴퓨터이며 미래 컴퓨팅 방식이라고 강조했다.

현재 DGX 스파크는 사전 예약을 받고 있으며 제품이 출시되면 예약자에게 알림이 제공된다. 가격은 공식적으로 공개되지 않았지만 이전 모델인 프로젝트 디짓이 3,000달러에 판매되며 5월 출하 예정이었던 점을 감안하면 유사한 가격대로 책정될 가능성이 높다. 또 에이수스, 델, HP 등의 제조사에서도 출시될 예정이다.

DGX 스테이션 역시 에이수스와 델, HP, 람다, 슈퍼마이크로 등 여러 파트너사를 통해 2025년 하반기 출시될 예정이다. 관련 내용은 이곳에서 확인할 수 있다.

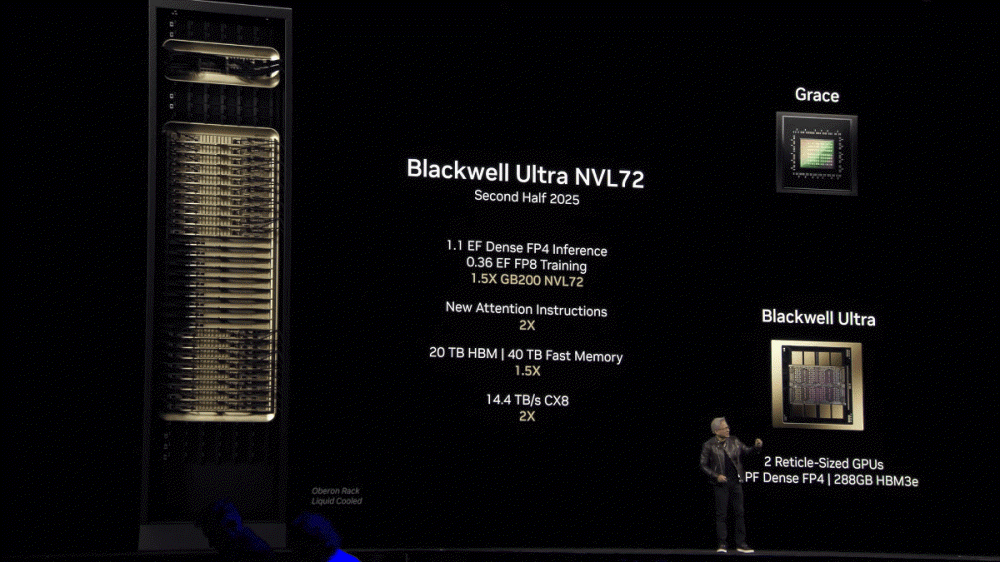

엔비디아는 또 AI 데이터센터를 위한 차세대 GPU 아키텍처 블랙웰 울트라(Blackwell Ultra), 베라 루빈(Vera Rubin), 루빈 울트라(Rubin Ultra)에 대한 세부 정보를 공개했다. 블랙웰 울트라를 탑재한 제품은 2025년 하반기 출시 예정이며 이전 세대 제품 대비 1.5배 높은 성능을 제공한다.

엔비디아는 블랙웰 울트라를 기반으로 한 데이터센터용 AI 처리 시스템 GB300 NVL72를 발표했다. GB300 NVL72는 블랙웰 울트라 GPU 72개와 Arm 기반 CPU 엔비디아 그레이스 36개를 탑재하고 있다.

블랙웰 울트라는 40TB 고속 메모리를 갖추고 있으며 스펙트럼-X 네트워킹 플랫폼(Spectrum-X Networking Platform) 및 퀀텀-X800 인피니밴드 플랫폼(Quantum-X800 InfiniBand Platform) 같은 고속 통신 시스템과 원활하게 통합되어 있다. 이를 통해 GB300 NVL72는 기존 모델인 GB200 NVL72보다 1.5배 높은 AI 처리 성능을 제공한다. 또 호퍼(Hopper) 세대 제품 대비 수익 창출 기회가 50배 증가했다.

블랙웰 울트라를 16개 탑재한 서버 보드 HGX B300 NVL16의 경우 기존 HGX H100 대비 Llama 3.1 405B 모델의 추론 속도가 11배 증가하며 학습 속도는 4배 향상된다.

엔비디아는 베라 루빈과 루빈 울트라에 대한 정보도 공개했다. 2026년 하반기에는 베라 루빈 GPU를 탑재한 데이터센터용 시스템 베라 루빈 NVL144가 출시될 예정이다. 이 시스템은 75TB 고속 메모리를 갖추고 있으며 GB300 NVL72 대비 3.3배 높은 성능을 제공한다.

이어 2027년 하반기에는 루빈 울트라 GPU를 탑재한 루빈 울트라 NVL576이 출시된다. 이 시스템 메모리 용량은 365TB에 이르며 GB300 NVL72 대비 14배 향상된 처리 성능을 갖춘다.

GB300 NVL72 트랜지스터 수는 130조 개에 이른다. 루빈 울트라 NVL576 GPU의 경우에는 더 거대한 형태를 띠며 트랜지스터 수는 1300조 개에 달한다.

호퍼 세대, 블랙웰 세대, 루빈 세대 성능과 비용을 비교한 결과 블랙웰은 호퍼 대비 68배 높은 성능을 제공하면서도 비용을 13% 수준으로 낮췄다. 루빈의 경우 호퍼 대비 성능이 900배 향상됐으며 비용은 3% 수준으로 절감됐다. 관련 내용은 이곳에서 확인할 수 있다.

엔비디아는 또 AI 및 테크니컬 컴퓨팅, 고성능 그래픽 처리에 특화된 GPU인 RTX 프로 블랙웰(RTX PRO Blackwell) 시리즈를 발표했다. 이 시리즈는 데이터센터, 데스크톱 PC, 노트북 등 다양한 환경에 맞춰 설계되었으며 사용자 필요에 따라 선택할 수 있다.

엔비디아는 RTX 프로 블랙웰 시리즈에 대해 AI 기반 워크플로를 처리할 수 있도록 설계됐으며 AI 에이전트, 시뮬레이션, 증강 현실(AR), 3D 디자인, 고급 비주얼 이펙트 등 다양한 애플리케이션을 강화할 수 있다고 밝혔다. 또 복잡한 시스템 설계, 엔지니어링, 몰입형 콘텐츠 제작 등 전문가가 필요로 하는 성능, 효율성, 확장성을 제공한다고 설명했다.

RTX 프로 블랙웰 시리즈는 기존 대비 최대 1.5배 빠른 데이터 처리 성능을 제공하며 AI 기능이 통합된 뉴럴 셰이더를 갖춘 새로운 엔비디아 스트리밍 멀티프로세서를 도입했다. 또 초당 최대 4,000조 회 연산을 수행하는 5세대 텐서 코어, 최대 96GB GDDR7 메모리를 탑재한 게 특징이다.

한편 RTX 프로 6000 블랙웰 서버 에디션은 패시브 쿨링 설계를 적용해 1대의 서버에 GPU 최대 8개를 장착할 수 있도록 했다. 엔비디아에 따르면 이 모델은 데이터센터 수준 컴퓨팅 밀도와 확장성이 필요한 워크로드에 최적화되어 있으며 헬스케어, 제조, 소매, 미디어 등 다양한 산업에서 활용될 수 있다.

RTX 프로 6000 블랙웰 워크스테이션 에디션과 RTX 프로 6000 블랙웰 Max-Q 워크스테이션 에디션은 PNY 및 TD SYNNEX 등 글로벌 유통업체를 통해 4월부터 구매할 수 있다. 이후 5월부터 델, HP, 레노버 등 제조사가 제품을 출시할 예정이다. RTX 프로 5000 블랙웰, RTX 프로 4500 블랙웰, RTX 프로 4000 블랙웰 모델은 델과 레노버를 통해 여름 출시될 예정이며 RTX 프로 블랙웰을 탑재한 노트북은 2025년 하반기 델, HP, 레노버, 레이저 등에서 출시될 계획이다. 관련 내용은 이곳에서 확인할 수 있다.

엔비디아는 휴머노이드 로봇 개발을 위한 오픈 기초 모델인 아이작(Isaac) GR00T N1을 발표했다. 이 모델은 언어 및 이미지를 처리하고 다양한 환경에서 조작 작업을 수행할 수 있도록 설계된 이중 시스템 아키텍처를 채택했다. 이를 통해 물체 조작, 팔 간 물체 전달 등 여러 작업을 단일 모델로 실행할 수 있다.

휴머노이드 로봇은 인간 작업 공간에 적응해 반복적이거나 높은 요구 사항을 충족하는 작업을 수행하도록 설계됐지만 다양한 작업과 예측 불가능한 환경에 대응하는 범용 로봇 개발은 어려운 과제가 되어왔다. 기존에는 특정 작업마다 개별 AI 모델이 필요했으며 이를 처음부터 학습시키려면 방대한 데이터, 높은 연산 비용, 낮은 범용성과 같은 문제를 해결해야 했다.

아이작 GR00T N1은 이런 문제를 해결하기 위해 언어와 이미지 등 멀티모달 입력을 처리해 다양한 환경에서 조작 작업을 수행하는 크로스 엠보디먼트(Cross-Embodiment) 모델이다. 한 번 학습된 모델을 여러 형태와 특성을 가진 휴머노이드 로봇에 적용할 수 있으며 개별 로봇에 맞춘 대규모 재학습이 필요하지 않아 개발 비용과 시간을 대폭 절감할 수 있는 게 강점이다.

아이작 GR00T N1은 인간 인지 과정을 모방한 이중 시스템 아키텍처를 적용했다. 먼저 시스템1은 반사적 행동 및 간단한 계산 등 신속한 의사 결정을 담당하고 시스템 2는 논리적 추론 및 신중한 의사 결정을 수행하는 저속 사고 시스템을 맡는다.

시스템1은 엔비디아 멀티모달 대형 언어 모델(LLM)인 이글(Eagle)과 허깅페이스 텍스트 추출 특화 모델 SmolLM-1.7B를 기반으로 한 시각 언어 모델이다. 이를 통해 환경과 명령을 해석해 로봇이 적절한 행동을 계획할 수 있다. 시스템2는 확산 변환기(diffusion transformer)로 시스템1이 수립한 행동 계획을 정밀한 연속적 로봇 동작으로 변환한다.

아이작 GR00T N1은 엔비디아가 제공하는 SimReady 데이터, Isaac Sim 및 Isaac Lab과 같은 시뮬레이션 프레임워크, 합성 데이터 설계도, 사전 학습된 모델을 결합해 개발됐다. 엔비디아에 따르면 6,500시간 분량 인간 시연 데이터를 75만 개 합성 경로로 변환하는 데 단 11시간이 소요됐으며 이 합성 데이터와 실제 인간 움직임 데이터를 결합해 순수 실험 데이터만 사용했을 때보다 성능이 40% 향상됐다.

아이작 GR00T N1에서 20억 개 파라미터를 갖춘 2B 모델은 일반에 공개됐으며 개발자는 허깅페이스를 통해 접근할 수 있다. 또 샘플 데이터셋과 파이토치(PyTorch) 스크립트가 깃허브에서 제공되고 있다. 관련 내용은 이곳에서 확인할 수 있다.

한편 엔비디아는 오픈AI o1 및 DeepSeek-R1과 같은 AI 추론 모델을 가속화하기 위한 라이브러리인 엔비디아 다이나모(NVIDIA Dynamo)도 공개했다. 이 라이브러리는 비용을 절감하면서도 추론 성능을 극대화할 수 있도록 설계됐으며 엔비디아는 DeepSeek-R1 모델 처리 속도가 30배 향상된다고 강조했다.

AI 추론 모델은 수만 개에 이르는 토큰을 생성해야 한다. 추론 비용을 지속적으로 낮추면서 성능을 향상시키면 AI 서비스 확장이 가속화되고 서비스 제공자 수익 기회도 증가하게 된다.

엔비디아 다이나모는 기존 엔비디아 트리톤 인퍼런스 서버(NVIDIA Triton Inference Server) 후속 버전으로 엔비디아는 이를 AI 추론 서비스를 도입하는 AI 팩토리의 토큰 수익을 극대화하기 위해 설계된 새로운 AI 추론 서빙 소프트웨어라고 소개했다.

이 라이브러리는 GPU 수천 개 간 통신을 최적화하고 가속화하며 분산 서빙(distributed serving) 방식을 활용해 LLM 처리 및 생성 단계를 각각 다른 GPU에서 수행할 수 있도록 한다. 이를 통해 각 단계가 특정 요구 사항에 맞춰 개별적으로 최적화될 수 있으며 GPU 리소스를 최대한 활용할 수 있다.

엔비디아 다이나모를 활용하면 동일한 GPU 수로도 엔비디아 호퍼 플랫폼에서 Llama 모델을 실행하는 AI 팩토리 성능과 수익을 2배로 늘릴 수 있다. GB200 NVL72 랙을 사용하는 대규모 클러스터에서 DeepSeek-R1 모델을 실행할 경우 엔비디아 다이나모의 최적화된 AI 추론 기능을 통해 GPU당 생성 가능한 토큰 수를 30배 이상 증가시킬 수 있다.

이를 가능하게 하기 위해 엔비디아 다이나모는 다음과 같은 기능을 제공한다. 첫째 변동하는 요청량과 종류에 맞춰 GPU를 동적으로 추가·제거·재할당, 둘째 대규모 클러스터 내 특정 GPU를 식별해 응답 계산을 최소화하고 최적의 쿼리 라우팅 수행, 셋째 추론 데이터를 저비용 메모리 또는 스토리지 장치로 오프로드하고 필요 시 빠르게 불러오는 기능 제공 등이다.

추가로 엔비디아 다이나모는 GPU KV 캐시를 GPU 수천 개에 매핑해 효율적으로 활용할 수 있도록 설계됐다. 새로운 추론 요청이 발생하면 가장 적절한 KV 캐시를 보유한 GPU로 요청을 라우팅해 불필요한 재계산을 피하고 GPU를 보다 효율적으로 활용할 수 있다.

엔비디아 다이나모는 또한 분산형 서비스 지원을 통해 사용자 쿼리 이해 및 최적 응답 생성 같은 LLM 내 다양한 계산 단계를 개별 GPU에 할당할 수 있다. 이 접근 방식은 엔비디아 최신 추론 모델인 Llama Nemotron 모델군과 같은 고급 AI 모델 추론 성능을 극대화하는 데 적합하다.

AI 가속화 클라우드 업체인 투게더AI(Together AI)는 자체 투게더 추론 엔진과 엔비디아 다이나모를 통합해 GPU 노드 간 추론 워크로드를 원활하게 확장할 계획이다. 이를 통해 모델 파이프라인 병목 현상을 동적으로 해결할 수 있을 것으로 기대된다.

엔비디아 다이나모는 오픈소스로 개발됐으며 PyTorch, SGLang, 엔비디아 TensorRT-LLM, vLLM 등을 지원한다. 이를 통해 기업, 스타트업, 연구자는 분산 AI 추론의 전체 프로세스를 최적화하고 효율적으로 활용할 수 있다. 소스 코드는 깃허브에서 공개되어 있다. 관련 내용은 이곳에서 확인할 수 있다.