메타가 이미지나 동영상 내 어떤 픽셀이 어떤 객체와 관련된 것인지 정확히 식별할 수 있는 통합 AI 모델인 SAM2(Segment Anything Model 2)를 발표했다. SAM 2를 이용하면 모든 객체를 세그먼트화하고 동영상 모든 프레임에 걸쳐 실시간으로 일관된 추적이 가능해져 동영상 편집이나 복합 현실 분야에서 혁신적인 도구가 될 가능성이 있다.

어떤 픽셀이 어떤 객체에 속하는지 올바르게 식별하는 세그멘테이션이라 불리는 작업은 과학적 이미지 분석이나 사진 편집 등 작업에 유용하다. 메타는 독자적인 세그멘테이션 AI 모델로 SAM(Segment Anything Model)을 개발했으며 인스타그램 AI 기능인 백드롭(Backdrop)과 컷아웃(Cutouts)에 활용되고 있다.

SAM은 인스타그램 외에도 과학과 의학, 그 외 많은 업계에서 다양한 애플리케이션 촉매제가 되고 있다고 한다. 예를 들어 해양과학 분야에서는 소나 이미지를 세그멘테이션해 산호초를 분석하는 데 이용되고 있으며 재난 구조 분야에서는 위성 이미지 분석에 사용되고 있고 의료 분야에서는 세포 이미지를 세그멘테이션해 피부암을 검출하는 데 도움을 주고 있다.

메타가 이런 SAM 차세대 모델인 SAM 2를 발표했다. SAM 2는 SAM이 갖고 있던 세그멘테이션 능력을 동영상으로까지 확장했으며 이미지 또는 동영상 내 임의 객체를 세그멘테이션하고 동영상 모든 프레임에 걸쳐 실시간으로 일관되게 추적할 수 있다. 세그멘테이션 능력을 동영상으로까지 확장했을 뿐 아니라 작업 시간도 3분의 1까지 단축할 수 있다.

동영상에서의 세그멘테이션은 이미지보다 훨씬 어렵기 때문에 기존 AI 모델로는 실현하기에 불충분했다고 한다. 동영상에서는 객체가 고속으로 이동하거나 외관이 변화하거나 다른 객체나 장면 일부에 가려지는 경우가 있다. SAM 2 구축에서는 이런 과제 많은 부분을 해결하는 데 성공했다.

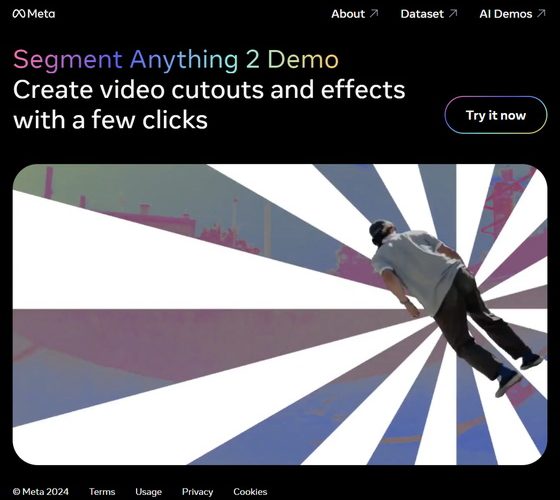

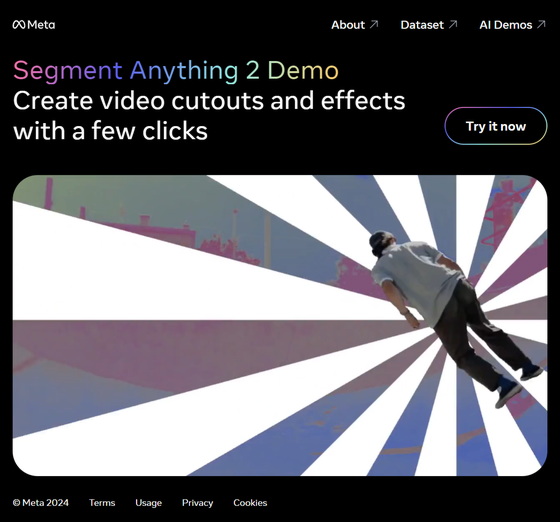

메타는 SAM 2 데모용 웹 앱도 공개해 그 높은 세그멘테이션 능력 수준을 실감할 수 있다. 또 SAM 2는 아파치 2.0 라이선스 하에 오픈소스화되어 깃허브에서 공개되어 있다. 이에 더해 메타는 SAM 2 트레이닝에 사용된 데이터세트인 SA-V를 CC BY 4.0 라이선스 하에 공개하고 있다. 관련 내용은 이곳에서 확인할 수 있다.