메타는 오픈소스 대규모 언어 모델인 LlaMA 3를 출시하거나 광고용 이미지나 텍스트를 생성하는 AI 도구를 도입하는 등 AI 개발과 활용을 적극 추진하고 있다. 이렇게 AI를 학습시키고 운영할 때 하드웨어를 어떻게 관리하고 있을까.

메타는 전통적으로 전 세계에 많은 데이터센터를 운영해왔지만 AI 등장으로 데이터센터 그룹을 혁신할 필요에 직면했다. 대규모 생성형 AI 모델의 경우 학습시킬 매개변수 수가 수조 개에 이르기 때문에 학습할 때 엄청난 리소스가 필요하다. 메타는 세계 최대 규모 AI 학습 인프라를 구축했으며 2025년에는 사용 GPU 수가 60만 개에 이를 전망이다. 매일 수백 개에 달하는 서로 다른 팀이 수천 개씩 학습 작업을 수행하고 있으며 작업에 따라 다수 GPU를 긴밀하게 연계해야 하는 경우도 있다고 한다.

메타 측은 AI를 학습시키기 위한 GPU 클러스터를 구축할 때 다음과 같은 조건을 충족해야 한다고 설명한다. 첫째 용량 대부분 작업은 신속히 수행해야 하므로 표준에서 대용량을 확보해둘 수 없다. 둘째 불량 호스트가 치명적인 대부분 작업에서 모든 호스트를 동기화해야 하므로 조금만 늦어도 하드웨어 문제가 조금만 있어도 혹은 네트워크 문제가 있어도 불량 호스트가 큰 문제가 된다. 셋째 중단 불가 AI 훈련 작업은 많은 호스트가 협력해서 수행하므로 중단이 발생하면 영향이 크다. 넷째 롤아웃 위험성 AI 소프트웨어 스택이 복잡해 문제 발생 시 원인 파악이 어려우므로 새 컴포넌트 롤아웃할 때 주의가 필요하다. 5번째 호스트 일관성 AI 학습 작업에서 다수 호스트를 사용할 때 쿠다 버전만 일치해도 하드웨어 호환성은 높겠지만 디버깅 효율성을 위해 하드웨어를 통일하는 게 중요하다.

메타에선 최신 칩과 고성능 백엔드 네트워크를 갖춘 맞춤형 하드웨어를 사용하고 있으며 그 위에서 소프트웨어를 가능한 한 최신으로 유지하고 유연하게 만들기 위해 노력하고 있다. 호스트 수가 많고 항상 다수 호스트를 병렬로 업데이트해야 하므로 컴포넌트간 호환성을 유지해 컴포넌트 업데이트를 슬라이딩 방식으로 순차적으로 수행할 수 있다.

다수 호스트를 일괄 운영하는 클러스터 유지보수에는 유지보수 열차(Maintenance train) 방식을 사용하고 있다. 유지보수 열차에서는 클러스터 내 소수 호스트가 차례로 운영에서 제외되고 그때마다 가능한 모든 업데이트를 적용한 뒤 클러스터로 복귀하는 작업을 반복한다. 각 호스트에 정기적으로 유지보수 시기가 도래해 가용성을 유지하면서 전체를 계속 업데이트할 수 있다.

또 인프라 규모가 커 중단을 동반하는 롤아웃은 모두 단계적으로 이뤄질 수 있도록 조정해야 한다. 다시 말해 클러스터 내 다른 호스트에 다른 구성이 있어도 작업을 원활히 수행할 수 있어야 한다. 이는 AI 학습 외에는 일반적이지만 AI 작업은 하드웨어와 긴밀히 연계되어 있어 어려운 문제다. 메타에서는 쿠다 라이브러리와 AI 작업 자체는 항상 일관성을 유지하지만 OS, 펌웨어, 네트워크 등 하위 컴포넌트는 단계적으로 변경할 수 있다. 간단해 보이지만 모든 레벨에서 신중한 테스트, 특별 모니터링, 벤더와의 긴밀한 협력 등 많은 작업이 필요했다고 한다.

AI 성능을 최적화하려면 동시 유지보수 호스트 수를 조정하는 것도 중요하다. 동시에 많은 호스트를 유지보수하면 일시적으로 처리 능력이 크게 떨어지지만 동시 유지보수 호스트 수가 적으면 실행 중 작업 중단이 대량 발생한다. 메타에서는 AI 팀과 협력해 최적의 숫자를 모색 중이라고 한다.

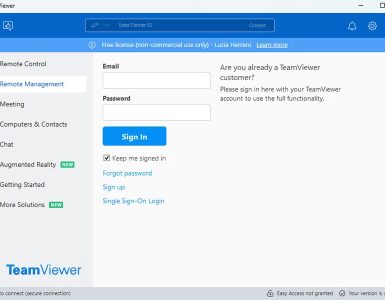

쿠다 버전 업데이트 등 관련 전체 호스트를 한꺼번에 업데이트해야 할 때는 옵스플래너(OpsPlanner)라는 도구를 사용한다. 옵스플래너를 사용해 자동으로 수천 개 호스트에 동시 작업을 수행하고 적절한 업데이트 후 프로덕션 환경으로 이전할 수 있다고 한다.

AI를 대규모로 운영하려면 단순히 강력한 하드웨어만으로는 부족하다. 메타는 소프트웨어 스택, 운영 체제, 시스템 모니터링 등 다양한 부문에서 지속적인 혁신을 거듭하고 있다. 예를 들어 AI 모델 훈련을 위한 분산 시스템인 PyTorch FSDP(Fully Sharded Data Parallel)는 메타에서 개발한 것으로 대규모 모델을 여러 GPU에 걸쳐 병렬 훈련할 수 있도록 지원한다. 또 인피니트 옵티마이저(Infinite Optimizer)라는 새로운 최적화 기술을 통해 모델 업데이트 효율성을 높였다.

운영 체제 측면에서는 AI 워크로드에 최적화된 맞춤형 리눅스 배포판인 퓨전OS(Fusion OS)를 개발했다. 이를 통해 셧다운 시간을 줄이고 리소스 활용도를 높일 수 있었다.

시스템 모니터링 부문에서는 슬레지해머(Sledgehammer)라는 도구를 활용해 GPU 메모리 사용량, 전력 소비량 등 수많은 메트릭을 종합적으로 모니터링할 수 있게 됐다.

그 밖에도 AI 인프라 효율성을 높이기 위한 다양한 노력을 기울이고 있다. 메타는 세계 최대 규모 AI 운영 인프라를 구축하고 지속적으로 발전시켜 나가며 AI 기술 혁신을 선도하고 있다. 관련 내용은 이곳에서 확인할 수 있다.