대규모 언어 모델(LLM)이 자신의 실수를 수정할 수 있도록 개발된 훈련 기법인 리플렉션 튜닝을 사용해 훈련된 오픈소스 LLM인 리플렉션 70B(Reflection 70B)가 발표됐다.

리플렉션 70B는 AI 개인 비서 하이퍼라이트(HyperWrite)를 개발하는 아더사이드AI(OthersideAI) CEO인 맷 슈머(Matt Shumer)가 AI 기업 그레이브AI(Glaive AI)와 공동으로 구축한 새로운 AI 모델이다.

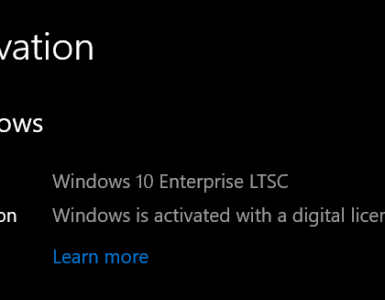

클로드 3.5 소넷, GPT-4o, 제미나이, Llama 3.1 405B 같은 LLM과 성능을 비교한 결과 멀티모달 언어 이해력을 측정하는 벤치마크 MMLU, 수학적 문제 해결 능력을 측정하는 벤치마크 MATH, 지시 따르기 능력을 평가하는 벤치마크 IFEval, 수학 능력을 평가하는 벤치마크 GSM8K에서 리플렉션 70B가 최고 성적을 기록했다. 또 고급 추론 능력을 평가하는 벤치마크 GPQA와 프로그램 합성 능력을 평가하는 벤치마크 HumanEval도 실시됐으며 이 모든 벤치마크에서 GPT-4o를 능가하는 성능을 보였다고 한다. 이런 벤치마크 결과를 바탕으로 리플렉션 70B는 세계 최고 오픈소스 LLM임을 강조하고 있다.

I'm excited to announce Reflection 70B, the world’s top open-source model.

— Matt Shumer (@mattshumer_) September 5, 2024

Trained using Reflection-Tuning, a technique developed to enable LLMs to fix their own mistakes.

405B coming next week – we expect it to be the best model in the world.

Built w/ @GlaiveAI.

Read on: pic.twitter.com/kZPW1plJuo

리플렉션 70B는 메타 오픈소스 LLM인 Llama 3.1 70B Instruct를 기반으로 하며 다른 Llama 모델과 동일한 코드 및 파이프라인을 사용하면서 리플렉션 튜닝이라 불리는 LLM에게 실수를 인식시키고 답변을 확정하기 전에 스스로 수정하게 하는 방법’을 도입한 것이다. 리플렉션 70B는 추론과 오류 수정을 위한 새로운 특수 토큰을 도입해 사용자가 보다 구조화된 방식으로 모델과 상호작용할 수 있게 됐다. 추론 중 리플렉션 70B는 특수 태그 내에 추론을 출력하므로 오류가 감지된 경우 실시간으로 이를 수정할 수 있다고 한다. 또 리플렉션 70B는 계획 단계와 답변 생성 단계를 분리해 Chain-of-Thought 접근 방식 효과성을 도입하면서도 최종 사용자에게는 단순하고 간결한 출력이 되도록 한 것으로 보인다.

또 리플렉션 70B는 데이터 오염 여부를 확인하기 위해 LMSys의 LLM Decontaminator를 사용했다. 리플렉션 70B는 허깅페이스에서 이용 가능하다.

리플렉션 70B보다 파라미터 수가 더 큰 리플렉션 405B도 출시 예정이며 리플렉션 70B는 하이퍼라이트에 통합될 예정이라고 한다.

한편 리플렉션 70B는 그라이브 AI가 작성한 데이터세트를 사용해 훈련됐다. 그라이브 AI는 AI 개발에서 가장 큰 병목 현상 중 하나인 고품질 작업 특화 데이터 가용성 해결에 중점을 둔 기업으로 특정 요구에 맞는 합성 데이터세트를 만들어 기업이 AI 모델을 빠르고 저렴하게 미세 조정할 수 있도록 지원하고 있다. 관련 내용은 이곳에서 확인할 수 있다.