미국 미네소타대 트윈 시티즈 연구자가 메모리 셀 내에서 직접 계산을 수행해 데이터 전송을 억제하고 비용을 절감하면서도 높은 성능을 실현하는 하드웨어 장치를 실증했다. 이를 통해 AI 에너지 소비량을 최대 2500분의 1로 줄일 수 있다.

일반적인 컴퓨팅에서는 데이터를 처리하기 위한 프로세서와 데이터를 저장하는 메모리 사이에서 데이터가 항상 이동하게 된다. AI 컴퓨팅의 경우 계산이 복잡하고 대량 데이터를 주고받기 때문에 에너지 소비량이 많아진다.

국제에너지기구(IEA) 연례 보고서에 따르면 AI를 포함한 데이터센터 에너지 소비량은 2022년 기준 460TWh였지만 2026년에는 1000TWh로 2배 증가할 전망이다.

이런 상황을 개선할 가능성이 있는 게 미네소타 대학이 연구하는 CRAM(computational random-access memory)이다. 이 연구는 20년 이상 전부터 진행되어 왔으며 미국 국방고등연구계획국(DARPA)과 미국 국립표준기술연구소(NIST), 미국 국립과학재단(NSF), 네트워크 장비 제조업체인 시스코로부터 자금 지원을 받고 있다고 한다.

연구팀은 20년 전에는 메모리 셀을 직접 컴퓨팅에 사용한다는 개념이 미친 것처럼 여겨졌지만 2003년 이래로 성장을 거듭하는 학생 그룹과 미네소타 대학에 설립된 물리학, 재료 과학 및 공학, 컴퓨터 과학 및 공학, 모델링과 벤치마크, 하드웨어 제작 등을 횡단하는 연구팀 덕분에 긍정적인 결과를 얻을 수 있었다고 밝혔다. 이젠 이런 종류 기술이 실현 가능하며 기술에 통합할 준비가 되어 있다는 걸 실증하고 있다고 덧붙였다.

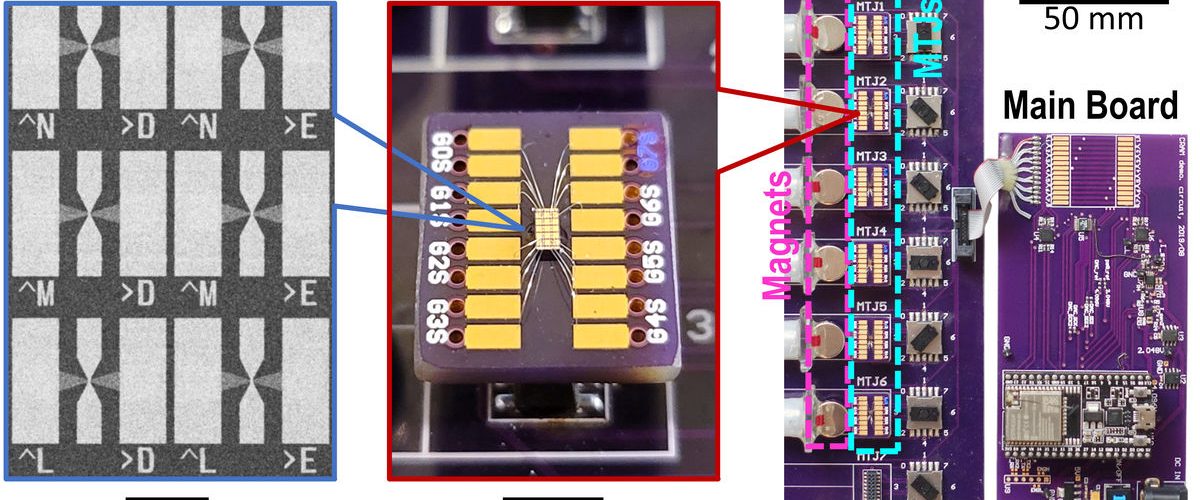

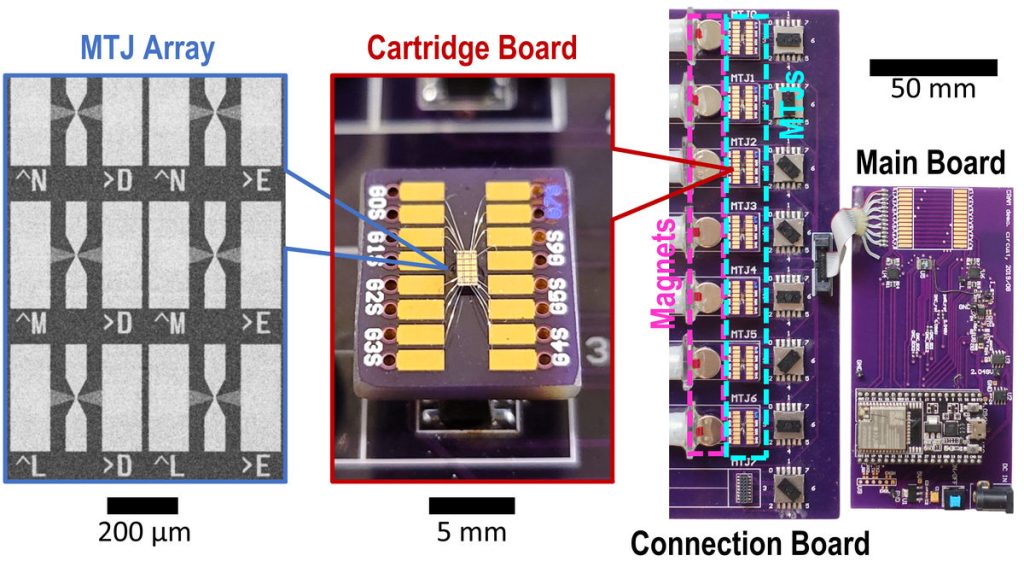

CRAM은 연구팀이 연구하고 특허도 취득한 MTJ(Magnetic Tunnel Junctions)에 기반한 장기적인 노력 일환으로 기존 메모리처럼 전하에 의존하지 않고 전자 스핀을 이용해 데이터를 저장해 기존 메모리 칩보다 더 빠르고 에너지 효율이 높다.

또 다양한 AI 알고리즘에도 대응할 수 있어 AI 컴퓨팅을 더 유연하고 에너지 효율적으로 만드는 해결책이 될 것으로 예상된다. 실제로 스칼라 덧셈이나 행렬 곱셈과 같은 주요 AI 작업을 수행했을 때 0.47μJ 에너지를 사용해 434 나노초 만에 실행할 수 있었다고 한다. 이는 기존 메모리 시스템과 비교해 2500분의 1이라는 에너지 절감을 의미한다고 한다. 관련 내용은 이곳에서 확인할 수 있다.