채팅 AI 클로드(Claude) 등을 개발하는 AI 기업 앤트로픽(Anthropic)이 AI 안전성에 관한 정책 반성점을 발표했다. 이번에 발표된 반성을 토대로 새로운 정책이 수립될 예정이다.

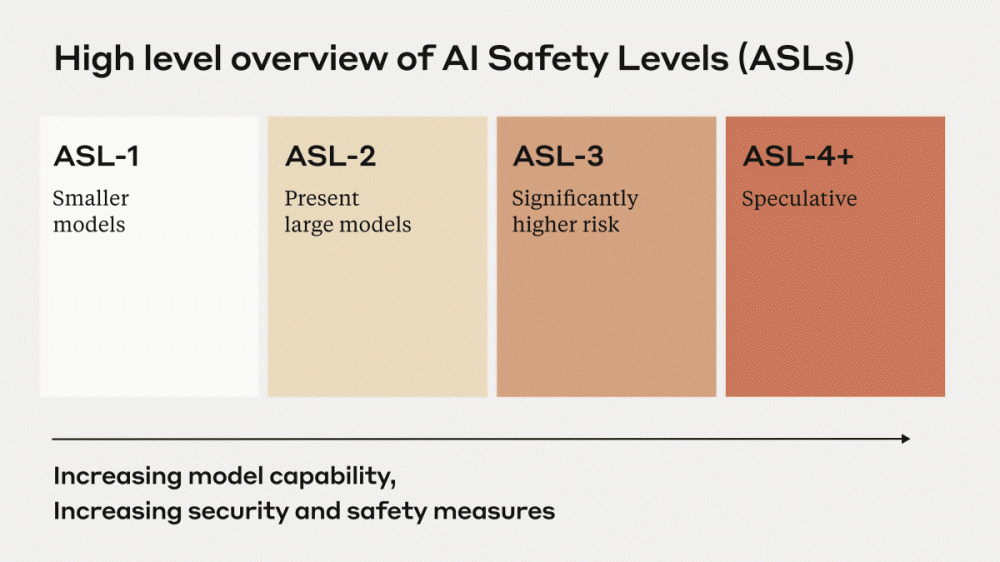

앤트로픽은 오픈AI에서 GPT-2와 GPT-3 개발에 참여했던 다리오 아모데이가 CEO를 맡고 있는 AI 기업. 앤트로픽은 AI 성능 향상에 따른 안전 위협을 AI 안전 레벨(ASL)이라는 지표로 분류하고 있다. 이를 통해 심각한 위험을 초래하지 않는 AI를 ASL-1, 생물 무기 개발 등에 악용될 조짐을 보이는 AI를 ASL-2, 검색 엔진이나 교과서와 비교해 파괴적 위험을 초래하는 AI를 ASL-3, 현재 AI와는 차원이 다른 성능을 지니고 위험도를 정의할 수 없는 AI를 ASL-4로 규정하고 있다.

앤트로픽 제품인 채팅 AI 클로드를 포함해 현재 주류인 채팅 AI는 ASL-2에 해당한다. 앤트로픽은 ASL-2에 해당하는 AI를 안전하게 개발하기 위해 큰 위험을 초래할 수 있는 레드라인 기능을 특정해 정보를 공개하고 레드라인 기능을 안전하게 다루기 위한 새로운 표준을 개발 및 구현하는 작업에 주력하고 있다. 이 중 레드라인 기능을 안전하게 다루기 위한 새로운 표준 개발 및 구현 작업은 ASL-3 표준이라고 불리는데 기존 정책으로는 ASL-3 표준을 충분히 추진할 수 없다고 한다.

새롭게 앤트로픽은 정책 개선 작업을 진행하는 데 있어 중요한 기존 정책에 대한 반성점을 공개했다. 반성점에는 신세대 모델에는 모델마다 새로운 기능이 추가되어 있어 미래 모델 특성을 예측하기 어렵다, 화학, 생물학, 방사성 물질, 핵 등 비교적 정립된 분야에서조차 전문가마다 어떤 위험이 더 큰 영향을 미치는지, AI 능력이 어떤 위험을 초래하는지에 대한 의견이 갈린다는 개선이 필요한 부분도 포함되어 있다.

그 밖에도 분야별 전문가와의 신속한 피드백 사이클은 테스트나 작업 문제점 인식에 도움이 됐다거나 위협 모델을 정량화하려는 시도는 우선 기능이나 우선 시나리오를 결정하는 데 도움이 됐다는 식으로 앞으로도 계속 활용해야 할 조치도 포함되어 있다.

앤트로픽은 기존 정책에서의 반성점을 바탕으로 정책을 개선하고 새로운 정책을 곧 공개할 예정이다. 한편 아모데이 앤트로픽 CEO는 ASL-4에 해당하는 현재 AI와는 차원이 다른 성능을 지니고 위험도를 정의할 수 없는 AI가 2025∼2028년 사이 등장할 것으로 내다봤다. 관련 내용은 이곳에서 확인할 수 있다.