메타 AI 연구조직인 메타AI리서치가 2월 24일 발표한 대규모 언어 모델인 LLaMA(Large Language Model Meta AI)는 파라미터 수가 작아 단일 GPU에서도 동작 가능하다. 이런 LLaMA를 아이폰이나 픽셀 같은 스마트폰으로 동작시키는 것에 한 엔지니어가 성공했다고 보고하고 있다.

메타AI리서치가 발표한 LLaMA는 위키피디아나 C4 등 일반적으로 공개되어 있는 데이터세트로 학습이 이뤄지고 있다. 한편 오픈AI가 제공하는 GPT-3 같은 언어 모델은 일부 비공개 데이터세트를 이용해 학습을 실시했다. 따라서 LLaMA는 오픈소스와 호환되는 재현 가능한 작업이 가능하다.

또 GPT-3 파라미터 수가 1,750억인 반면 LLaMA 파라미터 수는 70억에서 650억으로 상당히 적다. 하지만 벤치마크에서 일부 테마에선 LLaMA는 GPT-3을 뛰어넘는 성능을 나타내기도 했다.

파라미터 수란 기계학습 모델이 데이터에 근거해 예측이나 분류를 실시하기 위한 변수량으로 기계학습 모델 성능을 좌우하는 지표다. 매개변수 수가 클수록 더 복잡한 작업 처리가 안정되지만 동시에 요구되는 컴퓨터 성능도 높아진다. 한편 LLaMA는 파라미터 수가 작지만 GPT-3과 같은 대규모 언어 모델과 같은 태스크 처리를 할 수 있기 때문에 소비자 수준 하드웨어 환경에서도 동작할 가능성이 있다.

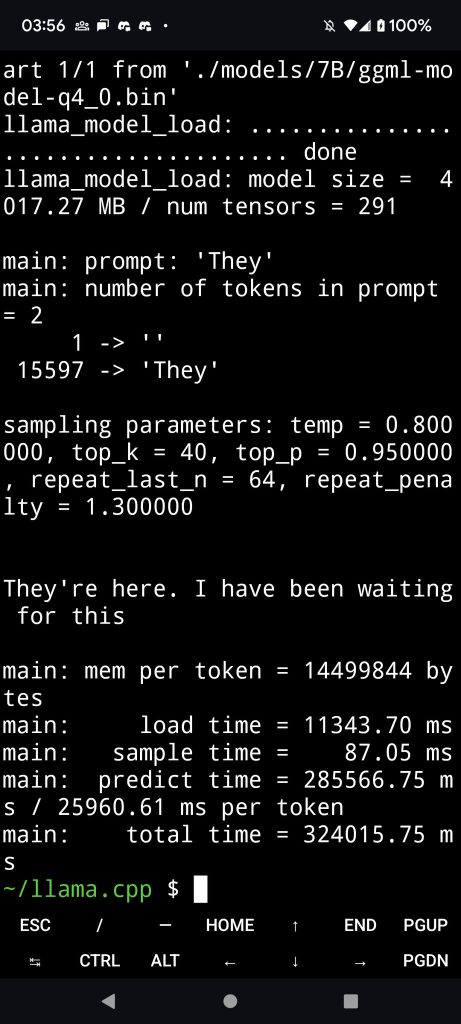

또 70억에서 650억으로 파라미터 수가 적기 때문에 LLaMA는 M1 애플실리콘 탑재 맥에서 동작한다는 게 보고되기도 했다. 한 엔지니어가 3월 14일 웹앱 프레임워크인 Next.js를 이용해 iOS에서 실행하는데 성공했다고 보고했다. 그는 또 LLaMA를 픽셀6에서 실행하는 데에도 성공했다. 한편 그는 픽셀6에서 동작한 LLaMA에 대해 픽셀에 최적화되지는 않았다고 보고했다. 또 자신은 맥에서 LLaMA를 양자화하고 스마트폰 용량에 최적화된 가중치를 픽셀로 전송했다고 설명했다.

더구나 그는 픽셀에서 동작한 LLaMA 생성 시간이 느린 점에 대해 생성이 느린 원인은 로딩 시간에 문제가 있는 것 같다며 리눅스 환경을 실행할 수 있는 에뮬레이터(Termux)를 실행하고 있는 게 원인일지도 모른다고 추측하기도 했다. 관련 내용은 이곳에서 확인할 수 있다.