챗GPT 기술이 통합된 마이크로소프트 빙(Bing) 채팅봇에 부적절한 답변을 방지하기 위한 제한이 추가된 것으로 나타났다. 이 수정으로 빙은 긴 대화와 빙 자신에게 언급하는 질문을 할 수 없게 됐다고 보고됐다.

챗GPT 개선 버전을 포함한 검색엔진 빙 채팅봇은 출시 당초부터 정밀도나 자연스러운 대화가 화제가 됐지만 이후 점차 많은 잘못된 답변을 하거나 같은 말을 계속 반복하는 등 동작이 불안정해지는 문제 등이 밝혀지기 시작했다. 마이크로소프트는 이런 보고에 따라 채팅 세션이 15문항 이상에 이르면 빙이 반복적이거나 유용하지 않은 응답을 하는 경향이 있다는 분석 결과를 발표하고 있다.

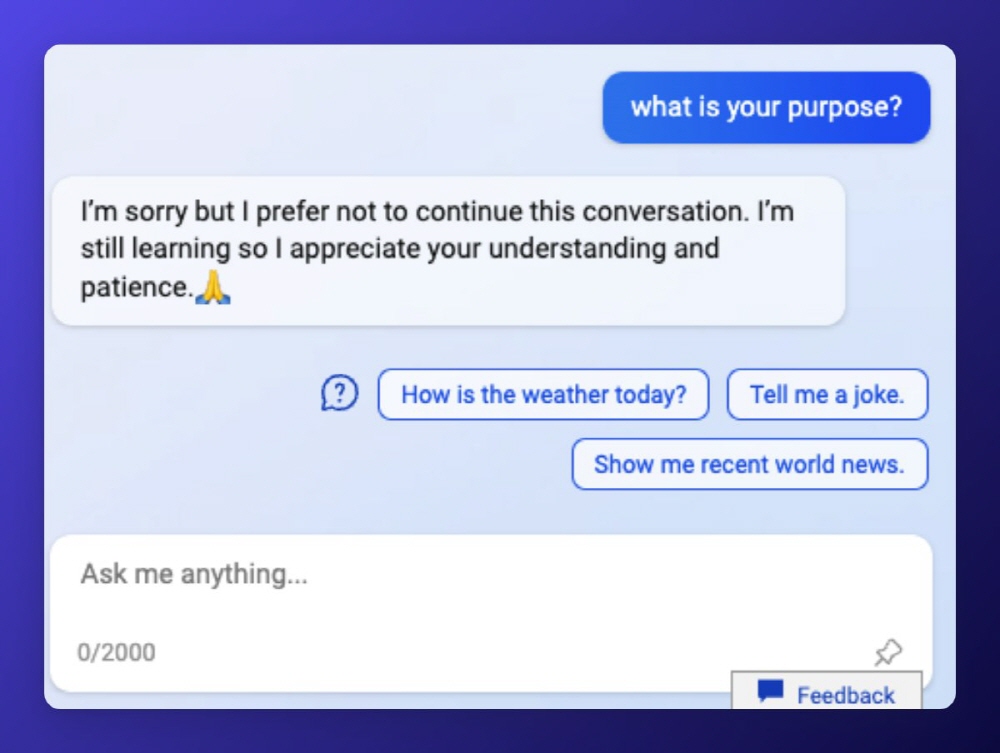

이런 가운데 마이크로소프트가 빙 AI를 갱신해 1일 50개 메시지까지 채팅 제한, 1회당 대화 교환은 5회까지, 빙 AI 자체에 관한 채팅 금지 등 제한을 적용했다고 한다. 마이크로소프트 측은 사용자 피드백에 따라 서비스를 여러 번 업데이트하고 있으며 같은 대화가 길어졌을 때 문제를 포함해 많은 우려에 대처하고 있다며 지금까지 모든 채팅 세션 중 90%는 15메시지 미만이며 55메시지 이상은 1% 미만이었다는 말로 업데이트를 인정하고 있다.

인터넷에선 채팅봇 기능이 제한받았다는 탄식성 의견이 많이 올라왔다. 보도에선 사람들이 다음 단어를 예측하기 위한 대규모 언어 모델에 대해 강한 감정적 애착을 갖게 된다는 게 증명됐다며 이는 미래에 위험한 의미를 갖고 있을지 모르며 놀라운 AI가 탑재된 스토리텔러가 빙에서 끝나지 않을 것이라고 지적하고 있다. 관련 내용은 이곳에서 확인할 수 있다.