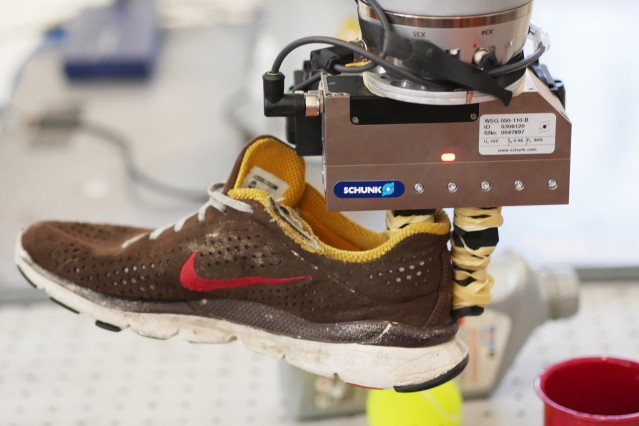

MIT 컴퓨터·인공지능연구소인 CSAIL(Computer Science and Artificial Intelligence Laboratory)이 DON(Dense Object Nets) 신경망을 이용해 시각 정보에서 물건의 시각적 로드맵을 그려내는 연구를 하고 있다. 시각 로드맵을 만드는 데 걸리는 시간은 평균 20분 남짓. 물건을 모든 각도에서 보면서 물체의 포인트를 선택한다. 이를 바탕으로 물건을 3D로 인식하는 것이다.

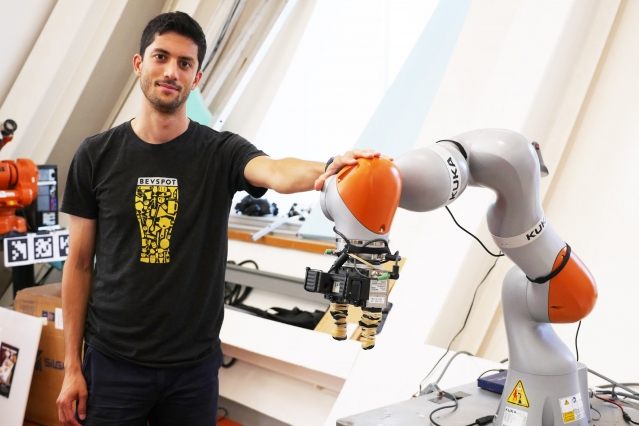

로봇은 물건을 학습한 다음 인간이 어떤 포인트에 대해 말해주면 나머지는 로봇이 알아서 처리를 한다. 이 실험을 통해 로봇은 처음 보는 신발과 인형을 들어 올리는 데 성공했다. 미래에는 인간의 도움 하나 없이도 로봇팔이 물건을 인식해 처리를 할 수도 있을 것으로 기대된다.

컴퓨터비전에 대한 연구는 지난 수십 년 동안 이뤄져 왔다. 하지만 신경망이 물건을 3D로 자기 학습한다는 건 새로운 시도라고 할 수 있다. 물건을 잡는 건 단순하지만 로봇 입장에선 어떤 물건인지 알아야 하는 문제가 있는 만큼 복잡한 일 중 하나다. 이 같은 연구가 계속 진행된다면 언젠가는 로봇이 인간처럼 실시간으로 물건을 인식할 수 있게 될 수 있다.

연구팀은 이 프로젝트에 대한 결과를 조간만 로봇 컨퍼런스에서 발표할 예정이다. 관련 내용은 이곳에서 확인할 수 있다.