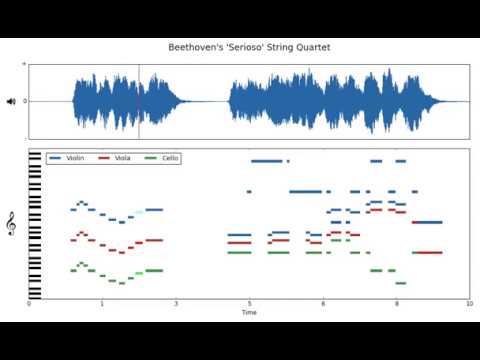

음악을 연주하는 동영상만 듣고 특정 악기 소리를 따로 분리해낼 수 있다면? MIT 산하 컴퓨터과학·인공지능연구소 CSAIL(Computer Science and Artificial Intelligence Laboratory)이 이처럼 특정 악기 소리만 빼낼 수 있는 인공지능 시스템인 픽셀플레이어(PixelPlayer)를 개발해 눈길을 끈다.

이 제품이 그냥 소리만 듣고 악기를 인식해 하나씩 뽑아낸다는 게 아니다. 픽셀플레이어는 동영상 속에 보이는 악기를 픽셀 수준으로 식별해낸다. 그런 다음 이 악기 소리를 추출해낸다. 사람이 별다른 조작을 하지 않아도 영상과 음악을 동시에 분석해 동기화하는 것. 그런 다음 동영상에서 연주하는 사람과 음성을 연계, 동영상을 클릭하기만 해도 특정 악기 소리를 빼거나 악기마다 따로 음량을 조절할 수도 있다.

CSAIL이 올린 샘플 영상을 보면 기타와 바이올린을 연주하는 듀오 중 기타 소리만 듣고 싶다면 기타를 연주하는 남성을 클릭한다. 이렇게 하면 기타 소리만 추출해낸다. 트럼펫과 튜버로 연주하는 영상 속에서도 마찬가지. 다른 악기 소리는 줄이거나 아예 없애고 트럼펫 소리만 키울 수도 있다.

(동영상 위 픽셀플레이어 이용)

픽셀플레이어는 딥러닝 기술을 통해 60시간 분량 이상 연주 동영상을 분석해 20개 이상 악기 소리를 식별할 수 있다. 물론 앞서 설명했듯 이들 악기는 각각 음량을 자유롭게 조절할 수 있다. 물론 악기에 따라 추출한 소리 품질에는 아직 차이가 있지만 더 많은 학습 데이터가 있다면 당연히 식별할 수 있는 악기 수나 품질도 늘어난다. CSAIL 측은 픽셀플레이어 데이터셋과 코드를 곧 공개할 예정이라고 한다.

픽셀플레이어가 어디에 쓰일 수 있을까. 과거 연주 동영상 음질이나 음량을 조절해 듣기 쉽게 튜닝을 하는 건 물론 주위 소음을 구별할 수 있도록 하는데 응용할 수도 있을 것으로 보인다.

인공지능을 활용하려는 분야에 예외는 없는 듯하다. 음악 같은 예술 분야에서도 인공지능을 접목하려는 시도는 계속 이어지고 있는 것.

소니컴퓨터과학연구소(Sony CSL)는 지난 2016년 인공지능을 이용해 만든 팝송 2곡을 유튜브를 통해 공개한 바 있다. 플로우머신(Flow Machines)이라고 불리는 인공지능 소프트웨어를 이용해 방대한 음악 데이터를 통해 음악 스타일을 학습한다. 인공지능이 엄청난 데이터에서 음악 스타일을 학습한 다음 이를 조합해 스스로 작곡을 했다는 것이다.

이 과정을 거친 곡은 LSDB라고 불리는 데이터베이스에 1만 곡이 넘는 곡을 등록한 뒤 이를 통해 작곡한 것이다. 사람은 예를 들어 가수로 치면 비틀즈 식으로 스타일만 고르면 된다. 실제 연구소 측이 공개한 음악은 인간 작곡가와 작사가가 참여해 편곡을 해 완성한 것이지만 상당한 관심을 끌었다.

딥재즈(deepjazz)는 지난 2016년 국내 프로그래머가 36시간 만에 해커톤에서 만들었다는 자동 재즈 생성기. 파이썬을 이용해 딥러닝 라이브러리인 케라스(Keras)와 테아노(Theano)를 이용해 장-단기 메모리 LSTM(Long short-term memory)에서 미디 파일로 학습 과정을 거쳐 재즈를 작곡한다. 재즈를 작곡해주는 인공지능인 것.

지난 2016년 미국 워싱턴대학 연구팀은 클래식 음악을 분석, 방대한 데이터셋인 뮤직넷(MusicNet)을 발표한 바 있다. 330곡에 달하는 무료 음원을 분석해 연주되는 모든 음정이나 발음, 타이밍까지 세밀하게 데이터화하는 데 성공한 것이다. 이 과정 중 모은 소리 데이터만 해도 100만 개가 넘는다고 한다. 이 과정을 거치면 실제로 울리는 소리를 바탕으로 자세한 악보를 채보한 데이터라고 할 수 있다. 물론 결국 이런 데이터셋 역시 인공지능에 음악을 접목해 음악을 재구축하려는 시도의 일환으로 진행된 것이다. 이 같은 분석은 이미 작곡한 음악을 더 잘 이해할 때에도 도움이 될 수 있는 건 물론이다. 이전까지만 해도 사람의 귀나 손의 힘을 빌리던 일을 데이터를 바탕으로 자동 처리한다면 음악을 이해하는 방식 자체가 바뀔 수도 있다.

픽셀플레이어의 예에서 봤듯 데이터 인식 대상에 음악만 들어가 있는 건 아니다. 같은 해 토론토대학 연구소는 크리스마스트리 사진 1장만으로 이미지를 인식하고 이를 바탕으로 해당 이미지에 어울리는 음악을 생성하는 인공지능을 발표했다. 100시간이 넘는 온라인 음악을 바탕으로 신경망을 이용해 학습 과정을 거친 인공지능이 분당 120비트 멜로디를 만들고 화음에 드럼 소리를 추가하는 등 음악을 만들어낸 것이다. 곡의 완성도를 떠나 이미지를 인식해 분위기에 맞는 음악을 생성한다는 점에서 눈길을 끈다.

이미지나 동영상 등을 인식하거나 음악 자체를 분석해 분류하고 데이터화는 건 뿐 아니라 심지어 새로운 소리를 만들어낼 수도 있다. 구글이 지난 3월 발표한 엔씽크 슈퍼(NSynth Super)는 머신러닝을 통해 이전과는 전혀 다른 소리를 만들어낼 수 있는 신디사이저다. 가로세로 20cm에 불과한 작은 제품이지만 수많은 데이터를 내장했고 터치 센서와 디스플레이를 통해 악기 4가지 성분을 지정하면 새로운 음색을 알아서 만들어준다. 플루트와 스네어드럼 특징을 합쳐서 아예 새로운 소리를 만들어내는 식이다. 이렇듯 음악을 만난 인공지능이 발전을 거듭하고 있다.