구글이 3월 12일 오픈소스로 상업적 이용도 허용된 대규모 언어 모델 젬마3(Gemma 3)를 발표했다. 구글에 따르면 젬마3는 단일 GPU 또는 TPU에서 실행 가능한 대규모 언어 모델로는 세계 최고 수준 모델이라고 한다.

구글은 제미나이 연구 자원을 활용한 오픈소스 대규모 언어 모델로 젬마를 공개했으며 지난해 5월에는 파라미터 수 700억인 Llama 3 70B에 견줄 만한 성능을 발휘할 수 있는 대규모 언어 모델인 젬마2를 출시한 바 있다.

구글은 새롭게 젬마2 강화 버전인 젬마3를 발표했다. 구글 대규모 언어 모델인 제미나이 2.0과 동일한 연구 및 기술을 사용해 구축된 젬마3는 지금까지 가장 선진적이고 휴대 가능하며 책임감 있게 개발된 오픈소스 모델이라고 한다.

젬마3에는 파라미터 수에 따라 10억, 40억, 120억, 270억 4가지 모델이 있으며 사용자는 특정 하드웨어와 성능 요구에 맞춰 최적의 모델을 선택할 수 있다. 또 구글은 젬마3는 스마트폰이나 노트북, 워크스테이션 등 모든 기기에서 빠르게 작동하도록 설계됐으며 개발자는 원하는 곳에서 AI 애플리케이션을 만들 수 있다고 밝혔다.

젬마3는 단일 GPU 또는 TPU에서 실행 가능한 게 특징 중 하나로 대규모 언어 모델에 대한 상대적 능력을 측정하는 데 사용하는 챗봇 아레나(Chatbot Arena)에서 단일 엔비디아 H100을 사용하는 젬마3 27B가 여러 개의 H100을 사용하는 딥시크 v3나 Llama 3 405B보다 뛰어난 성능을 발휘할 수 있다고 보고됐다.

또 젬마3는 140개 이상 언어를 사전 학습했으며 다양한 사용자 언어에 맞춘 애플리케이션을 구축할 수 있다. 더불어 12만 8,000 토큰 컨텍스트창을 갖고 있어 복잡한 작업 처리도 가능하다.

구글은 젬마3 개발 과정에서 광범위한 데이터 거버넌스와 자사 안전 정책과의 일관성을 위해 미세 조정을 실시했다며 더 강력한 모델을 개발함에 있어 안전성에 대한 위험에 비례한 접근 방식을 산업계가 공동으로 개발하는 것이 중요한 만큼 젬마3 같은 오픈소스 모델에서의 안전 대책을 시간을 들여 학습하고 지속적으로 개선해 나갈 것이라고 말했다.

한편 젬마3는 캐글(Kaggle)이나 허깅페이스에서 이용할 수 있으며 그 밖에도 대규모 언어 모델을 로컬에서 실행할 수 있는 라이브러리 올라마(Ollama)에서도 젬마3를 실행할 수 있다. 관련 내용은 이곳에서 확인할 수 있다.

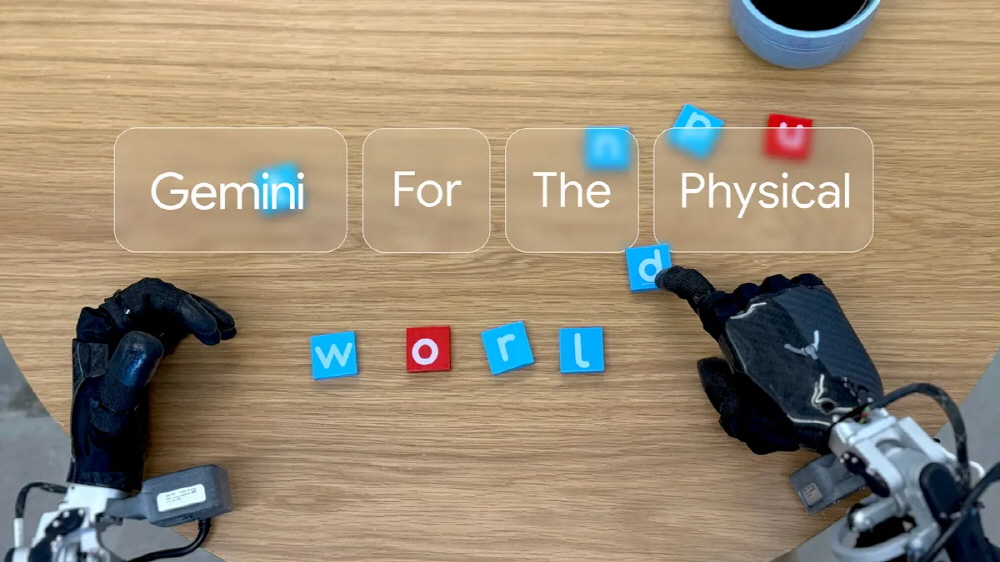

한편 구글은 제미나이 2.0을 기반으로 동작을 출력하는 기능을 추가해 로봇을 조작할 수 있게 한 AI 모델인 제미나이 로보틱스(Gemini Robotics)를 개발했다고 발표했다. 동시에 고급 공간 이해 기능을 가진 제미나이 로보틱스-ER(Gemini Robotics-ER) 모델도 발표됐다.

지금까지의 제미나이 패밀리 모델은 텍스트, 이미지, 음성, 동영상이라는 멀티모달 입력에 대응했지만 출력은 디지털 영역에 국한됐다. 이번에 개발된 제미나이 로보틱스는 새로운 출력 방법으로 물리적 동작이 추가되어 로봇을 직접 조작하는 게 가능하다.

구글은 제미나이 로보틱스를 시각-언어-동작 모델(VLA 모델)로 분류하고 광범위한 현실 세계 작업을 수행할 수 있게 된다고 밝혔다.

실제로 오퍼레이터가 바나나를 투명한 용기에 넣으라고 구두로 지시하면 로봇이 지시대로 동작한다. 중간에 용기 위치를 변경하는 방해에도 즉시 대응하고 있다. 원래 제미나이 2.0 모델이 갖춘 세계 지식 덕분에 농구공을 주워 덩크슛을 결정하라는 것 같이 완전히 훈련에 등장하지 않은 지시에도 따를 수 있다고 한다.

제미나이 로보틱스는 새로운 객체, 다양한 지시, 새로운 환경에 대한 대응이 특기라고 하며 구글은 다른 최첨단 시각-언어-동작 모델과 비교해 종합적인 일반화 벤치마크에서 평균 2배 이상 성능을 발휘한다고 밝혔다.

또 바나나 작업에서 용기 위치를 변경해도 문제없이 작업을 수행할 수 있었던 것처럼 주변을 지속적으로 모니터링해 환경이나 지시의 변화를 감지하고 변화에 따라 동작을 조정하도록 되어 있다고 한다. 물체가 손에서 미끄러지거나, 누군가가 물건을 움직이는 등 예기치 않은 일이 당연한 현실 세계에서는 변화에 대응하는 능력이 중요하다.

구글은 제미나이 로보틱스와 동시에 고급 시각-언어 모델인 제미나이 로보틱스-ER을 출시했다. 제미나이 로보틱스-ER은 제미나이 2.0이 갖춘 포인팅이나 3D 감지 등 기능이 대폭 개선됐으며 머그컵을 보고 어떻게 적절하게 잡을 수 있는지를 이해할 수 있다고 한다.

구글은 로봇 개발에 있어 안전성에도 주의하고 있으며 신뢰할 수 있는 테스터(Apptronik, Agile Robots, Agility Robots, Boston Dynamics, Enchanted Tools)와 협력해 앞으로도 AI 개발을 계속해 나갈 것이라고 밝혔다. 관련 내용은 이곳에서 확인할 수 있다.