AI 스케일링 법칙은 지난 2020년 1월 오픈AI가 제시한 법칙으로 AI 모델 성능은 학습에 사용되는 데이터 규모, 학습에 사용되는 계산량, 모델 매개변수 수가 증가할수록 강화된다는 것이다. 이 법칙에 대해 AI 동향에 밝은 개리 마커스는 AI 업계에서 스케일링 법칙이 더 이상 적용되지 않는다고 지적했다.

그에 따르면 스케일링 법칙이라는 용어 의미는 계속 변화하고 있으며 지금 논의되는 스케일링 법칙은 크게 3가지로 나뉜다. 첫 번째는 오픈AI가 제시한 것과 비슷한 학습 시간이 길어질수록 AI 성능이 강화된다는 것이고 2번째는 추론 시간이 길어질수록 AI 성능이 강화된다는 것, 3번째는 학습된 AI 모델에 대한 추가 학습 시간이 길어질수록 AI 성능이 강화된다는 것이다.

3가지 스케일링 법칙 중 학습 시간이 길어질수록 AI 성능이 강화된다는 법칙은 AI 기업에 의해 부정되고 있다. 예를 들어 오픈AI 샘 알트만 CEO는 2023년 4월 스케일링 법칙에 의존한 거대한 AI 모델 시대는 끝났다고 생각한다고 발언했다.

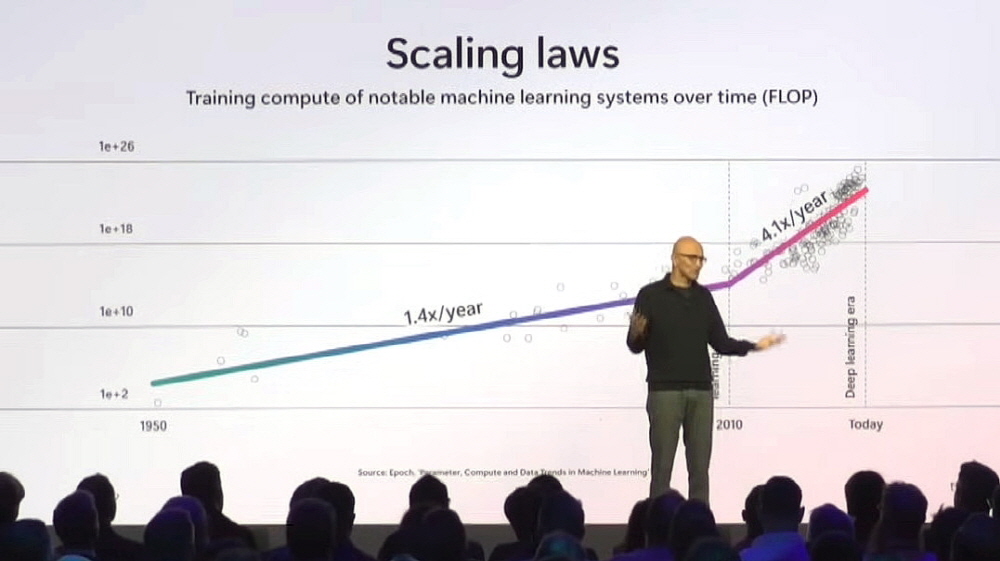

추론 시간이 길어질수록 AI 성능이 강화된다는 법칙은 마이크로소프트 사티아 나델라 CEO가 지난 10월 강연에서 크게 다룬 것으로 유명하다.

추론 시간을 길게 해 성능을 향상시키는 AI로 유명한 건 오픈AI의 오픈AI o1이다. 오픈AI o1은 GPT-4o와 비교해 추론에 더 많은 시간이 걸리는 대신 성능이 높아 57개 항목 중 54개에서 GPT-4o를 능가하는 점수를 기록했다고 강조했다. 하지만 반대로 보면 57개 항목 중 3개 항목에서는 GPT-4o와 동등하거나 그 이하 성능만 보였다는 걸 의미한다.

GPT-4는 GPT-3와 비교해 비약적인 성능 향상을 보였지만 오픈AI o1에서는 그만큼 큰 성능 향상이 관찰되지 않았다. 이런 사실을 바탕으로 마커스는 추론 시간이 길어질수록 AI 성능이 강화된다는 법칙도 붕괴하고 있다고 지적한다.

또 그는 3번째 학습된 AI 모델에 대한 추가 학습 시간이 길어질수록 AI 성능이 강화된다는 법칙에 대해 이는 ‘일부 매개변수를 미세 조정하면 얼마나 향상될지는 모르겠지만 성능은 향상될 것이라고 말하는 것과 같아서 법칙이라고 부를 수 없다고 말했다.

한편 AI 연구개발을 진행하는 기업은 스케일링 법칙 한계가 제기되는 가운데에도 설비 투자를 계속하고 있다. 예를 들어 메타는 엔비디아 H100을 10만 대 이상 사용해 차세대 AI 모델 학습을 진행하고 있다고 밝혔다. 또 일론 머스크가 설립한 AI 기업 xAI도 10만 대 이상 H100을 탑재한 AI 학습 클러스터를 운영하며 규모 확대를 진행하고 있다. 한편 수십만 대 규모 AI 칩이 가동되는 데이터 센터에서는 칩 냉각과 고장 관리 등으로 인해 운영이 복잡해질 수 있다고 지적되고 있다. 관련 내용은 이곳에서 확인할 수 있다.