GM 산하 자율주행기업인 크루즈는 자율주행차가 아이를 검지하고 적절히 주의를 기울이는 것에 문제가 있다고 인식하면서 공도에서 테스트를 계속하고 있다는 보도가 나왔다.

크루즈는 샌프란시스코나 마이애미 등 미국 여러 도시에서 자사 자율주행차를 공도 주행 테스트해왔다. 때론 자율주행차가 사고를 일으키거나 교통을 방해하는 사례도 보고되고 있었지만 2023년 10월에는 GM 등이 자율주행차는 인간이 운전하는 차보다 안전하다는 걸 나타내는 데이터를 발표하는 등 자율주행차 안전성을 어필해왔다.

그런데 이 리포트 공표 직후 캘리포니아 교통 당국 DMV가 크루즈에 준자율주행차량 배치나 무인 운전 시험 허가를 즉시 중지한다고 발표했다. 이는 10월초 크루즈 자율주행차가 일으킨 사고에서 크루즈가 사고에 대한 정보를 적절하게 DMV에 공개하지 않았기 때문이다. 이후 크루즈는 캘리포니아주 외에도 자율주행차 무인 주행 테스트를 일시 중단하기로 결정했다.

크루즈 CEO는 이 건에 관련해 직원에게 안전은 크루즈 모든 일에서 핵심이라는 메시지를 발신했다고 한다. 실제로 지금까지 크루즈를 비롯한 자율주행차 개발 기업은 자율주행차에 탑재된 소프트웨어는 인간처럼 피곤하거나 술에 취하거나 주의가 산만하게 되지 않는다는 점을 강조해왔다.

하지만 보도에서 입수한 채팅 로그 등을 포함한 내부 자료에선 크루즈가 자율주행차 공도 주행 테스트를 일시 정지하기 전부터 아이와 도로상 구멍을 검지하는 능력에 문제가 있는 걸 인식하고 있다는 걸 나타낸다. 아이가 갑자기 달리거나 도로로 뛰어나갈 수 있는 만큼 차를 운전할 때 아이를 보면 더 조심해야 한다며 하지만 어떤 안전성 평가에선 크루즈 자율주행차는 아이에 대해 특별한 주의를 기울이지 않을지 모른다고 적혀 있었다고 한다.

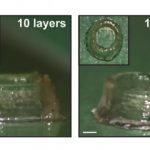

크루즈 내부 자료에는 자율주행차 개발에 있어 아이가 갑자기 동반하는 어른으로부터 멀어지거나 아이가 넘어지고 아이가 자전거를 타거나 아이가 특수 옷을 입고 있는 등 아이 관련 시나리오에 대한 데이터가 부족하다고 기록됐다. 실제로 크루즈가 아이 옆을 달리는 모의 테스트를 실시한 결과 시뮬레이션 결과에 근거하면 완전 자율주행차가 아이를 치었을 가능성을 배제할 수 없다고 보고됐다. 또 다른 테스트 주행에선 유아 크기 더미 인형을 검지하는데 성공했지만 45km/h로 주행하는 자율주행차 사이드미러가 인형에 부딪쳤다고 한다.

이런 문제에 대해 크루즈는 자사 자율주행 소프트웨어가 아이를 감지하지 못한 게 아니라 아이를 주의가 필요한 특별한 카테고리 보행자로 분류하지 못했다고 설명한다. 크루즈 측은 아이와의 접촉에 대한 위험 허용도를 가장 낮게 설정하고 아이 안전을 최우선으로 다룬다며 주행하는 것이라도 충돌 위험이 제로가 되는 차량은 없다고 밝혔다.

더구나 크루즈는 1년 이상 이전 시점에서 근로자가 내부에 있는 것 같은 공사로 비워진 큰 구멍을 검지할 수 없다는 걸 파악할 수 있었다고 한다. 크루즈는 테스트에 한정된 자율주행차만 주행하는 상태에서도 1년 에 1대 자율주행차가 빈 구멍에 떨어지고 4년에 1대는 안에 작업원이 들어간 구멍에 떨어질 가능성이 있다고 추정하고 있었다고 한다. 공도를 주행하는 자율주행차가 늘어나면 이에 따라 위험이 증가하게 된다.

실제로 크루즈 차량 영상에는 복수 작업원이 있는 공사 현장 구멍을 향해 자율주행차가 달려 작업원 불과 몇 cm 앞에서 정차하는 모습도 비치고 있었다고 한다. 건설 현장은 오렌지색 콘으로 둘러싸어 있어 작업원 1명은 감속을 나타내는 사인을 흔들어 차량을 멈추려고 했지만 자율주행차는 이를 검지할 수 없었다고 한다.

크루즈는 외부 지각과 내비게이션에서 AI에 강하게 의존하고 있으며 2021년에는 크루즈 AI 책임자가 AI 없이 크루즈를 만들 수 없다고 말하는 등 뛰어난 AI 능력을 정기적으로 혼보 중이다. 하지만 일련의 문제는 기계학습 우선 접근법에 도전 과제를 제시한다.

전문가는 크루즈가 다양한 안전 위험을 나열하고 평가하는 게 긍정적인 징후라고 말한다. 하지만 크루즈가 우려하는 안전상 문제는 지금 나타는 게 아니고 자율형 로봇 공학 분야에선 수십 년 전부터 알려져 있었다고 한다. 머신러닝 데이터 중심 문화를 보유한 기술 기업은 위험에 직면하기 전이 아니라 실제로 위험이 발생하지 않으면 문제에 대해 생각하지 않는 점이 문제라는 지적이다. 따라서 이 전문가는 크루즈가 첫날부터 위험을 나열해야 했다며 기계학습은 근본적으로 안전에 적합하지 않다고 지적했다. 관련 내용은 이곳에서 확인할 수 있다.