대화형 AI인 챗GPT 등에 사용되는 언어 모델은 복잡한 태스크를 싱행하는 게 실증되고 있지만 이를 로봇에 응용하면 상황에 맞는 동작을 실시하기 위해 언어 모델은 더 자세한 정보를 수집해야 한다. 구글과 베를린공대 AI 연구 그룹은 카메라로 캡처한 영상과 텍스트 지시를 이해할 수 있는 새로운 언어 모델인 PaLM-E를 개발했다고 밝혔다. 이 모델을 이용하면 서랍에서 과자를 가져오라는 복잡한 명령을 로봇이 처리할 수 있다.

PaLM-E는 사전 학습된 언어 모델에 이미지, 상황, 명령문 등 정보를 통합해 처리하는 언어 모델이다. 5,400억 파라미터로 인간 언어를 이해하고 복잡한 태스크를 실현하는 사전 학습된 언어 모델인 PaLM(Pathways Language Model)에 로봇이라는 몸을 줬다((Embodied))는 의미로 PaLM-E로 명명됐다. 구글 이미지 인식 모델인 ViT가 가진 220억 파라미터와 합치해 PaLM-E는 합계 5,620억 파라미터를 갖는다. 이는 챗GPT에 사용되는 언어 모델인 GPT-3 1,750억보다 훨씬 많다.

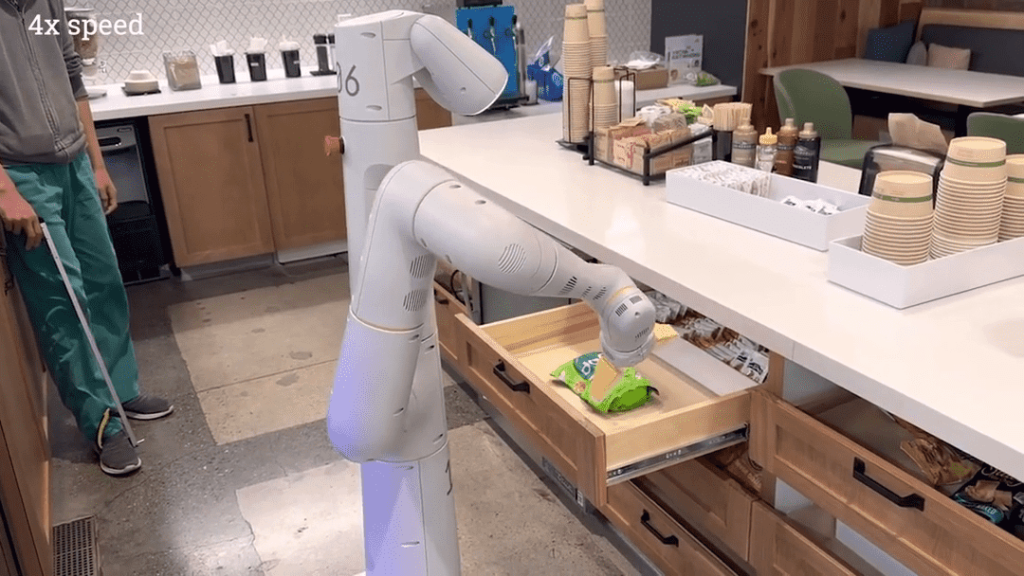

구글로보틱스 로봇과 연계한 PaLM-E에 서랍에서 라이스칩을 가져오라는 명령을 하면 PaLM-E는 로봇 행동 계획을 생성하고 로봇을 움직일 수 있다. 또 사전에 가르치지 않은 걸 가져오라고 명령해도 언어 모델이나 시각으로부터 추론한 정보를 바탕으로 행동 계획을 생성한다.

PaLM-E는 로봇 행동 계획을 생성할 뿐 아니라 이미지를 분석하고 처리하는 능력도 뛰어나다. 예를 들어 PaLM-E에 이미지 데이터를 입력하고 사진 속 팀이 어디에서 마지막으로 우승했는지 등을 물으면 PaLM-E는 순차적으로 팀명이나 마지막 우승 등을 맞춘다. 자전거 외 진입 금지를 나타내는 도로 표지 같은 것도 파악해 이 거리를 자전거로 통과할 수 있냐고 물으면 그렇다고 올바르게 답한다.

구글 연구팀은 PaLM-E에서 볼 수 있는 태스크를 통해 학습한 지식과 스킬을 다른 태스크에 응용할 수 있다는 점에 주목하고 있으며 태스크 하나 밖에 할 수 없는 로봇 모델과 비교해 현저하게 높은 퍼포먼스를 발휘한다는 평가를 내리고 있다. 연구자는 홈오토메이션이나 산업용 로봇 등 실세계 시나리오에 PaLM-E를 적용하는 걸 검토하고 있다. 관련 내용은 이곳에서 확인할 수 있다.