챗GPT는 사상 가장 급속한 성장으로 월간 1억 사용자를 불과 2개월 만에 달성하는 등 주목을 받고 있다. 이에 따라 구글이 챗GPT 경쟁 격인 대화형 AI인 바드(Bard)를 발표하거나 중국 기업이 잇달아 챗GPT 스타일 AI를 개발하고 있다는 보도가 나오고 있다. 한편 오픈AI는 챗GPTW 코드를 공개하지 않기 때문에 챗GPT를 효과적으로 복제하는 건 어렵다. AI 딥러닝 학습을 최적화하는 오픈소스 플랫폼인 콜로셜-AI(Colossal-AI)는 챗GPT 학습 과정을 불과 1.6GB GPU 메모리로 7.73배 빠른 트레이닝으로 재현했다고 발표하고 오픈소스로 공개하고 있다.

사티아 나델라 마이크로소프트 CEO는 AI가 모든 소프트웨어 카테고리를 근본적으로 바꿀 것이라고 말했다. 마이크로소프트는 2023년 2월 챗GPT 업그레이드 버전 AI를 통합한 새로운 검색엔진인 빙과 브라우저 엣지를 발표하고 있으며 나델라 CEO는 마이크로소프트가 AI로 구글 검색을 타파할 수 있다는 생각을 보인다.

구글과 중국 기업이 챗GPT에 맞서 대화형 AI를 추진하고 있지만 챗GPT는 오픈소스 프리 트레이닝 가중치와 저비용 오픈소스 학습 프로세스를 공개하지 않았으며 1,000개 매개 변수 모델을 기반으로 챗GPT 전체 프로세스를 효율적으로 복제하는 건 어렵다고 생각된다. 대규모 신경망 분석을 통해 딥러닝 기능을 가속화하고 비용을 절감하는 걸 목표로 하는 HPC-AI 테크(HPC-AI Tech)에 따르면 챗GPT의 놀라운 특징은 훈련 프로세스에 RLHF를 도입, 인간 취향을 더 적절하게 파악한다는 점에 있어 트레이닝 프로세스 마지막에 한층 더 트레이닝을 실시하는 것으로 언어 모델이 인간 취향에 가까운 콘텐츠를 생성하게 되어 있다.

챗GPT는 강화학습을 도입하고 있기 때문에 트레이닝 중 복수 추론 모델을 실행하고 있으며 챗GPT 기반이 된 인스트릭트GPT(InstructGPT) 논문에선 액터 모델과 감독 학습 미조정 모델은 모두 1,750억 파라미터 GPT-3 계열 모델을 사용하고 있거나 또 다른 모델에선 60억 파라미터 GPT-3 계열 모델을 사용하거나 모델 파라미터가 많기 때문에 챗GPT 트레이닝 프로세스를 개시하려면 수천 GB GPU 메모리가 필요하다.

HPC-AI테크가 개발한 콜로셜-AI는 챗GPT 1단계 사전 훈련, 2단계 보상 모델 훈련, 3단계 강화학습 훈련 등 복잡한 단계를 포함한 챗GPT 교육 프로세스를 오픈소스 방식으로 복제했다고 보고했다. 파이썬 오픈소스 머신러닝 라이브러리인 파이토치(PyTorch)와 비교해 콜로셜-AI는 단일 서버 교육에선 최대 7.73배, 단일 GPU 추론에선 1.42배 빠르며 대규모 병렬 처리로 확장을 계속, 챗GPT 복제 비용을 크게 줄인다고 한다.

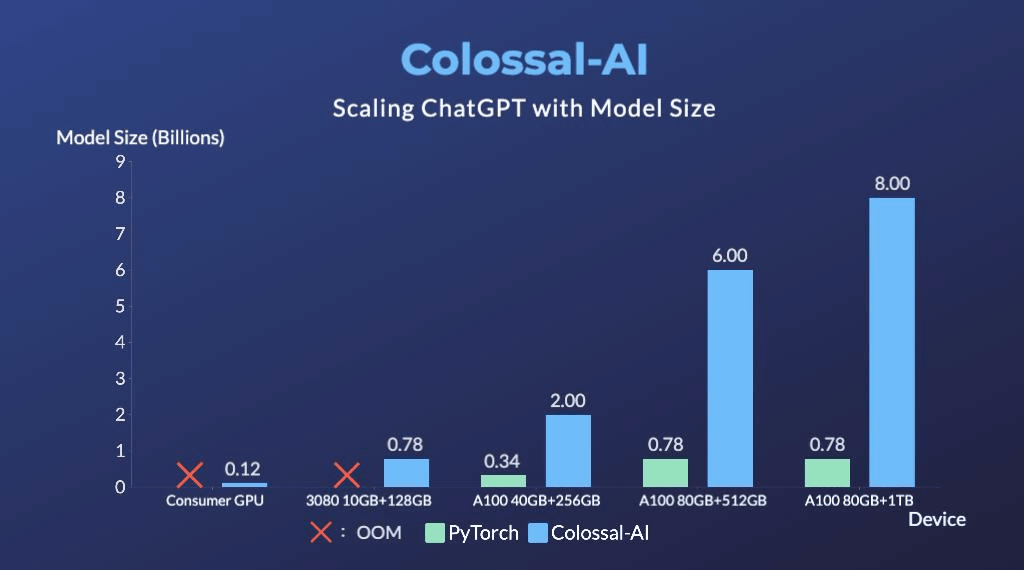

또 콜로셜-AI는 단일 GPU로 시험할 수 있는 챗GPT 교육 프로세스를 제공해 학습 비용을 최소화한다. HPC-AI테크에 따르면 파이토치는 80GB GPU 메모리에서 최대 7억 8,000만 개 매개변수 모델만 시작할 수 있는 반면 콜로셜-AI는 단일 소비자 수준 GPU로 채울 수 있는 최소 1.62GB GPU 메모리로 1억 2,000만 파라미터를 채울 수 있다는 것. 또 사전 훈련된 대규모 모델을 기반으로 미세 조정 작업 비용을 절감하고 미세조정 모델 용량을 단일 GPU로 파이토치보다 최대 3.7배 늘릴 수 있다고 한다.

HPC-AI테크는 곧바로 사용할 수 있는 콜로셜-AI 챗GPT 교육 코드를 공개했다. 챗GPT 구현 프로세스를 복제하기 위해 완전한 알고리즘과 소프트웨어 설계를 오픈소스화해 대규모 컴퓨팅 능력을 가진 소수 선도 기술 기업만 소유한 사전 훈련된 모델을 오픈소스 커뮤니티에서 성공시켜 콜로셜-AI를 기반으로 생태계를 구축하고 챗GPT 복제를 출발점으로 해 빅AI 모델 시대를 향해 노력해 나가겠다고 표명했다. 관련 내용은 이곳에서 확인할 수 있다.