매년 수많은 사망자가 발생하는 암은 심장 혈관과 림프계를 통해 체내를 이동하고 인체 다른 곳에서 새로운 종양을 형성하는 전이 현상을 일으킬 수 있다. 이 같은 전이성 암은 발견이 어렵지만 구글이 개발한 인공지능은 99% 정확도로 전이성 유방암을 감지할 수 있다고 한다.

유방암은 수많은 여성에게 인생에 한 번 발병할 수 있다. 전 세계적으로 매년 50만 명에 이르는 사람들이 유방암으로 사망한다. 지난 2009년 보스턴 보건 당국이 유방암 환자를 대상으로 진행한 연구에 따르면 유방암 환자 4명 중 1명은 검사 부족과 진단 미비 등 관리 단계에서의 문제나 실수로 인한 것이라고 한다. 유방암 환자 사망 원인 90%는 암이 전이된 결과로 알려져 있지만 전이성 암 감지는 의사로 놓칠 수 있는 어려운 문제이기도 하다.

구글은 이런 전이성 유방암에 대한 연구를 진행했다. 구글 인공지능 부문과 샌디에이고해군의료센터(Naval Medical Center San Diego)가 공동 진행해 유방암 림프절 전이를 자동 감지하는 새로운 암 탐지 알고리즘을 개발한 것이다. LYNA라고 명명한 이 인공지능 시스템은 의학저널(The American Journal of Surgical Pathology)에 논문을 통해 게재, 발표됐다.

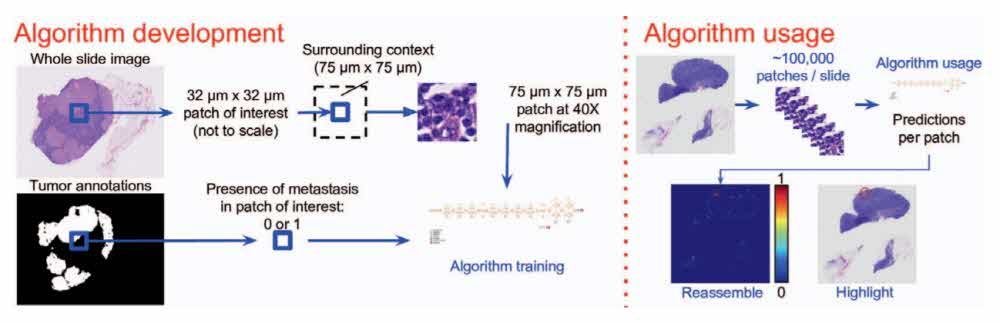

앞서 밝혔듯 숙련의도 전이성 유방암을 감지하는 데에는 한계가 있다. 지난 2017년 발표된 한 연구에선 숙련의도 제한된 시간 제약 하에서 미세한 암 전이 중 62%를 놓칠 수 있다는 결과를 내놓기도 했다. 연구팀은 인공지능 알고리즘이 암 탐지에 이용하는 모든 조직을 평가할 수 있다고 밝히고 있다. LYNA는 병리학을 훈련할 때와 같은 프레임워크를 적용해 학습시켰다.

LYNA는 오픈소스 이미지 인식 딥러닝 모델인 인셉션-v3(Inception-v3)을 바탕으로 제작한 것으로 입력된 이미지에서 픽셀 수준까지 암을 찾아낸다. 연구팀은 LYNA를 학습시키는 과정에서 교육에 이용하는 조직 라벨을 양성과 종양 비율 4:1로 해 학습 효율을 높이는 데 성공했다고 한다.

그 결과 LYNA는 전이성 유방암에 대한 영상 진단 정확도 측정에서 무려 99.3%에 달하는 정확도를 달성할 수 있게 됐다고 한다. 물론 오인 사례도 있었지만 기포나 출혈, 염색 과다 등 결함에 영향을 받지 않고 인간보다 뛰어난 전이성 유방암 탐지 능력을 보여줬다고 한다.

연구팀은 LYNA가 병리학보다 높은 전이성 유방암 탐지 능력을 갖췄으며 병리학 진단 지원을 통해 진단 과정의 효율성 향상은 물론 오류 감소에도 도움을 줄 수 있다고 강조하고 있다.

의료 분야에서 인공지능을 활용하려는 시도는 계속되고 있다. 지난해에도 스탠포드대학 연구팀이 딥러닝을 활용해 피부암 여부를 이미지로 확인할 수 있는 알고리즘을 발표하기도 했다. 지난해 1월 학술지 네이처에 게재된 연구 결과에 따르면 피부암 진단은 주로 육안이나 현미경을 이용한 사람의 눈을 통해 이뤄진다. 피부암이라고 확신하거나 육안으로 판단이 서지 않을 때에는 다음 단계로 넘어간다.

연구팀은 이를 위한 눈에 해당하는 부분을 컴퓨터에 맡긴 것이다. 피부과에서 현미경으로 보는 것처럼 피부암이 의심되는 부위 사진을 찍어 암 여부를 확인하는 것이다. 연구팀은 CNN(convolutional neural networks) 알고리즘을 통해 기본은 1,000개체 유형 범주에 이미지 128만 장을 학습시켰다. 또 의학계나 인터넷 등에서 수집한 2,032종 질병으로 이뤄진 12만 9,450개 데이터셋을 이용해 CNN을 학습시켰다.

그 결과 교육 받은 CNN에 370개 이상 피부암 의심 사례를 보여주니 해당 사진에 대해 확인을 한 피부과 전문의 21명과 거의 같은 결과를 보였다고 한다.

앞선 유방암이나 피부암 모두 이미지 인식과 학습을 통해 이뤄진 것이다. 스탠포드대학 연구팀의 경우 스마트폰에서도 이 같은 인지가 가능하도록 할 계획을 세우고 있다. 이런 연구가 계속된다면 스마트폰으로 촬영만 하면 그 자리에서 곧바로 피부암 같은 일부 증상에 대한 식별이 가능해지는 시대가 열릴 수도 있다. 관련 내용은 이곳에서 확인할 수 있다.