실리콘밸리 칩 제조 스타트업인 셀레브라스시스템즈(Cerebras Systems)가 8월 24일(현지시간) 실리콘웨이퍼 1장을 그대로 사용한 거대한 칩을 갖춘 소형 냉장고 크기 딥러닝 시스템인 셀레브라스 CS-2(Cerebras CS-2)를 발표했다.

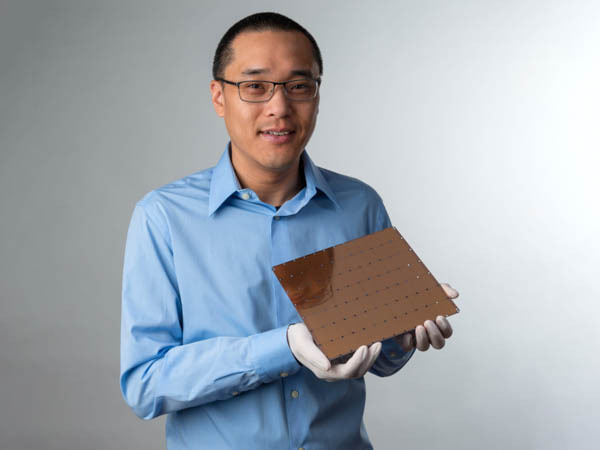

2016년 설립된 반도체 제조사인 셀레브라스시스템즈는 실리콘밸리에 본사를 둔 인공지능 시스템 개발 기업. 2019년에는 20×22cm에 이르는 칩인 WSE(Wafer Scale Engine)를 발표했다. 또 WSE를 탑재한 딥러닝 시스템인 셀레브라스 CS-1은 시뮬레이션에서 물리법칙을 넘을 만한 검증 결과를 냈다고 한다.

셀레브라스시스템즈가 이번에 새로 발표한 2.6조 개에 이르는 트랜지스터를 탑재한 WSE2를 채택한 게 바로 셀레브라스 CS-2다. 발표에 따르면 이 제품은 계산 장치와 매개변수를 스토리지에서 분리해 워크로드 분산 모델을 단순화하고 CS-2를 1개에서 192개까지 확장 가능하게 하는 셀레브라스 웨이트 스트리밍(Cerebras Weight Streaming), 최대 2.4PB 고성능 메모리와 120조 개 파라미터를 가진 모델을 지원 가능한 메모리 확장 기술인 셀레브라스 메모리X(Cerebras MemoryX), 최대 192대 CS-2에 걸쳐 AI 1억 6,300만 개에 최적화된 코어를 연결할 수 있는 셀레브라스 스웜X(Cerebras SwarmX), 가중치를 동적으로 선택할 수 있는 셀렉터블 스파시티(Selectable Sparsity)라는 4가지 새로운 기술이 포함되어 있다고 한다.

셀레브라스 CS-2가 주목받는 건 칩을 추가해도 전력 효율이 떨어지고 있다는 점이다. 현재 AI에 이용되는 신경망은 칩 하나로 처리할 수 없기 때문에 일반적으로 칩 여러 개로 분산 처리된다. 하지만 칩이 많을수록 전력 효율이 떨어지기 때문에 딥러닝 시스템 전체 처리 능력을 늘리려면 엄청난 전력이 필요했다.

반면 셀레브라스 CS-2는 칩을 늘려도 전력 효율은 변하지 않기 때문에 처리 능력을 2배로 했을 때 소비전력 증가도 2배다. 이로 인해 전력 효율을 유지하면서 셀레브라스 CS02를 192개까지 확장해 1억 6,300만 개 코어를 하나에 연결하고 인간 뇌보다 120조 개 파라미터를 갖는 신경망 훈련을 할 수 있다고 한다.

셀레브라스시스템즈 측은 GPT-3 같은 대규모 네트워크는 지금까지 상상도 할 수 없던 걸 허용하고 자연언어 처리 NLP 상황이 변화하고 있다며 업계에선 1조 개 파라미터를 갖는 모델이 등장하고 있지만 자사는 이를 2자리로 확대한 120조 개 파라미터를 갖는 신경망을 실현했다고 강조했다. 관련 내용은 이곳에서 확인할 수 있다.