인공지능 기술이 향상되면서 문제가 발생하기도 한다. 지난해에는 인공지능 기술을 이용해 유명 여배우의 얼굴을 학습시켜 기존 성인물과 결합한 가짜 성인물이 화제를 모으기도 했다. 영화 원더우먼 주연배우인 갤 가돗이 나온 것 같은 가짜 영상이 그것. 사실은 텐서플로우 같은 머신러닝 도구를 이용해 만든 것이다. 관련 기술이 순식간에 퍼지면서 누구나 쉽게 가짜 성인물을 만들 수 있게 해주는 앱인 페이크앱(FakeApp)까지 등장했다. 프로그래밍이나 기술적 배경이 없어도 누구나 이 같은 가짜 영상을 만들 수 있도록 한 것이다.

물론 이 같은 AI와 결합한 영상의 경우에는 좋은 쪽으로 생각해보자면 누구나 전문 지식이 없더라도 지금은 거대 SFX 기업이나 독점하는 CG 작업이나 디지털 편집을 누구나 할 수 있게 될 가능성을 보여주고 있다. 한 편으론 윤리적 문제를 불러일으키지만 다른 한편으론 알고리즘이 발전하면 영상 제작 분야에서 혁신이 일어날 가능성을 동시에 예고하는 것이다.

그 뿐 아니다. 영상 외에도 아예 전화로 사람과 대화를 나눌 수 있는 AI 개발도 진행 중이다. 지난 5월 구글이 개최한 구글I/O 2018 기간 중 발표한 구글 듀플렉스(Google Duplex)가 그것이다. 구글은 딥러닝을 통해 인공 음성을 생성하는 신경망인 웨이브넷(WaveNet)을 개발해 구글 어시스턴트에 탑재한 바 있다. 상당히 정밀하게 인간에 가까운 자연스러운 발성을 생성할 수 있게 됐지만 여전히 ‘컴퓨터틱한’ 말투나 어조는 남아 있었다.

구글 듀플렉스는 전화를 통해 자연스러운 대화를 나눌 수 있는 AI다. 미용실이나 식당에 예약을 거는 등 특정 이벤트를 예약하는 작업을 수행할 수 있다. 물론 학습 데이터와 사용 목적 자체를 제한해 마치 인간처럼 대화가 가능하도록 한 것이다. 잡담 같은 일반적인 대화는 할 수 없고 특정 용도에 특화한 대화형 AI인 것.

구글 듀플렉스는 전화를 건 의도를 먼저 명확하게 전달해 상대방(물론 사람)이 같은 주제를 갖고 대화를 할 수 있도록 유도한다. 사실 인간끼리 이뤄지는 자연스러운 대화는 생각보다 복잡하다. 얘기를 반복하거나 상대방이 알 것 같은 얘기는 건너뛰기도 한다. 통화 중 잡음이 발생하는 등 AI 입장에선 오류율을 높일 일이 많은 것. 구글 듀플렉스는 상대방 음성을 인식할 뿐 아니라 지금까지 상대방과 나눈 대화 기록이나 대화 목적, 시간 같은 정보를 바탕으로 최적의 응답을 만들어낸다. 문맥을 분석해 의미를 추정하고 대화를 계속 한다.

구글 듀플렉스는 기본적으론 인간의 개입 없이 자율적으로 대화를 하고 작업을 끝낼 수 있다는 점에서 의미가 있다. 예약 작업 같은 일을 처리해줄 뿐 아니라 청각 장애나 혹은 현지어를 모르는 사람에게도 도움이 될 수 있다.

어쨌든 이 같은 인공지능 기술 발전은 이제 영상이나 음성 같은 가짜 콘텐츠를 만들어낼 수도 있다. 어떤 영상이나 음성이 진짜인지 점점 더 판단하기 어려워질 수 있다는 것이다. 실제로 버락 오마바 전 미국 대통령 영상에 다른 영상 표정을 옮기는 기술이 나오기도 했다. 인터넷 미디어 버즈피드가 지난 4월 제작한 것.

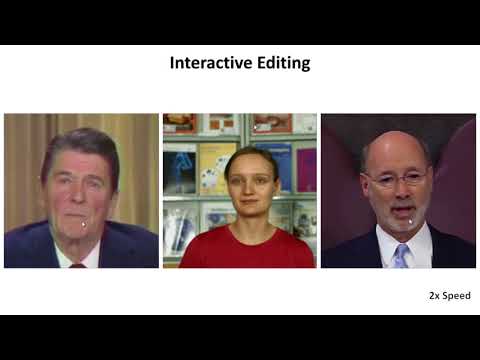

이후 더 정교해진 영상 편집 기술도 나왔다. 스탠포드대학 연구팀이 개발한 딥비디오(Deep Video) 기술은 딥러닝 알고리즘을 이용해 기존 동영상에 나오는 인물을 편집할 수 있게 해주는 기술이다. 영상 속에 나오는 인물이 말하는 모습이나 동작을 다른 인물에 옮길 수 있도록 해주는 것.

이 기술은 표정 뿐 아니라 머리 위치나 움직임, 눈 움직임 심지어 눈 깜박임까지 그대로 이식할 수 있다. 물론 여기에는 소스 역할을 할 배우 움직임을 담은 영상이 필요하다. 표정 뿐 아니라 얼굴 방향이나 움직임까지 옮겨올 수 있다. 여기에 음성만(음성 역시 앞서 소개한 구글 듀플렉스처럼 점점 발전 중이다) 있다면 누가 말하는 내용인 것처럼 얼마든지 조작이 가능하다는 얘기다. 음성 파일만 있다면 입 움직임을 일치시킬 수 있다. 지금까지 영상 편집이라고 하면 인물이 움직이면 이에 맞춰 배경을 처리해야 했지만 딥비디오는 배경까지 알아서 최적화해준다. 세세한 표정 변화나 움직임까지 진짜인 듯 보여 어느 쪽이 가짜인지 판별하기 어려울 정도다.

앞서 밝혔듯 딥비디오 같은 기술에는 음성 합성 시스템만 조합하면 누군가를 비방하거나 가짜 뉴스를 만들 때 쓸 위험성은 얼마든지 있다. 이런 점 때문에 진짜인지 여부를 알려주는 워터마크를 붙이거나 AI 기술로 다시 가짜 여부를 판별해야 한다는 목소리가 나오기도 한다. 실제로 지난해에는 가짜 뉴스 근절을 위한 페이크뉴스챌린지(Fake News Challenge) 같은 프로젝트가 진행되기도 했다. 머신러닝과 자연어 처리, 인공지능 기술을 활용해 뉴스 기사 속에 숨은 조작이나 오보를 식별할 수 있는 가능성을 찾겠다는 시도다.

텍사스대 로버트 체스니 교수와 메릴랜드대학 다니엘 시트론 교수는 이 같은 새로운 딥페이크(Deep Fake) 기술이 가진 문제점에 대한 논문(Deep Fakes: A Looming Challenge for Privacy, Democracy, and National Security)을 발표했다.

딥페이크는 딥러닝(deep learning)과 거짓(fake)의 합성어. 딥러닝 기술을 활용해서 거짓 정보, 가짜 뉴스를 만든다는 뜻을 담고 있는 신조어다. 딥페이크 관련 논문에선 인공지능을 이용한 딥페이크 기술은 계속 발전할 것이라면서 이에 따라 가짜 뉴스, 거짓 정보가 확산되는 속도 역시 증가할 것으로 내다봤다. 지금도 이미 문제가 되고 있는 가짜 뉴스 확산이 더 가속화될 것이라는 전망이다.

여기에는 딥페이크 기술이 영상이나 음성처럼 믿기(속기) 쉽고 SNS 상에 퍼지기 쉬운 수단을 활용할 수 있게 해준다는 점에서 순식간에 가짜 뉴스를 전 세계로 확산시킬 수도 있다는 점을 들고 있다. 선거나 안보, 저널리즘 등 다방면에 막대한 피해를 줄 수도 있다는 것. 또 이 같은 거짓 정보에 “이런 일이 있었다”는 식의 주장보다 더 위험한 건 “이런 사실은 없었다”거나 “(특정) 발표는 거짓이다” 같은 부정적 형태를 취하는 것이라고 언급하고 있다. 실제 발표와는 상반된 내용을 동영상이나 음성으로 조작 생성해 특정 인물을 거짓말쟁이로 만드는 것도 가능하다.

일반인이 지금도 가짜 뉴스 여부를 판단하는 건 쉽지 않다. 더구나 영상이나 음성 같은 논앞에 보이고 들리는 증거(?)가 있다면 더더욱 그렇다. 보도는 신뢰성이 중요하고 이를 통해 효과적인 민주주의가 기능할 수 있다. 하지만 이 같은 정보에 대한 신뢰도를 흔드는 일이나 도구가 자칫 권위주의적 정권이 탄생할 틈을 만들어낼 수도 있다는 지적이다. 딥페이크 기술은 기본적으론 선동 목적이 짙을 수 있다. 앞서 밝혔듯 워터마크가 됐든 뭐든 가이드라인이 필요할 수도 있지만 독자 입장에선 신중하게 어떤 소스를 통한 것인지 확인하는 습관이 필요할 수 있다.