하이엔드 스마트폰이라고 해도 카메라 성능이 값비싼 디카에 견주긴 어렵다. 하지만 스마트폰에는 뛰어난 프로세서라는 무기가 있다. 찍은 사진을 그 자리에서 가공할 수 있다는 얘기다. 예를 들어 아이폰 같은 경우 세로 모드에서 사진을 찍은 뒤 가상으로 조명을 바꿀 수 있다.

물론 세로 모드를 이용할 수 있는 건 아직은 아이폰 중에서도 플래그십 기종에 한정된 것이다. 이런 이유로 구글과 캘리포니아대학 샌데이에고 연구팀이 비슷한 기능을 더 평범한 스마트폰에서 실현할 수 있는 기술을 개발했다. 사용법에 따라 세로 모드보다 더 편리할 지도 모른다.

아이폰 세로 모드는 본체에 있는 여러 카메라로 같은 장면 사진을 몇 장 찍고 이를 소프트웨어로 분석해 이미지 뎁스(깊이) 맵을 생성하는 것이다. 깊이맵은 간단하게 말하면 사진 속 피사체가 개별 카메라에서 얼마나 떨어져 있는지 흑백으로 표현한 것이다. 이를 통해 소프트웨어는 어떤 게 얼마나 앞에 있고 뭐가 얼마나 안쪽에 있는지 판정할 수 있다. 덕분에 사람의 눈동자에 초점을 맞추고 배경을 흐리게 하는 식으로 조절할 수 있다.

깊이맵은 또 아이폰 인물 기능에서 인간의 얼굴 부분을 구별하기 위해서도 쓰인다. 세로 모드에서 이미지 찍은 사진도 나중에 스튜디오 조명이나 무대 조명 등 가상으로 전환할 수 있다. 이런 조명은 완전히 가짜지만 자연스럽게 보이는 건 얼굴에 대한 정보가 깊이맵을 통해 소프트웨어에 전달되기 때문이다.

연구팀이 개발한 건 다양한 조면 조건에서 인간의 얼굴 사진이 어떻게 비칠지 신경망을 통해 학습을 시켰다. 스테이지 위 인물을 304개 LED 조명으로 공처럼 둘러싸고 점등 라이트를 하나씩 늦추면서 7개 방향에 설치한 카메라로 촬영했다. 인물마다 3∼5개 패턴 표정을 만들고 찍힌 사진이 많으면 인당 1만장 이상에 달했다고 한다.

또 모델인 사람도 여러 패턴을 준비해 백인 남성 7명, 아시아계 남성 7명, 백인 여성 2명, 아시아계 여성 1명, 아프리카계 여성 1명 등 18명을 대상으로 학습 데이터로 삼았다. 피부색이 짙은 사람 사진에도 적용할 수 있도록 하기 위해 연구팀은 학습 데이터를 수작업으로 조정했다고 한다.

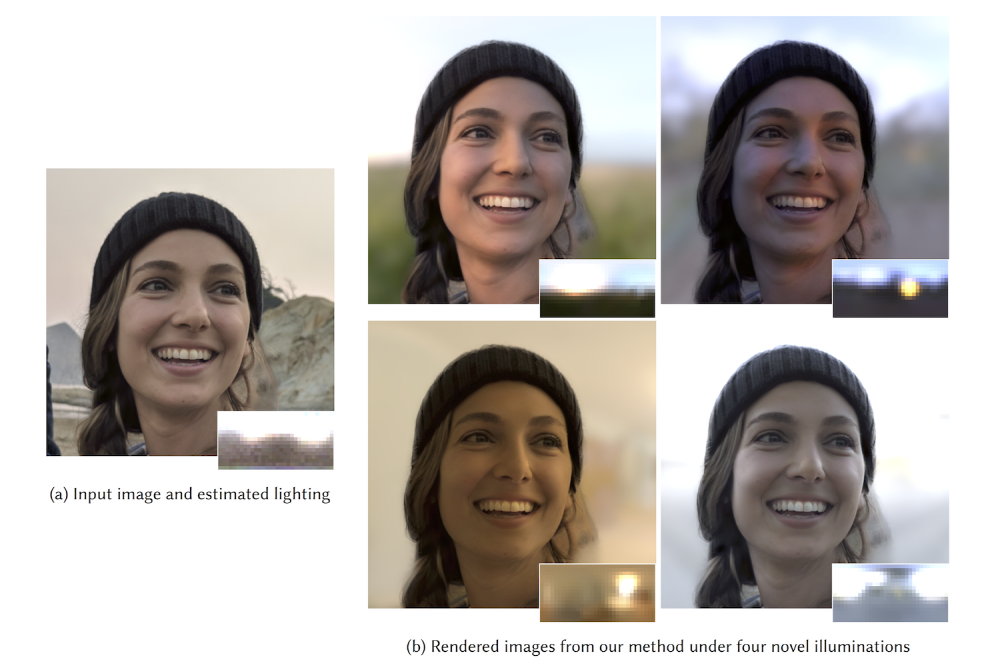

이렇게 만든 인물 18명 데이터와 3∼5가지 표정, 307개 광원, 카메라 7개 각도를 더한 데이터를 학습해 깊이맵 없이도 사진에서 얼굴에 모든 조명 환경을 재현할 수 있도록 한 것이다. 실제로 영상을 보면 사진 변화를 보면 상당히 자연스럽다.

참고로 iOS 세로 모드에선 라이팅 모드는 6가지 패턴 밖에 없다. 하지만 연구팀이 이룬 방식은 광원을 3D 공간 어디에 놔도 문제 없이 피사체의 얼굴 색상과 그림자 수 등 상황이 가상 광원 위치에 따라 달라진다. 이런 의미에선 훨씬 유연한 응용이 가능하게 될지 모른다.

연구팀은 이 기술이 640×640 픽셀 이미지라면 160ms면 처리할 수 있는 만큼 스마트폰 화면에서 실시간으로 볼 수 있다고 말한다. 하지만 최신 스마트폰이라면 이미지 1개가 1,200만 화소인 것도 있어 단순 계산으론 640×640보다 30배에 달한다. 1차 처리에만 5초 가까이 걸리는 것이다. 구현에 이 같은 무거운 처리 과정이 들어가는 건 남은 과제라고 할 수 있다. 관련 내용은 이곳에서 확인할 수 있다.