미국 캘리포니아대학 샌프란시스코캠퍼스(UCSF) 연구팀이 뇌 신호를 음성으로 변환하는 내장 인터페이스를 발표했다.

이 연구는 심한 마비를 앓은 환자의 대화를 돕기 위한 시스템을 향한 첫 걸음이라고 할 수 있다. 지금은 말하는 능력을 잃은 환자가 의사를 표시하려면 특별한 노력이 필요하다. 하지만 미래에는 이 같은 기술을 통해 개선될 수도 있다.

UCSF 연구팀은 이미 수술을 받은 환자 5명에게 100가지 문구를 말하게 하고 이 때의 뇌 신호를 기록했다. 이 신호 데이터를 인간의 음성 시스템으로 재현하는 컴퓨터 모델에 입력한 결과 절반은 명료한 음성이 합성됐다는 것이다.

이 연구의 특징은 기존처럼 추상적인 생각이 아니라 인간이 특정 음성을 말할 때 발화하는 신경신호를 포착했다는 것이다. 다시 말해 뇌 신호와 이로 인해 움직이는 성대의 움직임을 재현한 것이다.

원리로는 뇌에서 팔다리 등 운동신경에 발생하는 신호를 포착하고 로봇팔을 제어하는 기술과 비슷한 접근이라고 할 수 있다. 연구팀은 이런 말하는 움직임을 제어하는 뇌 부분을 이용하는데 직접 말하는 게 아니라 움직임을 해독하려 했다면서 뇌파에서 단어로 변환하는 게 아니라 뇌 신호가 성대에 명령을 내리는 운동을 모방한 셈이라고 밝혔다.

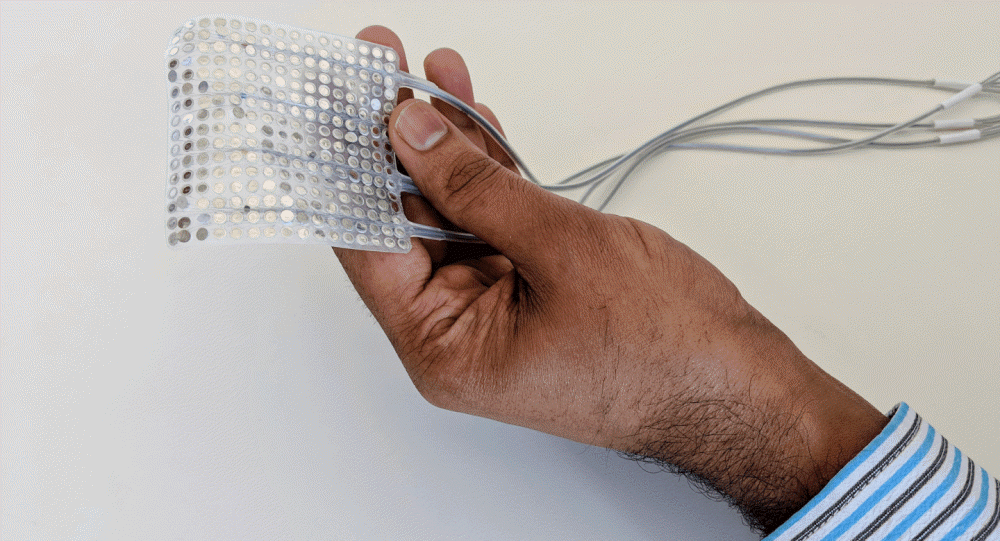

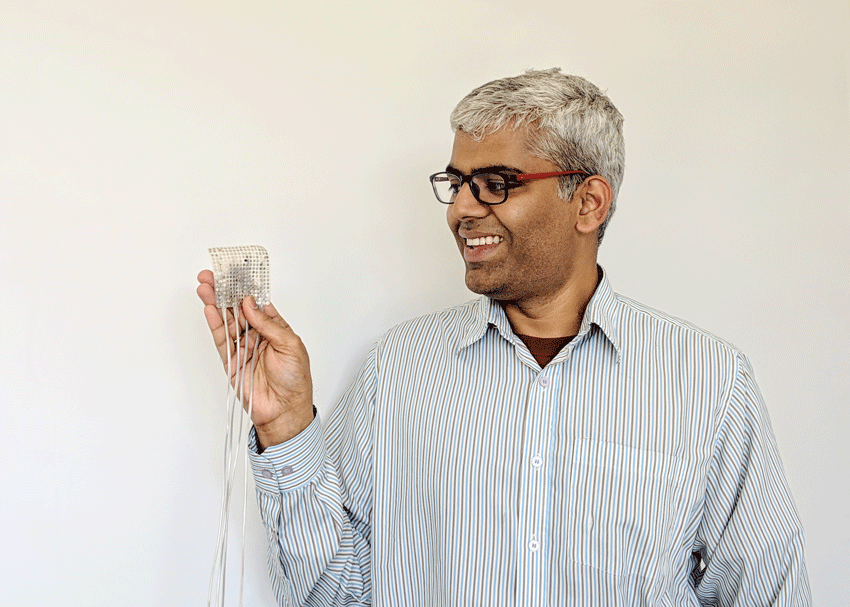

실제로 얼마나 일상 대화에서 이용할 수 있을지 합성 음성으로 테스트한 결과 평균 50∼70% 단어를 이해했다고 한다. 물론 이런 점에선 아직도 개선 여지가 있다고 할 수 있다. 이번 실험에선 신호는 뇌 표면에서의 신호 ECoG를 수집하는 유연한 전극패드를 이용했다. 전문가들은 뇌 조직에 프로브를 배치한다면 정확도는 훨씬 높아질 가능성이 있을 것으로 보고 있다.

지금도 후두와 성대를 잃은 사람이 소리를 말하게 해주는 인공 성대는 있지만 마비가 심하거나 근육을 움직이는 게 어렵다면 효율적이라고 할 수 없다. 환자 커뮤니케이션을 돕고 사회와의 관계 회복을 위해서라도 앞으로 연구 개발이 꾸준히 필요할 것으로 보인다. 관련 내용은 이곳에서 확인할 수 있다.