메타가 10월 18일 텍스트와 음성 모두를 입력할 수 있고 감정 표현을 동반한 음성 출력도 가능한 AI 모델인 스피릿LM(Spirit LM)을 출시했다.

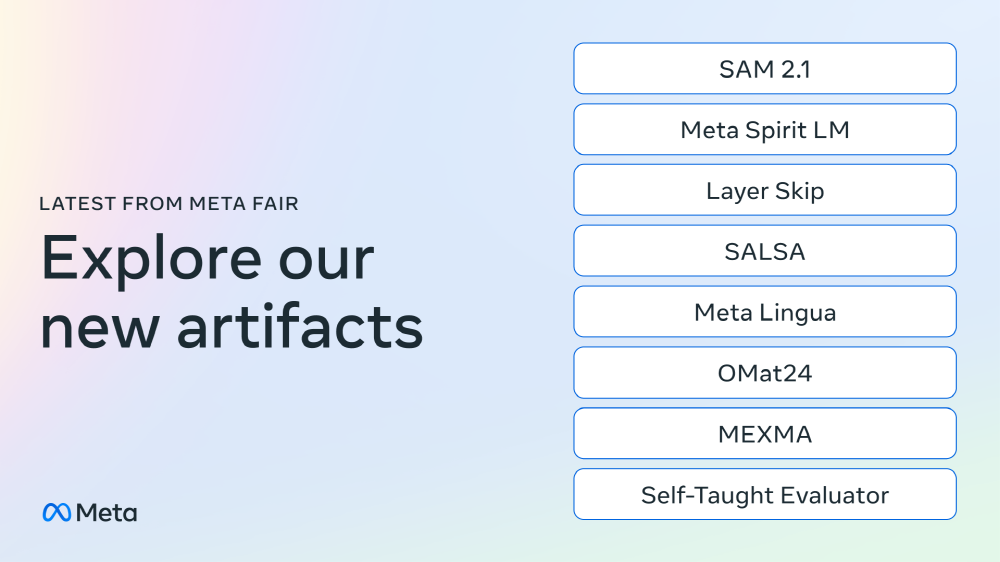

메타 FAIR(Fundamental AI Research) 팀은 고급 기계 지능(AMI) 실현을 위한 최신 연구 결과와 새로운 AI 모델을 공개하고 이미지와 동영상 세그멘테이션 모델인 SAM 2(Segment Anything Model 2) 업데이트 버전인 SAM 2.1(Segment Anything Model 2.1)을 출시했으며 포스트 양자 암호 표준 안전성 연구에 필요한 코드 ‘SALSA를 공유했다는 등 내용을 보고했다. 그 중에서 메타는 음성과 텍스트를 원활하게 통합할 수 있는 오픈소스 언어 모델 스피릿LM을 발표했다.

메타에 따르면 기존 음성으로 대화할 수 있는 AI는 입력된 음성을 자동 음성 인식(ASR)으로 문자화하고 문자화된 데이터를 바탕으로 대규모 언어 모델에서 텍스트를 생성한 뒤 최종적으로 텍스트 읽기 소프트웨어(TTS)를 사용해 음성으로 변환한다고 한다. 하지만 기존 프로세스에서는 생성되는 음성의 표현적 측면이 손상된다. 메타가 새롭게 개발한 스피릿LM은 텍스트와 음성을 한 모델에서 처리할 수 있어 ASR을 통한 문자화나 TTS를 통한 음성 변환 없이 음성으로 대화할 수 있게 한다.

스피릿LM을 실제로 사용한 데모 예시에서는 사람이 “1 2 3 4 5″라는 텍스트를 입력하면 스피릿LM이 그 뒤에 이어지는 숫자를 음성으로 출력한다. 또 “세계에서 가장 큰 나라는(The largest country in the world is)”이라는 텍스트 프롬프트에 대해 스피릿LM은 상세한 정보를 포함한 음성을 출력할 수 있다.

더불어 주어진 프롬프트를 바탕으로 마치 사람과 같은 감정 표현을 포함한 음성을 생성할 수도 있다.

스피릿LM은 음성 입력에 대해 텍스트로 응답할 수도 있다. 스피릿LM에 음성으로 “a b c d e”를 입력하면, “f g h i j k l m n o p q r s t u v w x y z”라는 텍스트가 반환된다.

Open science is how we continue to push technology forward and today at Meta FAIR we’re sharing eight new AI research artifacts including new models, datasets and code to inspire innovation in the community. More in the video from @jpineau1.

— AI at Meta (@AIatMeta) October 18, 2024

This work is another important step… pic.twitter.com/o43wgMZmzK

메타에 따르면 스피릿LM은 음성 및 텍스트 데이터셋에 대해 단어 수준 인터리브 학습으로 훈련됐으며 이를 통해 음성 입출력이라는 크로스 모달리티 생성을 가능하게 했다고 한다. 이를 실현하기 위해 메타는 음성을 모델링하기 위해 음성 토큰을 사용하는 스피릿 LM 베이스(Spirit LM Base)와 피치 토큰과 스타일 토큰을 사용해 흥분이나 분노, 놀람 등 톤에 관한 정보를 캡처하고 그 톤에 맞는 음성을 생성할 수 있는 스피릿LM 익스프레시브(Spirit LM Expressive)를 개발했다.

메타는 스피릿LM은 더 자연스러운 음성을 생성할 수 있으며 자동 음성 인식, 텍스트 읽기, 음성 분류 등 모달리티 전체에서 새로운 태스크를 학습하는 능력을 갖추고 있다며 이 연구가 더 큰 연구 커뮤니티를 자극하고 음성과 텍스트 통합을 계속 발전시키기를 바란다고 말했다. 관련 내용은 이곳에서 확인할 수 있다.