AI 연구 개발이 빠르게 진행되는 가운데 AI용 GPU를 개발하는 엔비디아도 주목받고 있다. 하지만 AI 연구 개발이나 운용에 GPU가 사용되고 있다는 건 알고 있어도 어떤 GPU가 어떤 규모로 사용되고 있는지는 이미지화하기 어렵다.

AI 서비스를 제공하려면 필요 데이터를 수집해 모델 데이터를 구축하는 학습, 모델 데이터에 프롬프트를 입력해 출력을 생성하는 추론 2가지 종류 계산 처리를 해야 한다. 예를 들어 이미지 생성형 AI는 대량 이미지나 이미지 설명을 바탕으로 모델 데이터를 구축하는 계산 처리가 학습으로, 모델 데이터를 사용해 이미지를 생성하는 계산 처리가 추론이다. 이런 학습이나 추론에는 방대한 계산 처리를 병렬 실행할 필요가 있기 때문에 CPU보다 코어수가 많은 GPU가 효율적으로 계산을 실행할 수 있다.

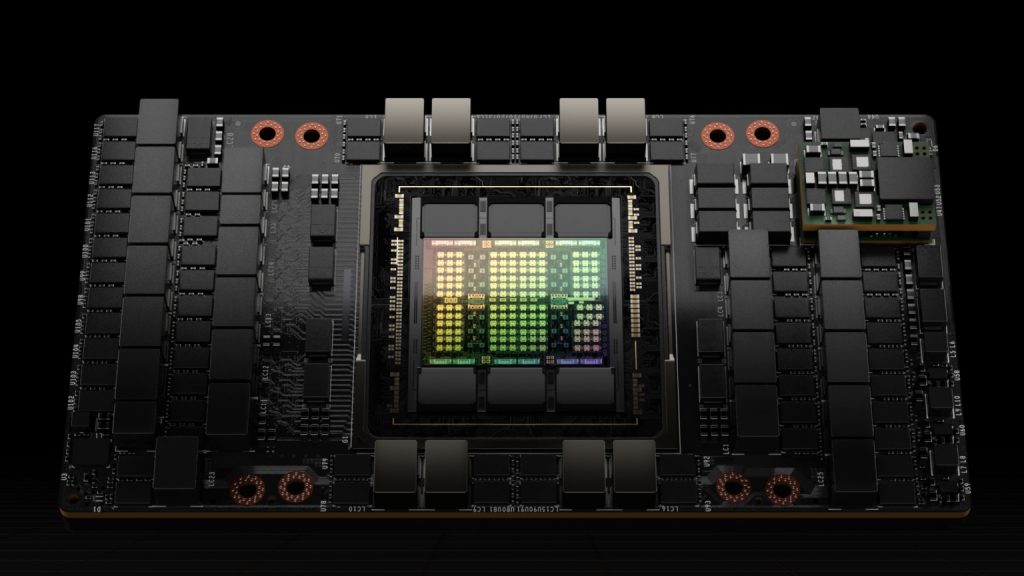

소규모 모델 데이터 학습이나 추론이라면 게이머용으로 출하되는 GPU에서도 실행 가능하지만 게임용 GPU는 어디까지나 게임 관련 처리에 최적화되어 있기 때문에 최대 효율을 발휘할 수 없다. 따라서 엔비디아는 암페어(Ampere)와 호퍼(Hopper) 같은 AI 하급과 추론에 최적화된 아키텍처를 개발하고 암페어를 채용한 A100과 호퍼를 채용한 H100과 같은 AI 특화 GPU를 제품화했다.

엔비디아는 H100 가격을 공표하지 않지만 뉴욕타임즈는 H100 가격을 대당 2만 5,000달러라고 보고하고 있다. H100은 가치가 너무 높아 수송에는 장갑차가 사용된다고 한다.

엔비디아는 AI 특화 GPU 뿐 아니라 AI 특화 GPU에 CPU나 메모리, 스토리지 등을 조합한 AI 시스템인 DGX도 개발하고 있다. DGX H100에는 H100 8대가 탑재되어 초당 900GB로 데이터를 전송할 수 있는 GPU 메모리 640GB가 탑재되어 있다. 또 x86 CPU 2대, 시스템 메모리 2TB, 스토리지는 30TB를 탑재하고 있다.

더구나 엔비디아는 DGX 32개를 포함한 AI 인프라를 DGX 슈퍼팟(SuperPOD)도 개발하고 있다. 현재 DGX 슈퍼팟에는 DGX A100을 채택한 모델과 DGX H100을 택한 모델 2종이 있다. 다시 말해 DGX H100을 채용한 DGX 슈퍼팟에는 대당 3,700만 원대 H100 256대가 탑재되고 있다는 얘기다.

엔비디아는 이미 H100 2배 추론 성능을 갖춘 H200을 개발하고 있어 2024년 중 출하 개시를 발표하고 있다. 또 엔비디아 경쟁자인 AMD도 AI 특화 GPU 개발을 진행하고 있으며 2023년 12월에는 H100 1.6배 성능을 갖춘 AI 특화 GPU인 인스틱트 MI300(Instinct MI300)을 발표하고 있다.