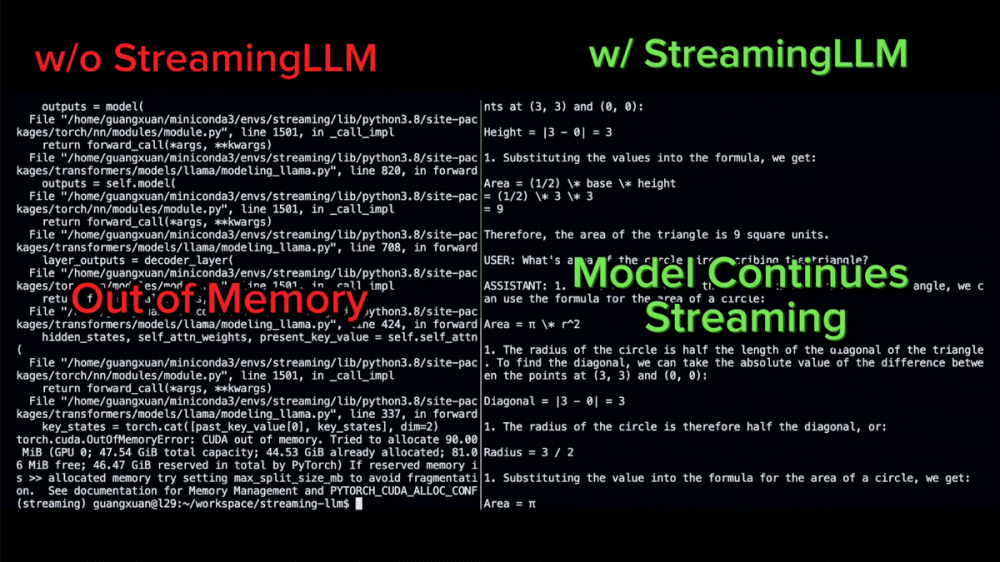

계산 비용과 성능을 유지한 채 무한 입력을 처리할 수 있는 대규모 언어 모델 기법인 스트리밍LLM(StreamingLLM) 논문이 9월 29일 공개됐다. 입력이 길어지면서 첫 번째 정보는 손실되기 때문에 책 요약 등 작업에는 적합하지 않지만 대화가 길어도 성능을 유지하면서 원활하게 답변할 수 있게 되어 있다.

스트리밍LLM을 통합하면 LLaMA-2, MPT, 팔콘, 피티아(Pythia) 등 대규모 언어 모델에서 400만 토큰 이상 길이 문장을 처리할 수 있다. 또 사전 학습을 할 때 어텐션 싱크(attention sink)로 플레이스홀더 토큰을 준비하면 새로운 속도 향상을 확인할 수 있었다고 한다.

덧붙여 긴 문장 입력이 가능하게 된다고 해도 문맥상 제한은 바뀌지 않는다. 예를 들어 LLaMA-2를 4096 토큰 컨텍스트 길이로 사전 학습하면 스트리밍LLM을 사용해도 최대 캐시 크기는 4096 토큰으로 남으며 부족한 부분은 중간 토큰을 폐기해 대응한다.

스트리밍LLM은 장기 기억을 강화하는 구조가 아니기 때문에 책처럼 긴 텍스트 용약 태스크를 하는 경우 마지막 부분을 요약할 가능성이 높다고 한다. 한편 이메일 어시스턴트 등 과거 데이터가 불필요한 모델을 계속 동작시키고 싶을 때 적절한 방법이다. 대화 길이가 컨텍스트 길이를 초과하는 경우에도 계속 작동할 수 있다. 관련 내용은 이곳에서 확인할 수 있다.