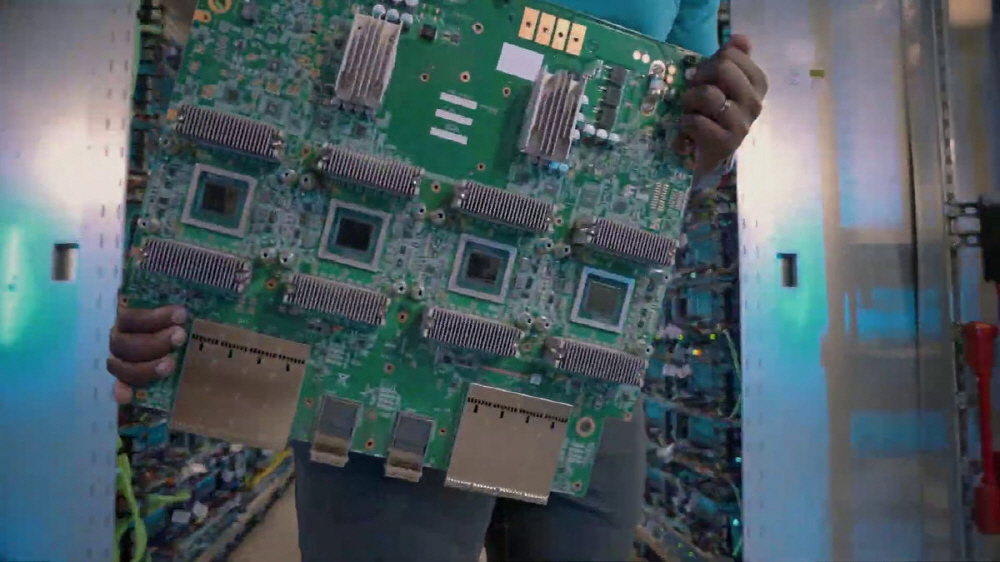

구글이 8월 30일 독자 개발하는 기계학습 특화 프로세서인 TPU(Tensor Processing Unit) 5세대 모델인 TPU v5e를 발표했다. 구글은 대규모 언어 모델이나 생성형 AI 등 AI를 구축하기 위한 비용 효율과 성능이 뛰어난 프로세서라며 TPU v5e를 어필하고 있다.

TPU v5e는 중형이나 대규모 학습, 추론에 필요한 비용 효율성과 성능 양립을 위해 구축된 차세대 TPU다. 1세대 이전 모델인 TPU v4에 비해 대규모 언어 모델, 생성형 AI 모델은 달러당 최대 2배 학습 성능과 달러당 최대 2.5배 추론 성능을 실현할 수 있다. TPU v5e를 이용해 더 많은 조직이 TPU v4를 이용할 때보다 절반 이하 비용으로 대규모이면서 복잡한 AI 모델을 학습, 전개할 수 있다.

비용 면에서 혜택을 누리기 위해 성능과 유연상을 희생하지 않고 성능, 유연성, 효율성간 균형을 맞춰 최대 256개 칩을 400Tb/sec 이상 대역폭과 100PetaOPS에서 상호 연결할 수 있다. TPU v5e는 다목적이며 단일 슬라이스 내 1개 칩에서 250개 이상 칩에 이르기까지 서로 다른 가상머신 8개 구성을 지원한다. 이를 통해 사용자는 광범위한 LLM과 생성형 AI 모델 크기를 지원할 수 있다.

TPU v5e는 허깅페이스와 트랜스포머, 액셀러레이트, 파이터치 라이트닝, 레이 등 인기 오픈소스 도구 외에도 JAX, 파이터치, 텐서플로 등 주요 AI 프레임워크 내장 지원도 제공한다. 또 차기 파이터치/팀 2.1 릴리스에서 파이터치 지원을 더 강화하는 것도 발표했다. 이 업데이트에는 TPU v5e 지원과 대규모 모델 학습을 위한 모델, 데이터 병렬 처리 같은 새로운 기능이 포함된다.

또 학습 작업 확장을 용이하게 하기 위해 멀티 슬라이스 기술을 테스트 도입한다. 이를 통해 사용자는 물리적인 TPU 포드 경계를 넘어 AI 모델을 최대 수만 개 TPU v5e 또는 TPU v4로 쉽게 확장할 수 있다. 지금까지 TPU를 이용한 학습 작업은 TPU 1개 슬라이스로 제한됐으며 TPU v4의 경우 최대 슬라이스 크기가 3,072칩으로 제한됐으며 이에 따라 최대 작업 크기도 제한됐다. 멀티 슬라이스를 이용하면 개발자는 단일 포드 내 칩간 상호 연결 또는 데이터센터 네트워크 여러 포드에 걸쳐 워크로드를 최대 수만 개 칩까지 확장할 수 있다. 이 멀티 슬라이스 기술은 구글 첨단 PaLM 모델을 만드는 데에도 사용된다.

구글은 구글 클라우드 고객에게도 제공할 수 있게 되어 기쁘게 생각한다고 밝히고 있다. 구글 클라우드는 엔비디아와 함께 폭넓은 워크로드로 AI를 더 이용하기 쉽게 엔비디아 L4 GPU를 탑재한 클라우드 VM인 G2 VM을 제공한다. 이 하이엔드 클라우드 VM으로 구글 클라우드는 A3 VM을 발표했다. A3 VM은 엔비디아 H100 텐서 코어 GPU를 탑재한 모델로 요구가 엄격한 생성형 AI 워크로드나 LLM 학습에 전용 구축된 VM이다. 엔비디아 GPU와 구글 클라우드 첨단 인프라 기술을 결합해 대규모와 성능을 제공해 이전 세대보다 학습 속도 3배, 네트워크 대역폭 10배를 제공한다. A3은 또 대규모 운용이 가능해 모델을 수만 개 엔비디아 H100 GPU로 확장할 수 있다. A3 VM은 4세대 인텔 제온 확장 가능 프로세서, VM당 8개 엔비디아 H100 GPU, 2TB 호스트 메모리를 갖추고 있다. 최신 엔비디아 HGX H100 플랫폼 위에 구축된 A3 VM은 4세대 엔비디아 NV링크 기술로 GPU 8개간에 3.6TB/sec 대역폭을 실현했다. 네트워크 대역폭 향상은 타이타니움 네트워크 어댑터와 엔비디아 NCCL(NVIDIA Collective Communications Library) 최적화를 통해 이뤄진다. 전체적으로 A3 VM은 첨단 AI 모델 구축을 목표로 하는 기업 등에 있어 큰 도움이 될 수 있다. 관련 내용은 이곳에서 확인할 수 있다.

한편 구글 AI 연구 부문인 구글 딥마인드는 8월 29일 AI에서 생성된 이미지에 워터마크를 넣어 AI가 생성한 이미지라는 걸 명시해 가짜 이미지 확산을 방지하는 도구인 SynthID 베타 버전을 발표했다. 현재 구글 기계학습 플랫폼인 Vertex AI 이미지 생성 AI(Imagen)에서만 사용할 수 있다.

구글 딥마인드와 구글 클라우드가 공동 개발한 SynthID는 AI가 생성한 이미지 픽셀에 전자 워터마크를 넣어주는 도구다. 구글은 지난 5월 열린 개발자 회의 구글 I/O 기간 중 AI가 생성한 이미지에 전자 워터마크를 추가하는 도구 발표를 예고한 바 있다. SynthID는 이미지에 인간 눈으로 식별할 수 없는 전자 워터마크를 포함시켜준다. SynthID를 이용한 전자 워터마크는 이미지에 필터 추가. 색상 변경, 트리밍, 압축 등 편집을 적용해도 그대로 유지된다. 또 SynthID 전자 워터마크는 이미지 픽셀에 포함되어 있기 때문에 메타 데이터를 분실하거나 삭제해도 그대로 유지된다고 한다. 관련 내용은 이곳에서 확인할 수 있다.

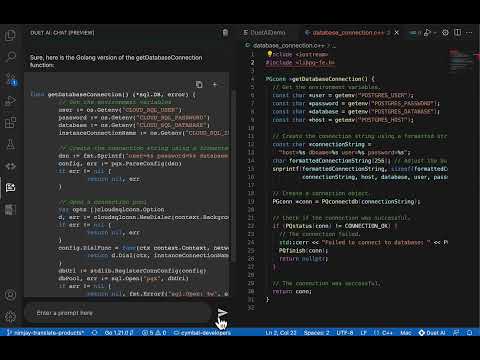

구글은 또 작업 보조 AI 서비스 그룹인 듀엣 AI(Duet AI) 프리뷰 버전을 구글 클라우드에 도입했다고 발표했다. 듀엣 AI에는 코딩이나 데이터 해석 등에 도움이 되는 AI가 포함되어 있으며 현재 무료로 테스트해볼 수 있다.

구글은 구글 문서로 텍스트를 보완할 수 있는 AI와 구글 스프레드시트에서 데이터를 분석하는 AI 등 작업 보조 시스템 AI를 정리해 듀엣AI로 칭하고 있다. 8월 30일에는 코딩 보조 AI나 데이터 분석 보조 AI 등 듀엣 AI 제품군 프리뷰 버전이 구글 클라우드에서 사용 가능하게 됐다.

구글이 밝힌 듀엣 AI 내에서 가능한 주요 작업을 보면 먼저 코드 리팩토링. 듀엣 AI를 이용하면 자연어로 지시하는 것만으로 코드 리팩토링이 가능하다. 예를 들어 이 함수를 Go로 재작성하면서 클라우드 SQL을 사용하도록 바꾸라는 문장을 입력하면 AI가 코드를 수정하게 할 수 있다.

다음은 오류 수정. 듀엣 AI는 구글 클라우드 로그 탐색기에도 내장되어 있으며 오류에 대한 자세한 설명을 자연어로 출력하거나 오류 수정 방법을 제안할 수 있다.

다음은 데이터 분석. 듀엣 AI를 이용하면 고객 데이터를 10개 세그먼트로 나누라는 문장만 입력해도 빅쿼리(BigQuery) 데이터를 분석하는 코드를 생성할 수 있다. 또 듀엣 AI를 이용해 데이터를 기반으로 그래프와 컬러맵 등을 생성할 수 있다.

다음은 데이터베이스 고속화. 듀엣 AI에선 자연 언어로 지시를 해 SQL문을 생성하는 것도 가능하다. 스패너(Spanner)에선 이미 듀엣 AI를 이용할 수 있으며 알로이DB(AlloyDB0와 클라우드 SQL에서도 듀엣 Ai를 이용할 수 있다.

마지막은 보안 강화. 듀엣 AI는 구글 보안 제품(Chronicle Security Operations, Security Command Center)에 통합되어 있으며 다른 제품(Mandiant Threat Intelligence)에도 통합되어 있다. 이를 통해 보안 관리자는 위협 정보 요약을 탐색하고 문제 해결 방법에 대한 조언을 얻을 수 있다. 관련 내용은 이곳에서 확인할 수 있다.

구글은 그 밖에 PostgresSQL 호환 데이터베이스 서비스인 알로이DB에 AI를 도입하는 게 가능한 세트인 알로이DB AI(AlloyDB AI)를 발표했다. AI를 도입한 알로이DB AI는 AlloyDB for PostgreSQL에 통합된 기능 세트로 개발자가 독자 데이터를 사용해 생성형 AI 애플리케이션을 구축하는 걸 지원한다. 대규모 언어 모델과 실시간 운영 데이터를 더 쉽고 효율적으로 결합하면 표준 PostgreSQL과 최대 10배 빠른 속도로 벡터 쿼리를 실행할 수 있다.

간단한 PostgreSQL 함수를 도입해 임베디드 데이터를 손쉽게 생성하고 SQL 한 줄로 낮은 대시간으로 데이터베이스 내에서 임베디드를 생성하는 로컬 모델에 액세스하는 등 추가 비용 없이 모든 알로이DB에서 이용 가능하게 될 예정이다. 현재 기술 프리뷰에서 퍼블릭 프리뷰로 이행한 알로이DB 다운로드 버전인 알로이DB 옴니(AlloyDB Omni)를 통해 프리뷰가 가능하며 올해 말에는 알로이DB 매니지드 서비스로 제공할 예정이다.

또 올해 말 등장 예정인 구글 기계학습 도구 확장판인 버텍스AI 익스텐션(Vertex AI Extensions)이나 언어 모델 지원 앱 개발 라이브러리(LangChain)를 포함한 AI 생태계 통합도 가능하다. 한편 이들 제품이나 서비스는 8월 30일부터 개최된 구글 클라우드 기술 행사(Google Cloud Next ’23) 기간 중 발표된 것이다. 관련 내용은 이곳에서 확인할 수 있다.