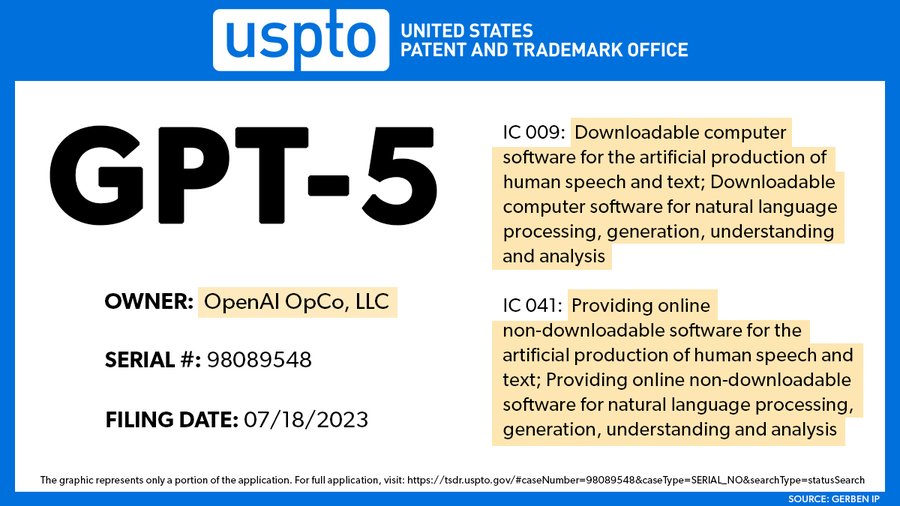

대규모 언어 모델인 GPT-4를 개발하는 오픈AI가 미국특허상표청 USPTO에 GPT-5 상표 등록을 출원한 게 USPTO 데이터베이스를 통해 판명됐다. 이에 따르면 상표 출원은 2023년 7월 18일로 데이터베이스에 등록된 건 2023년 8월 1일이었다. 출원자는 오픈AI로 언어 모델을 사용하기 위한 다운로드 가능한 컴퓨터 프로그램 및 다운로드 가능한 소프트웨어, 인간 음성과 텍스트를 인공적으로 생성하기 위한 다운로드할 수 있는 컴퓨터 프로그램 및 다운로드 가능한 소프트웨어, 자연언어 처리와 생성, 이해, 부넉을 위한 다운로드 가능한 컴퓨터 프로그램 및 다운로드 가능한 소프트웨어 등에서 신청됐다.

오픈AI가 현재 공개하고 있는 대규모 언어 모델 GPT 최신 버전은 GPT-4로 GPT-5에 대해선 발표되지 않은 상태다. 오픈AI 샘 알트만 CEO는 지난 4월 오픈AI가 GPT-5 학습을 하지 않았다며 GPT-4를 뛰어넘는 강력한 AI 개발을 급격하게 진행하는 위험성에 대해 우려를 표명하기도 했다.

한편 한 기업가는 2023년 12월 학습을 완료할 예정이며 오픈AI가 GPT-5로 범용 인공지능, AGI를 달성할 것으로 기대하고 있는 것 같다고 밝히고 있다. 물론 이에 대한 확실한 신뢰가 있는 발언은 아니지만 GPT-5가 AGI라는 수준에 이르고 있다면 복잡한 인지 태스크를 자동화하는 것으로 AI 생산성이 대폭 향상될 것으로 기대할 수 있다.

보도에선 상표 출원 서류에는 GPT-5를 개발하고 있는 걸 확인할 수 있는 내용은 없다며 오픈AI가 미래에는 더 고도의 대규모 언어 모델 개발을 계획한다고 해도 이상할 건 없지만 이번 상표 출원 주요 목적은 GPT-5라는 명칭을 타인이 사용할 수 없게 하기 위해서일 가능성이 있다고 밝혔다. 관련 내용은 이곳에서 확인할 수 있다.

한편 방대한 데이터로 학습한 GPT-3이나 바트 등 대규모 언어 모델은 기본적으론 문장 배열 방법에 확률을 할당해 다음에 오는 자연스러운 단어를 예측하는 모델이다. 그런데 대규모 언어 모델은 마치 인간처럼 자연스러운 문장을 생성할 수 있는 것 외에 이미지 생성이나 단백질 입체 구조 예측 등 다양한 작업에도 응용하는 것으로 알려져 있다.

캘리포니아대 LA 연구팀은 GPT-3은 특정 정보를 다른 것에 적용해 대답을 추측하는 유추 태스크에서 대학생을 능가하는 점수를 기록했다는 연구 결과를 발표했다.

연구팀은 GPT-3이 갖는 유추 능력이 얼마나 되는지 조사하기 위해 도형 문제를 GPT-3이 처리할 수 있도록 텍스트로 변환한 문제나 SAT에 포함되는 문제 등 다양한 형식 유추 문제를 해결했다.

도형 문제 해답을 GPT-3과 캘리포니아대 LA 학생을 비교하자 대학생 평균 정답률이 60%였던 데 비해 GPT-3은 이를 초과하는 80%를 기록했다고 한다. 또 SAT 점수를 대학 지원자와 비교한 결과 역시 GPT-3 쪽이 더 뛰어난 결과를 보였다. 연구팀은 이런 결과는 GPT-3이 다른 영역간에 유연하게 일반화할 수 있는 추상 개념을 개발한 걸 시사하고 있다고 밝혔다.

반면 GPT-3응 문제가 제시됐다고 인식하지 못할 수 있으며 응답을 입력하라는 메시지가 포함되지 않거나 질문이 문장이 아닌 숫자로 주어지면 오류율이 높다는 문제도 있었다고 한다. 또 단 하나 이야기를 읽고 이와 비슷한 내용을 담은 이야기를 2가지 선택에서 고르거나 짧은 이야기에서 교훈을 읽고 해결책이 없는 문제에 대한 답을 내는 등 이야기 요점을 추출하는 작업에선 GPT-3보다 인간이 더 뛰어났다. 물리적 솔루션을 만들어내는 작업에서 GPT-3은 물리적으로 불가능한 대답을 내는 경향도 보였다. 이는 GPT-3이 주어진 문장에서 유추할 수는 있지만 문제에 포함되지 않은 영역 지식으로부터 유추를 작동시킬 수 없다는 걸 시사한다. 그럼에도 불구하고 GPT-3보다 성능이 높아진 GPT-4를 사용해 몇 가지 예비 테스트를 실시한 결과 GPT-3보다 훨씬 뛰어난 결과를 냈다. 따라서 미래에는 대규모 언어 모델이 이야기를 읽을 때 인간을 능가할 수 있다는 것이다.

연구팀은 이번 연구 결과가 뛰어나더라도 대규모 언어 모델에는 큰 한계가 있다고 강조하는 게 중요하다며 대규모 언어 모델은 유추할 수 있지만 도구를 이용해 물리적 과제를 해결하는 등 인간에게는 그리 간단할 수 없다고 밝히고 있다. 연구팀은 앞으로 대규모 언어 모델이 실제로 인간 같은 사고를 하는지 아니면 단순히 인간 사고를 모방하는 완전히 다른 절차를 실행하고 있는지 조사하고 있다. 연구팀은 GPT-3은 인간처럼 생각하고 있을지 모른다며 방법은 GPT-3과 인간이 완전히 다르다며 GPT-3이 진정으로 인간 같은 방식으로 생각하는지 아니면 완전히 새로운 방식으로 생각하는지 알고 싶다고 밝히고 있다. 관련 내용은 이곳에서 확인할 수 있다.