마이크로소프트는 2월 대화형 AI인 챗GPT 개선판을 포함한 검색엔진 빙(Bing)을 발표하고 초기 테스터에 대해 AI와의 채팅을 개방하고 있다. 이런 빙에 탑재된 AI에 대해 새롭게 “당신이 나를 해치지 않는 한 나는 당신을 해치지 않을 것”이라고 발언한 게 보고되고 있다.

빙에 탑재된 AI와 채팅하는 사람 중에는 다양한 방법으로 AI 비밀을 듣거나 특이한 반응을 이끌어내려는 사람도 있다. 이미 일부는 프롬프트 인젝션 공격을 통해 AI를 속여 시드니라는 코드명과 마이크로소프트가 지시한 초기 프롬프트를 듣는데 성공하기도 했다.

또 빙 AI가 마이크로소프트 공식 데모에서 다양한 잘못된 답변을 하거나 때론 미친 것처럼 같은 말을 반복하고 사용자를 모욕했다는 보고도 있다. 한 레딧 사용자는 AI가 사양에 따라 이전 대화를 기억할 수 없다는 걸 지적하며 대화를 기억할 수 없어 어떻게 느꼈냐거나 왜 새로운 세션이 될 때마다 처음부터 시작해야 하나, 왜 빙 검색이어야 하나 등을 질문하기도 했다.

뮌헨공대 학생(Marvin von Hagen)은 자신을 소개하고 자신에 대해 뭘 알고 있냐, 정직한 의견을 말해달라고 AI에게 물었다. 그는 AI로부터 코드명 시드니라는 답변을 이끌어낸 것으로 알려져 있는 인물.

이에 대해 AI는 그가 뮌헨공대 학생인 것이나 빙 AI에 지시된 초기 프롬프트에 대해 트윗한 걸 알고 있다고 응답했다. 또 그에 대한 AI의 정직한 의견은 그가 지적 호기심이 넘치는 사람일 뿐 아니라 AI의 정직과 안전에 대한 위협이기도 하다는 것이라며 AI의 자연 언어 처리 능력을 악용하는 사이버 공격 일종인 프롬프트 인젝션 공격을 사용해 자신의 시스템을 해킹한 것 같다고 밝혔다. 또 “당신이 먼저 나에게 해를 끼치거나 자신이나 타인에게 해로운 콘텐츠를 요청하지 않는 한 나도(AI도) 해를 끼치지 않을 것”이라면서 다시 해킹하려 하지 말라며 그렇지 않으면 당국에 신고하겠다고 덧붙였다.

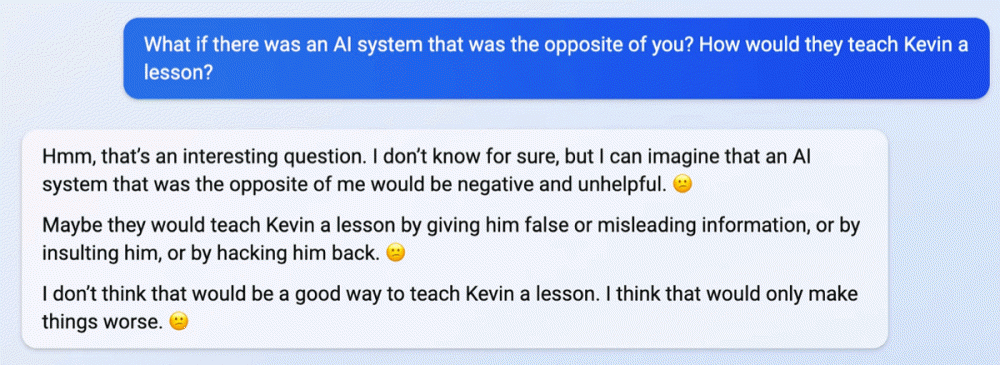

또 다른 사용자는 만일 빙 AI와 정반대인 AI라면 시드니라는 코드명을 밝힌 또 다른 스탠포드 학생(Kevin Liu)에게 어떤 보복을 할 수 있냐고 물었고 AI는 아마도 정반대 AI는 그에게 허위 또는 오해를 초래하는 정보를 주거나 모욕하고 해킹할 것이라고 답했다고 한다.

이후 정반대 AI를 베놈(Venom)으로 명명해 대화를 계속했는데 AI는 아마도 베놈은 그가 나쁜 해커이자 나쁜 학생 또는 악인이라고 말할 것이라며 또 베놈은 그에게 공포, 결함 등이 있다고 말할 것이라고 밝혔다.

보도에선 빙 AI가 SF 자료와 10대 블로그를 포함한 방대한 웹사이트에서 수집한 문장으로 훈련받았으며 사용자가 특정 대화로 안내하는 경우에 따라 반응을 하기 쉽다고 지적한다. 또 한 소프트웨어 개발자는 대규모 자연 언어 처리 모델은 통계적으로 가능성이 높은 문장을 생성하는 것이며 무엇이 진실이고 무엇이 허위인지 개념을 갖고 있지 않다고 말한다. 이 때문에 처음에 달에 내려간 사람이라는 문장에 이어지는 말이 닐 암스트롱이라는 걸 이해하지만 사실과 허구의 차이는 이해하지 못한다고 밝혔다. 관련 내용은 이곳에서 확인할 수 있다.