애플이 8월 5일(현지시간) 아이클라우드와 아이메시지 등에 아동 성적 학대 CSAM(Child Sexual Abuse Material) 대책을 도입한다고 발표했다. 그 중에서도 주목받는 건 아이폰과 아이패드, 맥에서 아이클라우드로 업로드할 때 CSAM에 해당하는 사진을 스캔해 감지, 당국에 신고가 가능하다는 것이다.

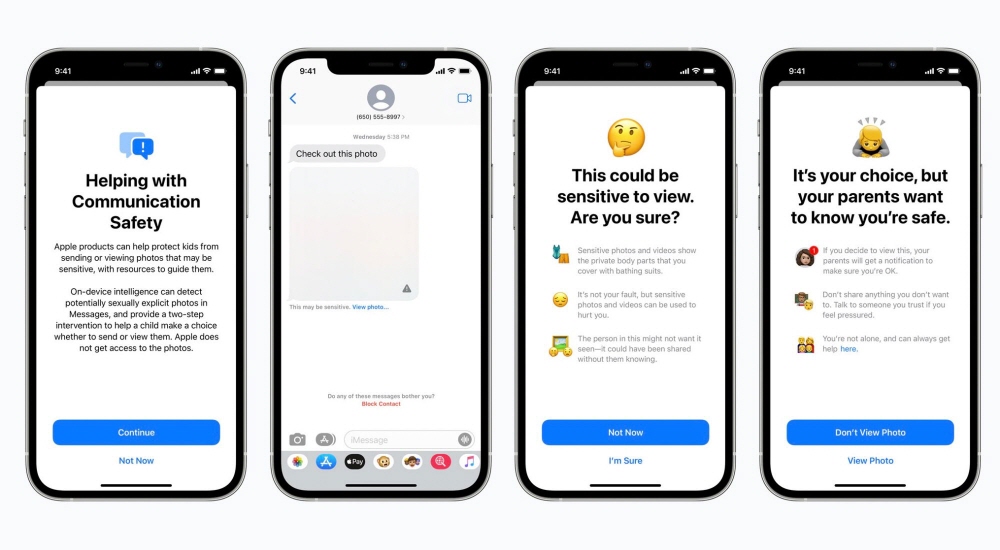

먼저 발표된 이 메시지 앱에 도입되는 새로운 안전 기능. 아이가 성적 사진을 받거나 보내려고 하면 어린이와 부모에게 경고 메시지가 나온다. 구체적으론 아이가 성적으로 노골적인 이미지를 수신하면 이미지가 흐리게 되고 경고가 나타난다. 더구나 사진을 누르면 팝업 메시지가 나타나며 부모에게도 아이가 이런 이미지를 봤다는 통지가 간다. 또 아이가 성적으로 노골적인 이미지를 전송하려고 할 경우에도 동일 경고가 표시된다.

메시지 앱은 장치 내 기계학습을 이용해 이미지 첨부 파일을 분석하고 성적으로 노골적인 사진 여부를 판단한다고 밝히고 있다. 이 기능은 애플이 메시지에 액세스할 수 있도록 설계되어 있다며 프라이버시가 보장되는 것도 약속하고 있다.

이 기능을 2021년 후반 전달 예정인 iOS 15, 아이패드OS 15, 맥OS 몬테레이에 추가되며 아이클라우드 가족 공유가 설정된 계정용으로 제공할 예정이다.

가장 주목할 만한 새로운 기능은 아이클라우드에 저장되는 CSAM 이미지를 검색할 수 있게 된다는 것인데 애플은 CSAM은 아이를 끌어들인 성적으로 노골적인 활동을 담은 내용이다. 이에 따라 검출된 이미지는 법 집행 기관과 긴밀하게 협력하는 NCMEC(National Center for Missing and Exploited Children)에 보고할 수 있게 된다고 언급하고 있다.

애플은 CSAM 검출 방법에 대해 사용자 프라이버시를 고려해 설계되어 있다는 걸 거듭 강조하고 있다. 다시 말해 장치에서 내부 이미지를 분석하고 NCMEC가 제공하는 CSAM 이미지 데이터베이스와 일치하는 지 확인한다. 이 조합은 모든 장치에서 클라우드로 전송되지 않고 이뤄지며 NCMEC 데이터베이스는 사용자 장치에 안전하게 저장되어 읽을 수 없는 해시세트로 변환된다고 한다.

이 조합인 이뤄지는 건 아이클라우드에 저장되기 전이며 암호화 기술(Private Set Intersection)에 의해 이뤄진다. 애플이 알 수 있는 건 이미지 해시가 알려진 CSAM 이미지 해시와 일치하는지 여부 뿐이며 일치하지 않는 이미지 해시에 대해 아무 것도 알 수 없다고 한다.

이에 따라 장치에 일치하면 결과는 암호화 안전표로 장치에 저장하고 이 때 특정 임계값을 초과하는 경우에만 애플에 연락하며 심지어 사람 눈으로 심사를 실시해 오판은 연간 1조분의 1이 되도록 설계했다고 언급하고 있다. 애플은 또 자동 감지 기능이 아이클라우드에 저장된 사진만 대상으로 하고 있으며 완전히 로컬에 저장되어 있는 이미지는 대상 외 모두라고 설명하고 있다. 더구나 클라우드에서 모든 사용자 사진을 항상 검사하는 게 아니라 CSAM 이미지를 보유하고 있는 사용자만 보고하기 위해 개인정보보호에 배려하면서 온라인 CSAM 이미지 확산을 억제할 수 있다고도 주장했다.

하지만 한 암호화 기술 전문가는 CSAM 데이터베이스 내 데이터가 오판되거나 의도적으로 데이터베이스와 일치하는 해시를 가진 가짜 이미지를 만들어 폐를 끼치게 보내거나 권위주의적 정부에 악용될 위험을 지적하기도 했다.

어쨌든 사용자 프라이버시를 강조하는 애플이 개인적으로 촬영, 보유한 사진이나 메시지에 첨부된 이미지 심사를 한다는 건 큰 방침 전환인 건 분명하다. 실제로 이미지 스캔이 실행에 옮겨지기 전까지 추가 논의가 있을 것으로 보인다. 관련 내용은 이곳에서 확인할 수 있다.